[!重要]

このリポジトリは、ツールの重複を避けるために

🚀 Memgraph MCP サーバー

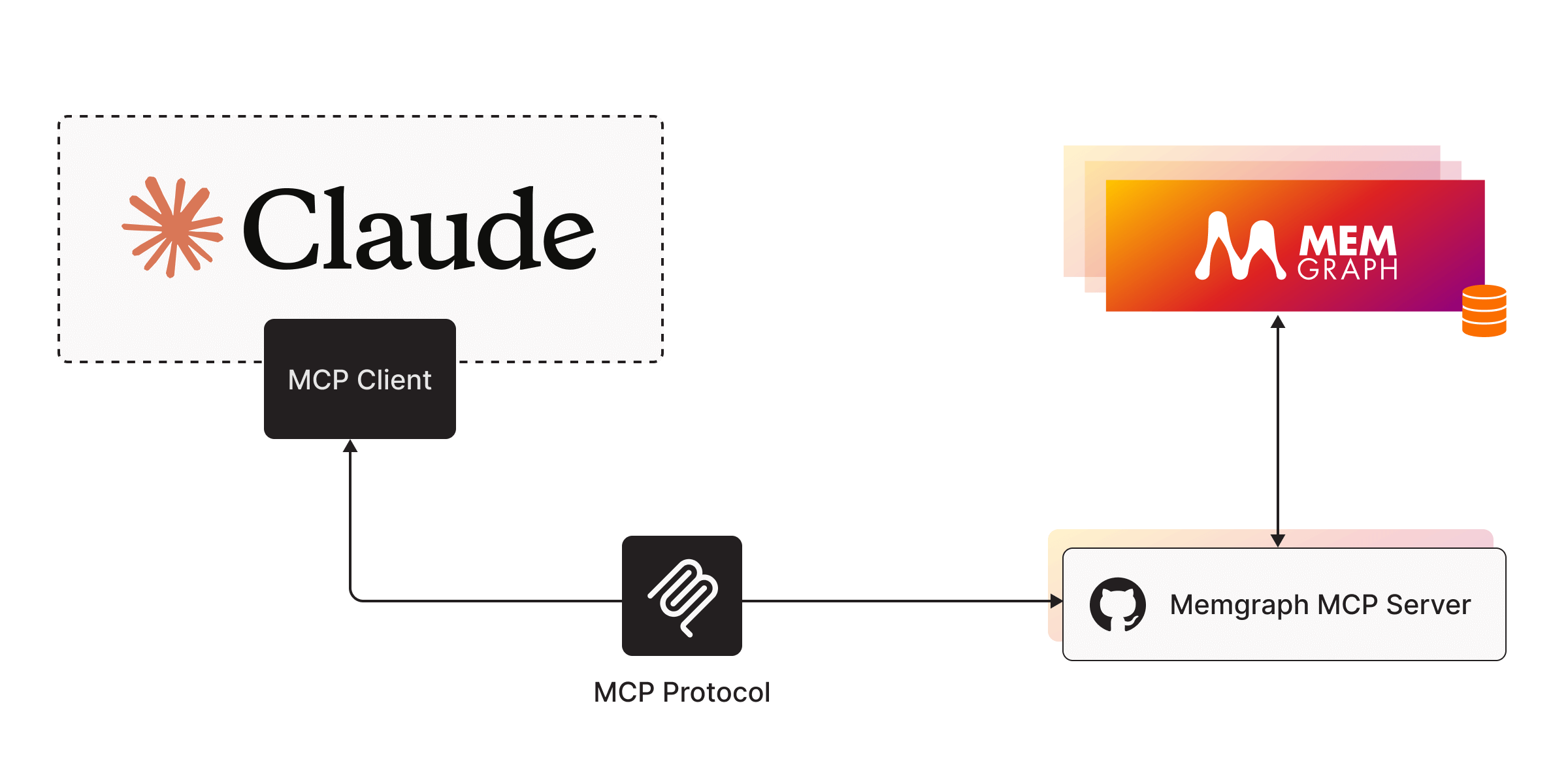

Memgraph MCP サーバーは、Memgraph を LLM に接続するために設計されたモデル コンテキスト プロトコル (MCP) の軽量サーバー実装です。

⚡ クイックスタート

1. Memgraph MCPサーバーを実行する

uvをインストールし、uv venvでvenvを作成します。.venv.venv\Scripts\activateで仮想環境をアクティブ化します。依存関係をインストール:

uv add "mcp[cli]" httpxMemgraph MCP サーバーを実行します:

uv run server.py。

2. MCPクライアントを実行する

Claude for Desktopをインストールします。

Claude config に Memgraph サーバーを追加します。

macOS/Linux

ウィンドウズ

設定例:

[!注記]

コマンドフィールドにuv実行ファイルへのフルパスを入力する必要がある場合があります。macOS/Linuxの場合はwhich uv、Windowsの場合はwhere uv実行することで取得できます。サーバーへの絶対パスを必ず入力してください。

3. データベースとチャットする

Memgraph MAGE を実行します。

docker run -p 7687:7687 memgraph/memgraph-mage --schema-info-enabled=TrueLLM が

SHOW SCHEMA INFOクエリを実行できるように、--schema-info-enabled構成設定がTrueに設定されています。Claude Desktop を開いて、Memgraph のツールとリソースの一覧を確認してください。ぜひお試しください!( Memgraph Labデータセットからダミーデータを読み込むことができます)

Related MCP server: mcp-graphql

🔧ツール

実行クエリ()

Memgraph に対して Cypher クエリを実行します。

🗃️ リソース

get_schema()

Memgraph スキーマ情報を取得します (前提条件: --schema-info-enabled=True )。

🗺️ ロードマップ

Memgraph MCPサーバーはまだ始まったばかりです。私たちは、その機能拡張と、Memgraphを最新のAIワークフローにさらに容易に統合するための開発に積極的に取り組んでいます。近い将来、JavaScriptベースの環境をより適切にサポートするために、TypeScript版のサーバーをリリースする予定です。さらに、このプロジェクトをAIツールキットの中央リポジトリに移行し、LangChain、LlamaIndex、MCP向けの他のツールや統合機能と連携させる予定です。私たちの目標は、Memgraphをコアとしたグラフベースのアプリケーションやインテリジェントエージェントをシームレスに構築できる、統合されたオープンソースツールキットを提供することです。