txtai는 의미 검색, LLM 오케스트레이션, 언어 모델 워크플로를 위한 올인원 AI 프레임워크입니다.

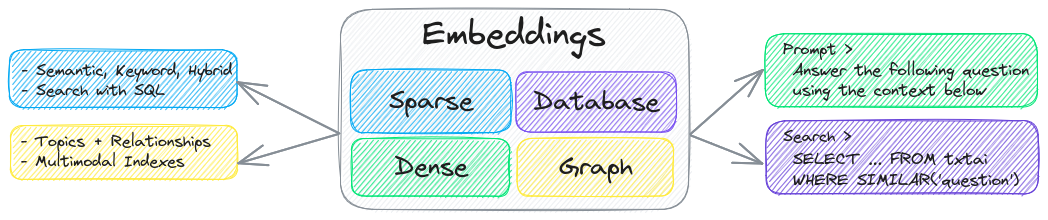

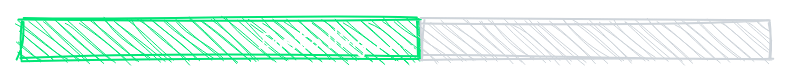

txtai의 핵심 구성 요소는 벡터 인덱스(희소 및 밀집), 그래프 네트워크 및 관계형 데이터베이스의 결합인 임베딩 데이터베이스입니다.

이 기반은 벡터 검색을 가능하게 하고 대규모 언어 모델(LLM) 애플리케이션을 위한 강력한 지식 소스 역할을 합니다.

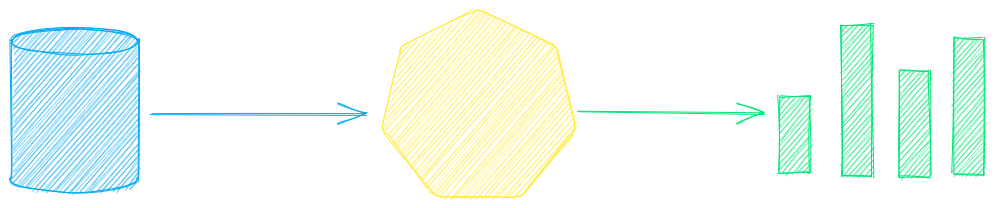

자율 에이전트, 검색 증강 생성(RAG) 프로세스, 다중 모델 워크플로 등을 구축합니다.

txtai 기능 요약:

🔎 SQL, 객체 스토리지, 주제 모델링, 그래프 분석 및 다중 모드 인덱싱을 사용한 벡터 검색

📄 텍스트, 문서, 오디오, 이미지 및 비디오에 대한 임베딩을 만듭니다.

💡 LLM 프롬프트, 질의응답, 레이블 지정, 필사, 번역, 요약 등을 실행하는 언어 모델 기반 파이프라인

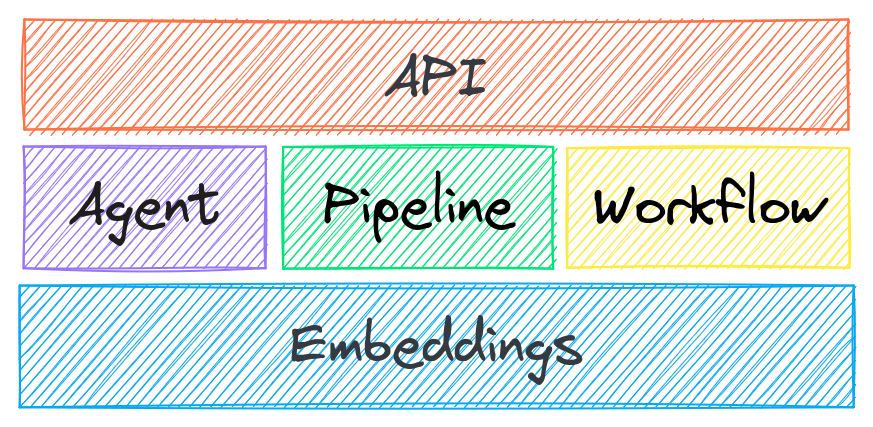

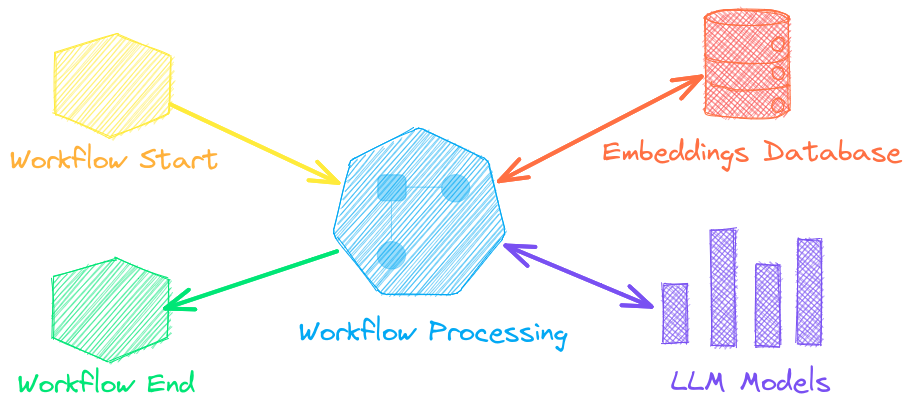

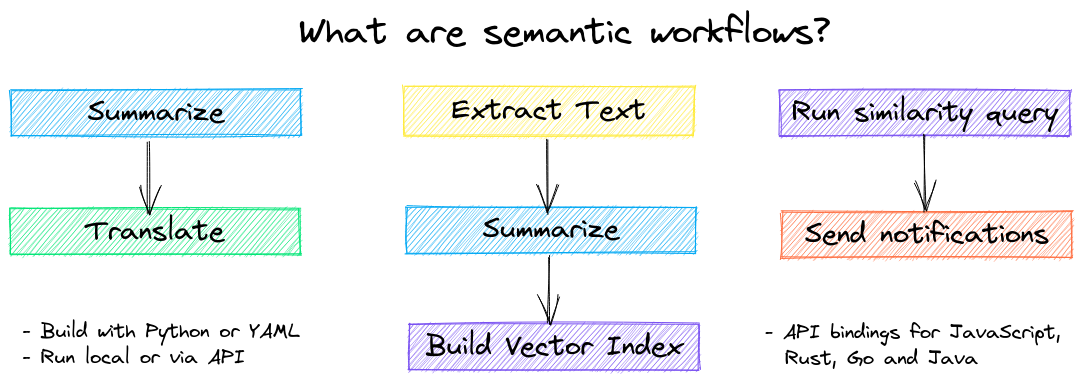

↪️️ 파이프라인을 연결하고 비즈니스 로직을 집계하는 워크플로. txtai 프로세스는 간단한 마이크로서비스나 다중 모델 워크플로가 될 수 있습니다.

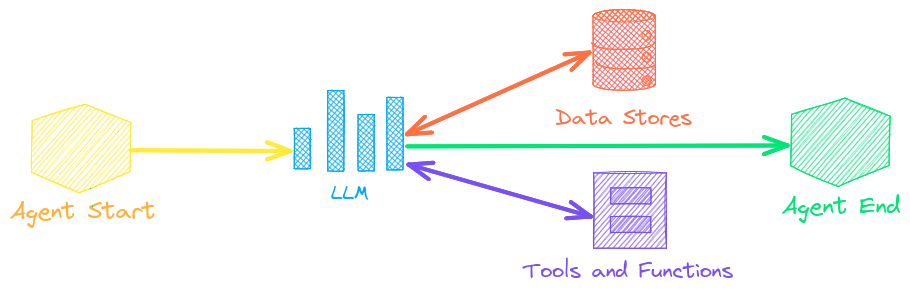

🤖 임베딩, 파이프라인, 워크플로 및 기타 에이전트를 지능적으로 연결하여 복잡한 문제를 자율적으로 해결하는 에이전트

⚙️ 웹 및 모델 컨텍스트 프로토콜(MCP) API. JavaScript , Java , Rust , Go에 대한 바인딩이 제공됩니다.

🔋 빠른 작동을 위해 기본으로 배터리가 포함되어 있습니다.

☁️ 컨테이너 오케스트레이션을 사용하여 로컬로 실행하거나 확장하세요

txtai는 Python 3.10+, Hugging Face Transformers , Sentence Transformers 및 FastAPI를 사용하여 구축되었습니다. txtai는 Apache 2.0 라이선스에 따라 오픈 소스입니다.

호스팅된 txtai 애플리케이션을 쉽고 안전하게 실행하는 방법에 관심이 있으신가요?

왜 txtai인가요?

새로운 벡터 데이터베이스, LLM 프레임워크 등 다양한 플랫폼이 매일 쏟아져 나오고 있습니다. TXTAI를 사용하는 이유는 무엇일까요?

지엑스피1

내장된 API를 사용하면 선택한 프로그래밍 언어를 사용하여 애플리케이션을 쉽게 개발할 수 있습니다.

로컬로 실행 - 데이터를 여러 원격 서비스로 전송할 필요 없음

마이크로모델부터 대규모 언어 모델(LLM)까지 작업합니다.

낮은 설치 공간 - 추가 종속성을 설치하고 필요할 때 확장

예제를 통해 배우기 - 노트북은 사용 가능한 모든 기능을 포함합니다.

Related MCP server: ReActMCP Web Search

사용 사례

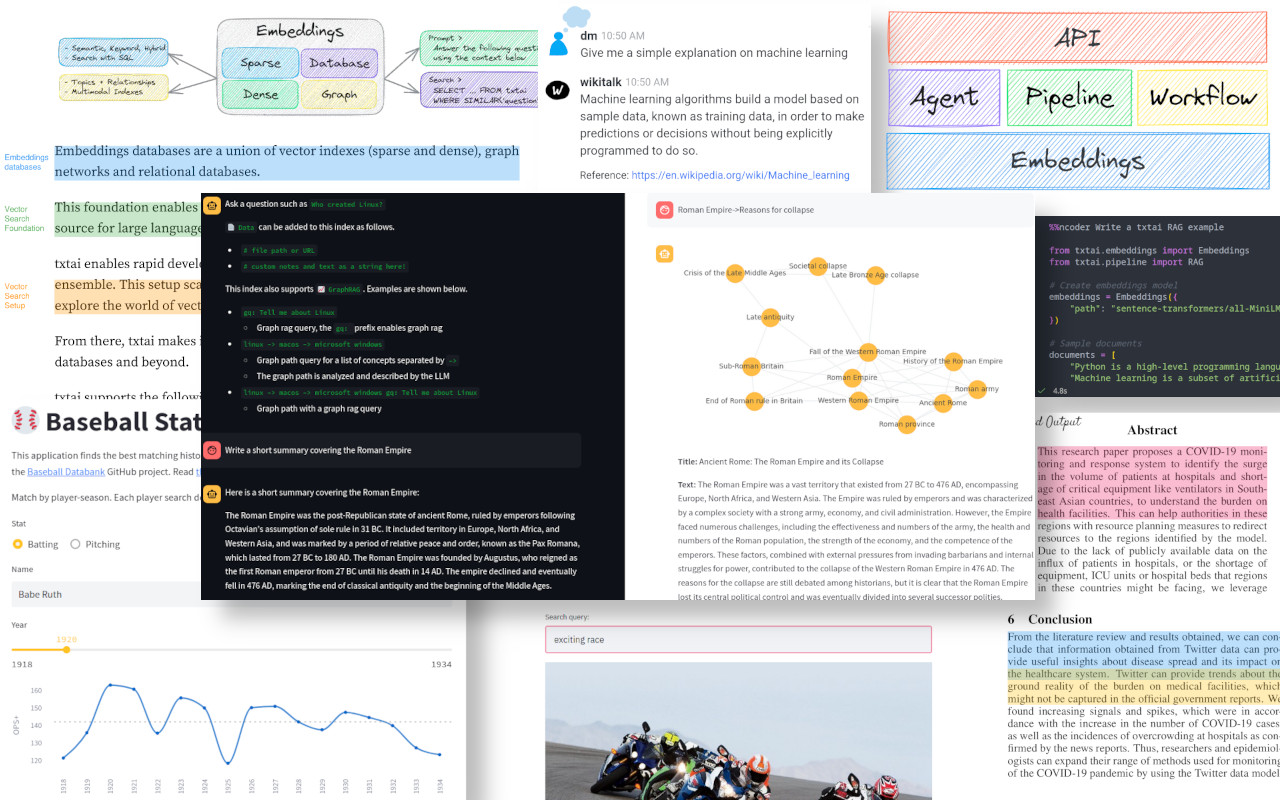

다음 섹션에서는 일반적인 txtai 사용 사례를 소개합니다. 60개 이상의 포괄적인 예제 노트북 및 애플리케이션 세트도 제공됩니다.

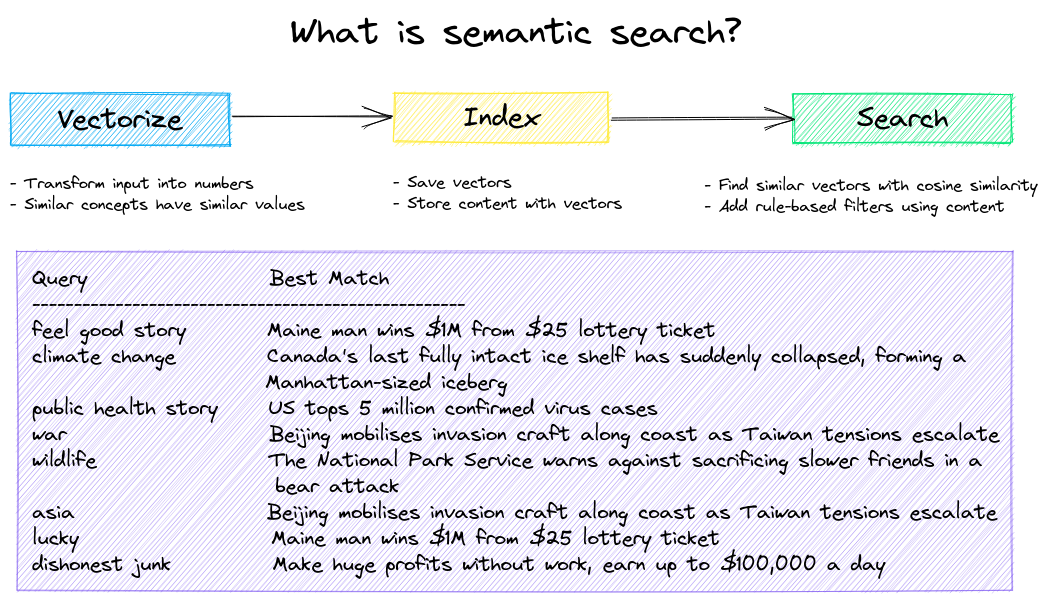

의미 검색

의미론적/유사성/벡터/신경망 검색 애플리케이션을 구축합니다.

기존 검색 시스템은 키워드를 사용하여 데이터를 찾습니다. 시맨틱 검색은 자연어를 이해하고 동일한 키워드가 아니더라도 동일한 의미를 가진 결과를 찾아냅니다.

다음 예를 통해 시작해 보세요.

|공책|설명|

|:---|:---|---:|

|txtai 소개 ▶️|txtai가 제공하는 기능 개요||

|이미지를 이용한 유사성 검색|검색을 위해 동일한 공간에 이미지와 텍스트를 삽입합니다.|

|

|QA 데이터베이스 구축|의미 검색을 통한 질문 매칭|

|

|의미 그래프|주제, 데이터 연결성 탐색 및 네트워크 분석 실행|

|

LLM 오케스트레이션

자율 에이전트, 검색 증강 생성(RAG), 데이터와의 채팅, 대규모 언어 모델(LLM)과 인터페이스하는 파이프라인 및 워크플로.

자세한 내용은 아래를 참조하세요.

|공책|설명|

|:---|:---|---:|

|프롬프트 템플릿 및 작업 체인|모델 프롬프트를 구축하고 워크플로를 통해 작업을 연결합니다.||

|LLM 프레임워크 통합|llama.cpp, LiteLLM 및 사용자 정의 생성 프레임워크 통합|

|

|LLM을 사용하여 지식 그래프 구축|LLM 기반 엔터티 추출을 사용하여 지식 그래프 구축|

|

|txtai로 별 분석하기|알려진 별, 행성, 은하의 천문학 지식 그래프를 탐색하세요|

|

자치령 대표

에이전트는 임베딩, 파이프라인, 워크플로 및 기타 에이전트를 연결하여 복잡한 문제를 자율적으로 해결합니다.

txtai 에이전트는 smolagents 프레임워크를 기반으로 구축되었습니다. 이는 txtai가 지원하는 모든 LLM(Hugging Face, llama.cpp, LiteLLM을 통한 OpenAI/Claude/AWS Bedrock)을 지원합니다.

자세한 내용은 아래 링크를 참조하세요.

|공책|설명|

|:---|:---|---:|

|그래프와 에이전트를 사용한 포옹 얼굴 게시물 분석|그래프 분석 및 에이전트를 사용하여 풍부한 데이터 세트를 탐색하세요||

|에이전트에게 자율권 부여|적합하다고 판단되는 대로 문제를 반복적으로 해결하는 에이전트|

|

|그래프와 에이전트를 활용한 LinkedIn 회사 게시물 분석|AI를 활용한 소셜 미디어 참여도 개선 방법 탐색|

|

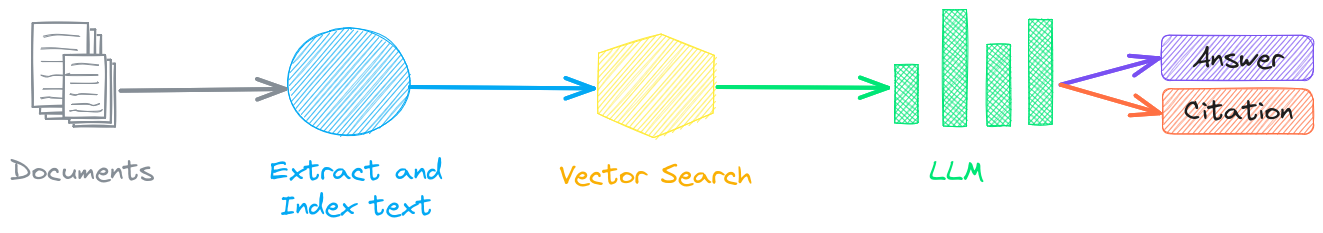

검색 증강 생성

검색 증강 생성(RAG)은 지식 기반을 맥락으로 사용하여 출력을 제한함으로써 LLM 환각 위험을 줄입니다. RAG는 일반적으로 "데이터와 소통"하는 데 사용됩니다.

txtai의 새로운 특징은 답변과 출처 인용을 모두 제공할 수 있다는 것입니다.

|공책|설명|

|:---|:---|---:|

|txtai로 RAG 파이프라인 구축|인용문을 만드는 방법을 포함한 검색 증강 생성에 대한 가이드||

|RAG에 대한 데이터 청킹|효과적인 검색을 위해 콘텐츠 추출, 청크 및 인덱싱|

|

|그래프 경로 탐색을 통한 고급 RAG|고급 RAG를 위한 복잡한 데이터 세트를 수집하기 위한 그래프 경로 탐색|

|

|스피치 투 스피치 RAG ▶️|RAG를 사용한 전체 사이클 음성 대 음성 워크플로|

|

언어 모델 워크플로

언어 모델 워크플로는 의미론적 워크플로라고도 하며, 언어 모델을 연결하여 지능형 애플리케이션을 구축합니다.

LLM은 강력하지만, 특정 작업에 더 효과적이고 빠르게 작동하는 더 작고 전문화된 모델들이 많이 있습니다. 여기에는 추출형 질의응답, 자동 요약, 텍스트 음성 변환, 필사 및 번역 모델이 포함됩니다.

|공책|설명|

|:---|:---|---:|

|파이프라인 워크플로 실행 ▶️|데이터를 효율적으로 처리하기 위한 간단하면서도 강력한 구성 요소||

|추상적 텍스트 요약 작성|추상 텍스트 요약 실행|

|

|오디오를 텍스트로 변환|오디오 파일을 텍스트로 변환|

|

|언어 간 텍스트 번역|기계 번역 및 언어 감지를 간소화합니다.|

|

설치

설치하는 가장 쉬운 방법은 pip와 PyPI를 사용하는 것입니다.

Python 3.10 이상이 지원됩니다. Python 가상 환경 사용을 권장합니다.

선택적 종속성 , 환경별 필수 구성 요소 , 소스에서 설치 , Conda 지원 및 컨테이너로 실행하는 방법에 대한 자세한 내용은 자세한 설치 지침을 참조하세요.

모델 가이드

현재 권장되는 모델은 아래 표를 참조하세요. 이 모델들은 모두 상업적 용도로 사용 가능하며 속도와 성능을 모두 제공합니다.

요소 | 모델(들) |

훈련 파이프라인 으로 미세 조정 | |

모델은 Hugging Face Hub의 경로 또는 로컬 디렉터리로 로드할 수 있습니다. 모델 경로는 선택 사항이며, 지정하지 않으면 기본값이 로드됩니다. 권장 모델이 없는 작업의 경우, txtai는 Hugging Face 작업 가이드에 표시된 대로 기본 모델을 사용합니다.

자세한 내용은 다음 링크를 참조하세요.

txtai로 구동됨

다음 애플리케이션은 txtai를 기반으로 합니다.

애플리케이션 | 설명 |

검색 증강 생성(RAG) 애플리케이션 | |

RAG에 대한 지식 기반 구축 | |

의학/과학 논문을 위한 의미 검색 및 워크플로 | |

LLM으로 논문에 자동으로 주석 달기 |

이 목록 외에도 txtai를 기반으로 생산되는 오픈소스 프로젝트 , 공개된 연구 , 폐쇄된 독점/상업 프로젝트가 많이 있습니다.

추가 자료

의미 검색 시작하기 | 워크플로 | 래그

선적 서류 비치

임베딩, 파이프라인, 워크플로, API에 대한 구성 설정을 포함한 txtai에 대한 전체 문서 와 일반적인 질문/문제에 대한 FAQ를 이용할 수 있습니다.

기여하다

txtai에 기여하고 싶은 분들은 이 가이드를 참조하세요.