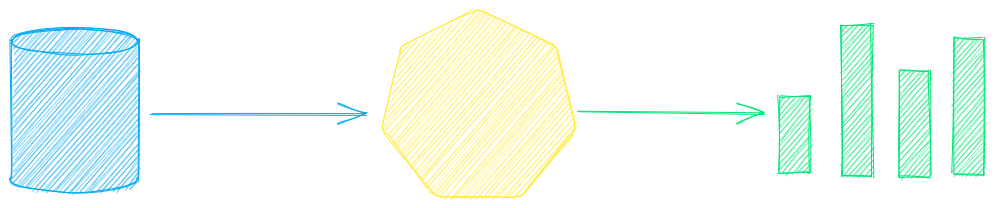

txtai es un marco de inteligencia artificial todo en uno para búsqueda semántica, orquestación LLM y flujos de trabajo de modelos de lenguaje.

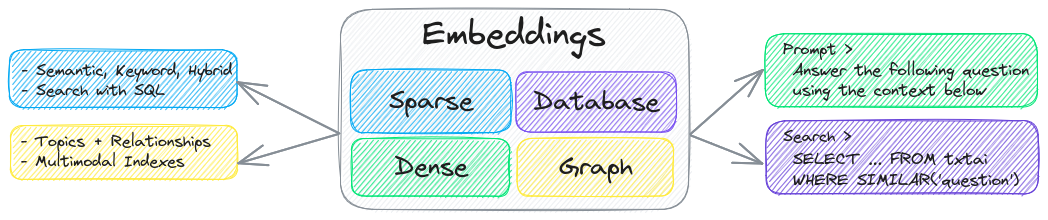

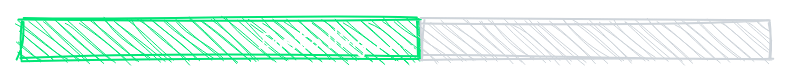

El componente clave de txtai es una base de datos de incrustaciones, que es una unión de índices vectoriales (dispersos y densos), redes de gráficos y bases de datos relacionales.

Esta base permite la búsqueda vectorial y/o sirve como una poderosa fuente de conocimiento para aplicaciones de modelos de lenguaje grandes (LLM).

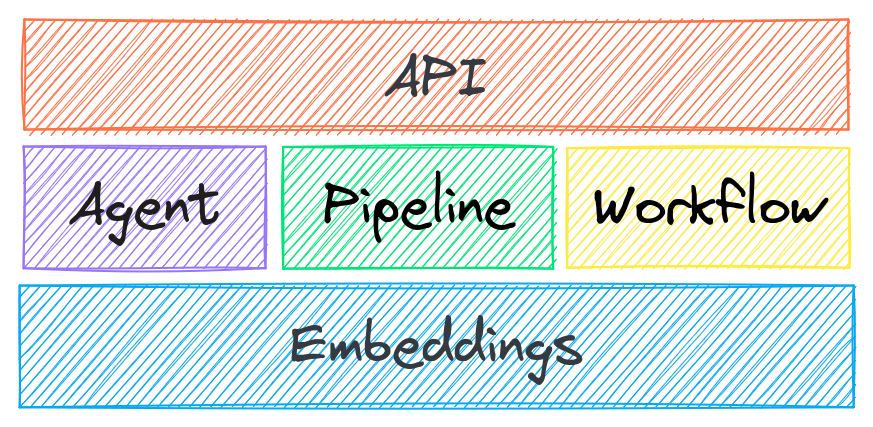

Cree agentes autónomos, recupere procesos de generación aumentada (RAG), flujos de trabajo multimodelo y más.

Resumen de las características de txtai:

🔎 Búsqueda vectorial con SQL, almacenamiento de objetos, modelado de temas, análisis de gráficos e indexación multimodal

📄 Crea incrustaciones para texto, documentos, audio, imágenes y vídeo

💡 Canalizaciones impulsadas por modelos de lenguaje que ejecutan indicaciones LLM, respuestas a preguntas, etiquetado, transcripción, traducción, resumen y más

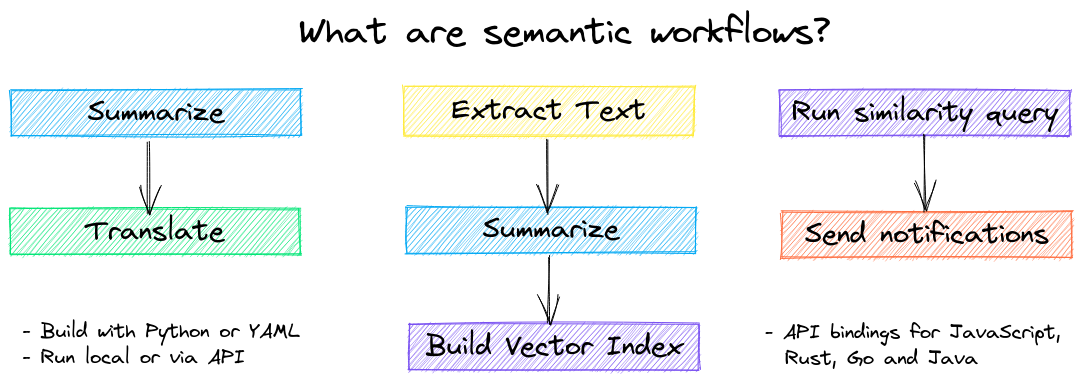

↪️️ Flujos de trabajo para unir pipelines y agregar lógica empresarial. Los procesos de txtai pueden ser microservicios simples o flujos de trabajo multimodelo.

🤖 Agentes que conectan de forma inteligente incrustaciones, pipelines, flujos de trabajo y otros agentes para resolver de forma autónoma problemas complejos

API de Protocolo de Contexto de Modelo (MCP) y Web. Enlaces disponibles para JavaScript , Java , Rust y Go .

🔋 Baterías incluidas con valores predeterminados para ponerse en funcionamiento rápidamente

☁️ Ejecute localmente o escale horizontalmente con la orquestación de contenedores

txtai está construido con Python 3.10+, Hugging Face Transformers , Sentence Transformers y FastAPI . txtai es de código abierto bajo una licencia Apache 2.0.

¿Te interesa una forma fácil y segura de ejecutar aplicaciones alojadas en txtai? Únete a la versión preliminar

¿Por qué txtai?

Nuevas bases de datos vectoriales, frameworks LLM y todo lo demás surgen a diario. ¿Por qué construir con txtai?

La API incorporada facilita el desarrollo de aplicaciones utilizando el lenguaje de programación de su elección

Ejecución local: no es necesario enviar datos a distintos servicios remotos

Trabaje con micromodelos hasta grandes modelos de lenguaje (LLM)

Ocupa poco espacio: instale dependencias adicionales y amplíe el espacio cuando sea necesario

Aprenda con el ejemplo : los cuadernos cubren todas las funciones disponibles

Related MCP server: ReActMCP Web Search

Casos de uso

Las siguientes secciones presentan casos de uso comunes de txtai. También se encuentra disponible un conjunto completo de más de 60 cuadernos y aplicaciones de ejemplo .

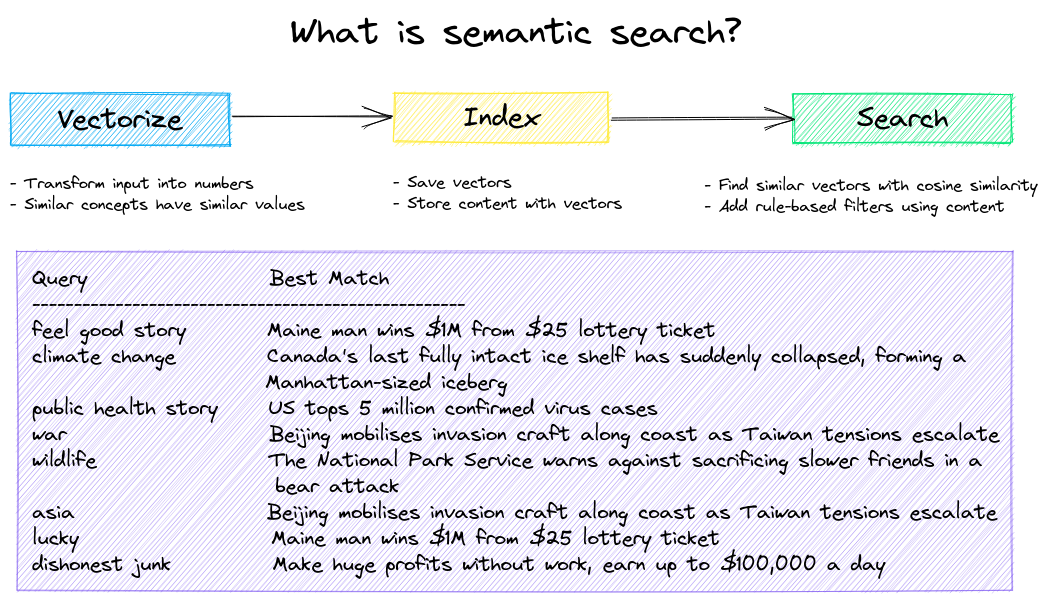

Búsqueda semántica

Construir aplicaciones de búsqueda semántica/de similitud/vectorial/neuronal.

Los sistemas de búsqueda tradicionales utilizan palabras clave para encontrar datos. La búsqueda semántica comprende el lenguaje natural e identifica resultados que tienen el mismo significado, no necesariamente las mismas palabras clave.

Comience con los siguientes ejemplos.

|Computadora portátil|Descripción|

|:---|:---|---:|

|Presentando txtai ▶️|Descripción general de la funcionalidad proporcionada por txtai||

|Búsqueda de similitud con imágenes|Incruste imágenes y texto en el mismo espacio para realizar búsquedas|

|

|Construir una base de datos de control de calidad|Coincidencia de preguntas con búsqueda semántica|

|

|Gráficos semánticos|Explorar temas, conectividad de datos y ejecutar análisis de red|

|

Orquestación LLM

Agentes autónomos, generación aumentada de recuperación (RAG), chat con sus datos, canales y flujos de trabajo que interactúan con modelos de lenguaje grandes (LLM).

Vea a continuación para obtener más información.

|Computadora portátil|Descripción|

|:---|:---|---:|

|Plantillas de indicaciones y cadenas de tareas|Cree indicaciones de modelos y conecte tareas con flujos de trabajo||

|Integrar marcos LLM|Integrar llama.cpp, LiteLLM y marcos de generación personalizados|

|

|Construya gráficos de conocimiento con LLM|Cree gráficos de conocimiento con extracción de entidades impulsada por LLM|

|

|Analizando las estrellas con txtai|Explora un gráfico de conocimiento astronómico de estrellas, planetas y galaxias conocidas.|

|

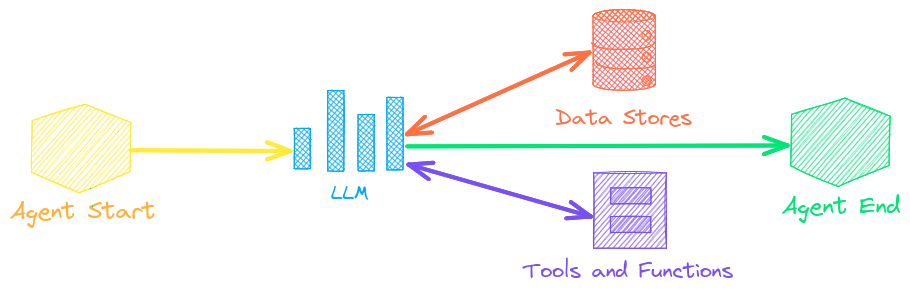

Agentes

Los agentes conectan incrustaciones, canalizaciones, flujos de trabajo y otros agentes entre sí para resolver de forma autónoma problemas complejos.

Los agentes de txtai se basan en el framework smolagents . Este es compatible con todos los LLM compatibles con txtai (Hugging Face, llama.cpp, OpenAI/Claude/AWS Bedrock a través de LiteLLM).

Vea el enlace a continuación para obtener más información.

|Computadora portátil|Descripción|

|:---|:---|---:|

|Análisis de publicaciones de abrazos con gráficos y agentes|Explora un rico conjunto de datos con análisis de gráficos y agentes||

|Otorgar autonomía a los agentes|Agentes que resuelven problemas iterativamente como lo consideran conveniente|

|

|Análisis de publicaciones de empresas en LinkedIn con gráficos y agentes|Explorando cómo mejorar la interacción en las redes sociales con IA|

|

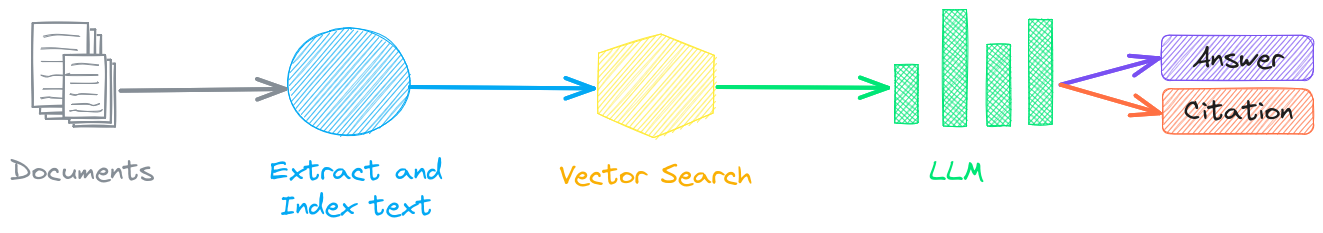

Recuperación de generación aumentada

La generación aumentada por recuperación (RAG) reduce el riesgo de alucinaciones LLM al restringir la salida con una base de conocimiento como contexto. RAG se utiliza comúnmente para "conversar con los datos".

Una característica novedosa de txtai es que puede proporcionar tanto una respuesta como una cita de fuente.

|Computadora portátil|Descripción|

|:---|:---|---:|

|Construya pipelines RAG con txtai|Guía sobre recuperación de generación aumentada que incluye cómo crear citas||

|Fragmentación de sus datos para RAG|Extraer, fragmentar e indexar contenido para una recuperación eficaz|

|

|RAG avanzado con recorrido de ruta de gráficos|Recorrido de rutas de gráficos para recopilar conjuntos de datos complejos para RAG avanzado|

|

|Discurso a discurso RAG ▶️|Flujo de trabajo de voz a voz de ciclo completo con RAG|

|

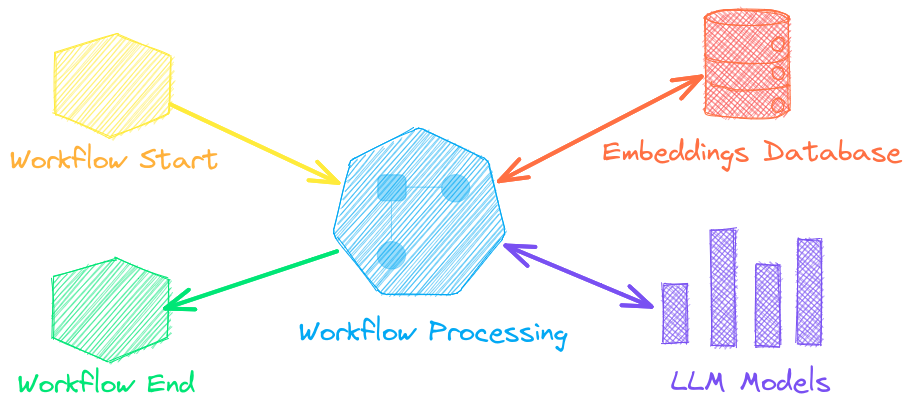

Flujos de trabajo de modelos de lenguaje

Los flujos de trabajo de modelos de lenguaje, también conocidos como flujos de trabajo semánticos, conectan modelos de lenguaje entre sí para crear aplicaciones inteligentes.

Si bien los LLM son potentes, existen muchos modelos más pequeños y especializados que funcionan mejor y con mayor rapidez para tareas específicas. Esto incluye modelos para preguntas y respuestas extractivas, resúmenes automáticos, conversión de texto a voz, transcripción y traducción.

|Computadora portátil|Descripción|

|:---|:---|---:|

|Ejecutar flujos de trabajo de canalización ▶️|Construcciones simples pero potentes para procesar datos de manera eficiente||

|Elaboración de resúmenes textuales abstractos|Ejecutar resumen de texto abstracto|

|

|Transcribir audio a texto|Convertir archivos de audio a texto|

|

|Traducir texto entre idiomas|Optimice la traducción automática y la detección de idiomas|

|

Instalación

La forma más fácil de instalar es a través de pip y PyPI

Se admite Python 3.10+. Se recomienda usar un entorno virtual de Python.

Consulte las instrucciones de instalación detalladas para obtener más información sobre las dependencias opcionales , los requisitos previos específicos del entorno , la instalación desde la fuente , el soporte de conda y cómo ejecutar con contenedores .

Guía de modelos

Consulte la tabla a continuación para ver los modelos recomendados. Todos estos modelos son aptos para uso comercial y ofrecen una combinación de velocidad y rendimiento.

Componente | Modelo(s) |

Ajuste con la canalización de entrenamiento | |

Los modelos se pueden cargar como una ruta desde el Hub de Hugging Face o desde un directorio local. Las rutas de los modelos son opcionales; si no se especifican, se cargan las predeterminadas. Para las tareas sin un modelo recomendado, txtai utiliza los modelos predeterminados, como se muestra en la guía de Tareas de Hugging Face.

Consulte los siguientes enlaces para obtener más información.

Desarrollado por txtai

Las siguientes aplicaciones funcionan con txtai.

Solicitud | Descripción |

Aplicación de Generación Aumentada de Recuperación (RAG) | |

Construir bases de conocimiento para RAG | |

Búsqueda semántica y flujos de trabajo para artículos médicos/científicos | |

Anotar automáticamente artículos con LLM |

Además de esta lista, hay también muchos otros proyectos de código abierto , investigaciones publicadas y proyectos comerciales/propietarios cerrados que se han basado en txtai en producción.

Lectura adicional

Novedades de txtai 8.0 | 7.0 | 6.0 | 5.0 | 4.0

Introducción a la búsqueda semántica | flujos de trabajo | rag

Documentación

Está disponible la documentación completa sobre txtai, incluidas las configuraciones para incrustaciones, canalizaciones, flujos de trabajo, API y una sección de preguntas frecuentes con preguntas y problemas comunes.

Contribuyendo

Para aquellos que quieran contribuir a txtai, consulten esta guía .