txtai ist ein All-in-One-KI-Framework für semantische Suche, LLM-Orchestrierung und Sprachmodell-Workflows.

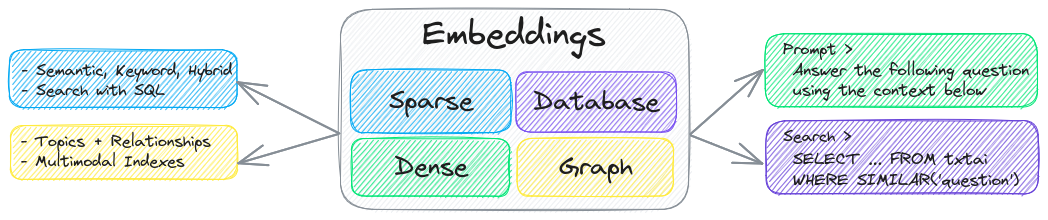

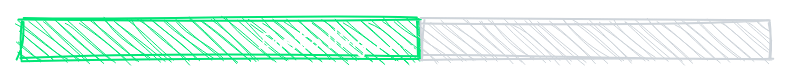

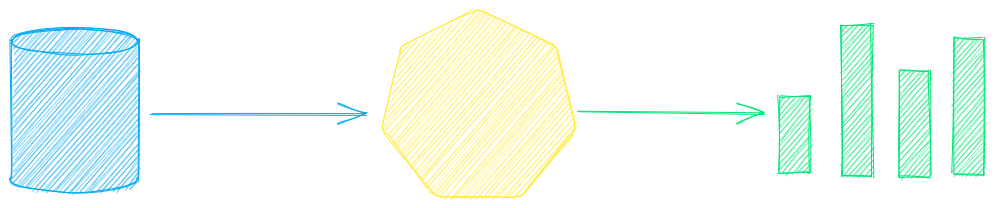

Die Schlüsselkomponente von txtai ist eine Einbettungsdatenbank, die eine Vereinigung von Vektorindizes (dünn und dicht), Graphnetzwerken und relationalen Datenbanken ist.

Diese Grundlage ermöglicht die Vektorsuche und/oder dient als leistungsstarke Wissensquelle für Anwendungen großer Sprachmodelle (LLM).

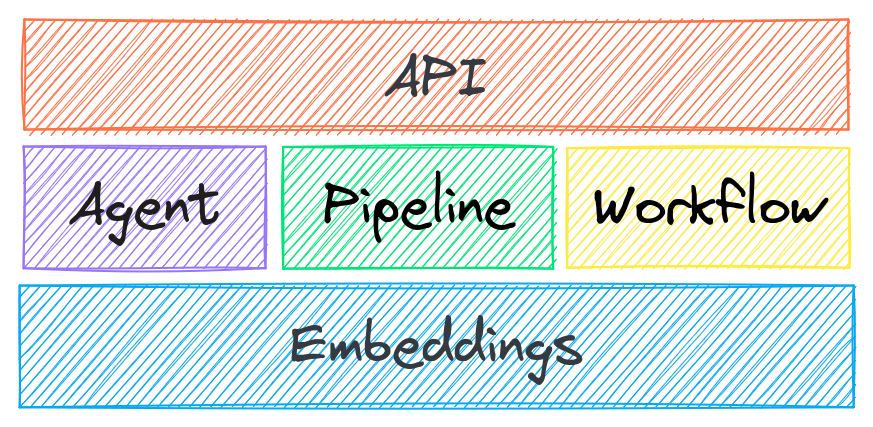

Erstellen Sie autonome Agenten, Retrieval Augmented Generation (RAG)-Prozesse, Multimodell-Workflows und mehr.

Zusammenfassung der txtai-Funktionen:

🔎 Vektorsuche mit SQL, Objektspeicher, Themenmodellierung, Graphenanalyse und multimodaler Indizierung

📄 Erstellen Sie Einbettungen für Text, Dokumente, Audio, Bilder und Videos

💡 Pipelines, die von Sprachmodellen unterstützt werden und LLM-Eingabeaufforderungen, Fragen-Antworten, Beschriftungen, Transkriptionen, Übersetzungen, Zusammenfassungen und mehr ausführen

↪️️ Workflows zum Zusammenführen von Pipelines und Aggregieren der Geschäftslogik. TXTAI-Prozesse können einfache Microservices oder Multimodell-Workflows sein.

🤖 Agenten, die Einbettungen, Pipelines, Workflows und andere Agenten intelligent miteinander verbinden, um komplexe Probleme autonom zu lösen

⚙️ Web- und Model Context Protocol (MCP)-APIs. Bindungen verfügbar für JavaScript , Java , Rust und Go .

🔋 Batterien sind standardmäßig im Lieferumfang enthalten, damit Sie schnell einsatzbereit sind

☁️ Lokal ausführen oder mit Container-Orchestrierung skalieren

txtai basiert auf Python 3.10+, Hugging Face Transformers , Sentence Transformers und FastAPI . txtai ist Open Source unter einer Apache 2.0-Lizenz.

Interessiert an einer einfachen und sicheren Möglichkeit, gehostete txtai-Anwendungen auszuführen? Dann nehmen Sie an der

Warum txtai?

Täglich entstehen neue Vektordatenbanken, LLM-Frameworks und vieles mehr. Warum mit txtai entwickeln?

Die integrierte API erleichtert die Entwicklung von Anwendungen in der Programmiersprache Ihrer Wahl

Lokal ausführen – keine Notwendigkeit, Daten an unterschiedliche Remote-Dienste zu senden

Arbeiten mit Mikromodellen bis hin zu großen Sprachmodellen (LLMs)

Geringer Platzbedarf – installieren Sie zusätzliche Abhängigkeiten und skalieren Sie nach Bedarf

Lernen Sie anhand von Beispielen – Notebooks decken alle verfügbaren Funktionen ab

Related MCP server: ReActMCP Web Search

Anwendungsfälle

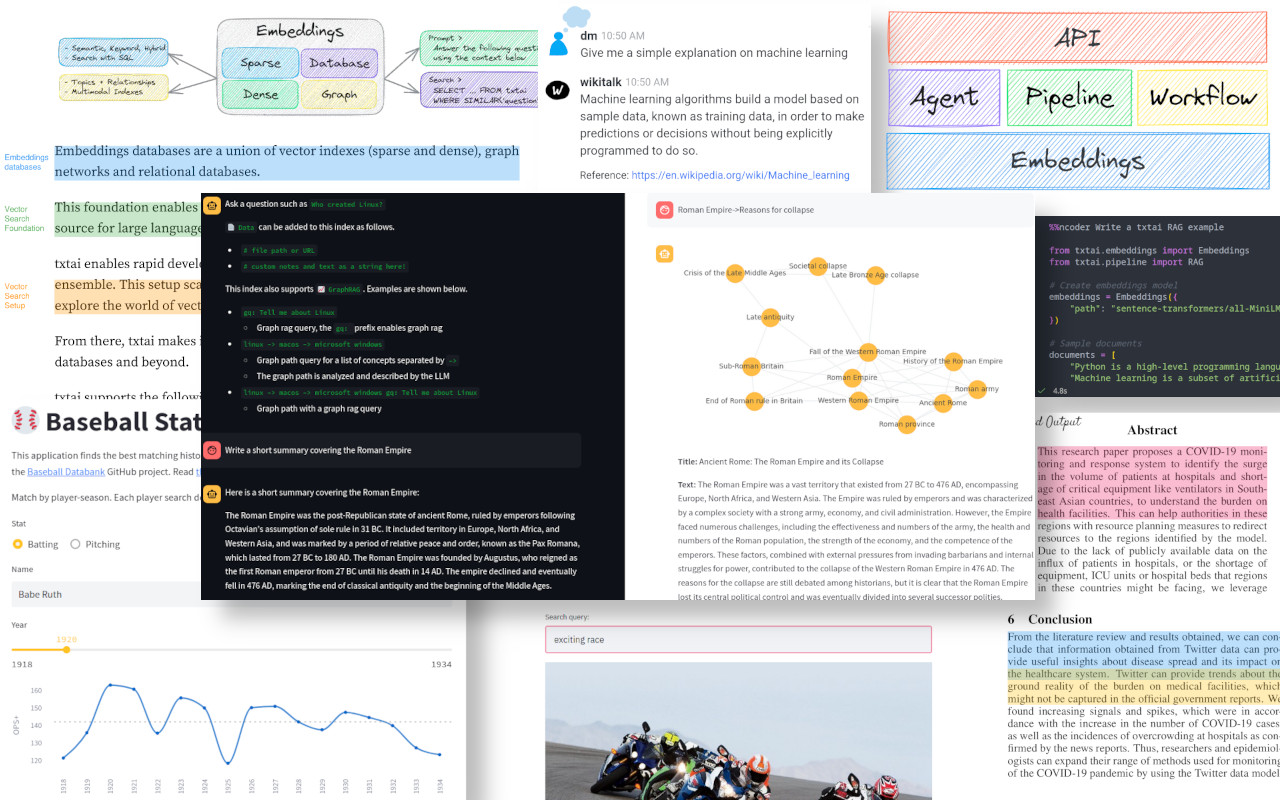

Die folgenden Abschnitte stellen gängige txtai-Anwendungsfälle vor. Darüber hinaus steht ein umfassender Satz von über 60 Beispiel-Notebooks und -Anwendungen zur Verfügung.

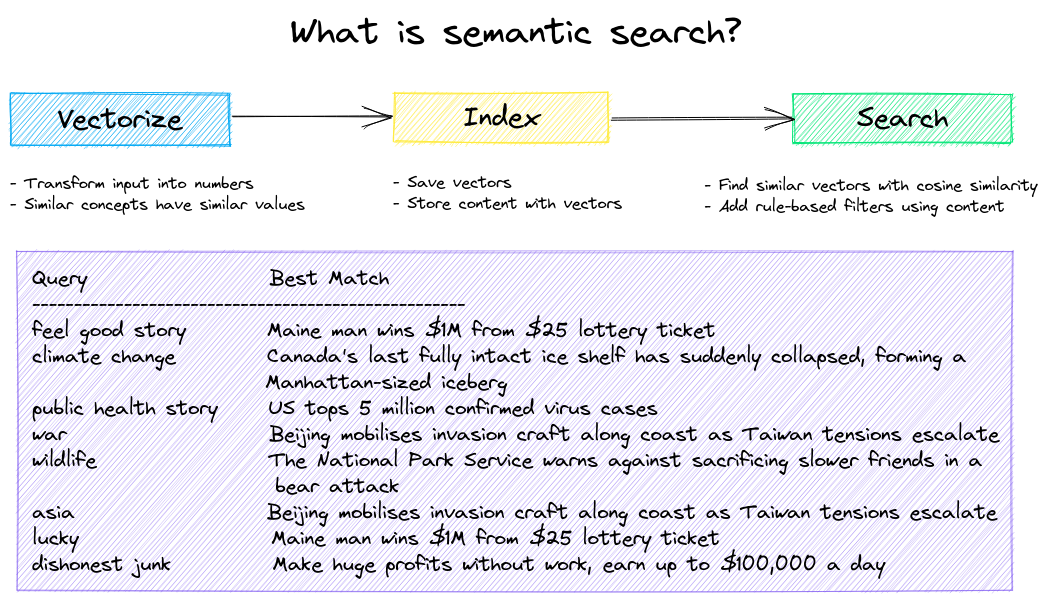

Semantische Suche

Erstellen Sie semantische/Ähnlichkeits-/Vektor-/neuronale Suchanwendungen.

Herkömmliche Suchsysteme verwenden Schlüsselwörter, um Daten zu finden. Die semantische Suche versteht die natürliche Sprache und identifiziert Ergebnisse mit gleicher Bedeutung, nicht unbedingt mit denselben Schlüsselwörtern.

Beginnen Sie mit den folgenden Beispielen.

|Notizbuch|Beschreibung|

|:---|:---|---:|

|Einführung von txtai ▶️|Übersicht über die von txtai bereitgestellten Funktionen||

|Ähnlichkeitssuche mit Bildern|Betten Sie Bilder und Text für die Suche im selben Bereich ein|

|

|Erstellen Sie eine QA-Datenbank|Fragenabgleich mit der semantischen Suche|

|

|Semantische Graphen|Erkunden Sie Themen, Datenkonnektivität und führen Sie Netzwerkanalysen durch|

|

LLM-Orchestrierung

Autonome Agenten, Retrieval Augmented Generation (RAG), Chat mit Ihren Daten, Pipelines und Workflows, die mit großen Sprachmodellen (LLMs) interagieren.

Weitere Informationen finden Sie weiter unten.

|Notizbuch|Beschreibung|

|:---|:---|---:|

|Eingabeaufforderungsvorlagen und Aufgabenketten|Erstellen Sie Modelleingabeaufforderungen und verknüpfen Sie Aufgaben mit Workflows||

|LLM-Frameworks integrieren|Integrieren Sie llama.cpp, LiteLLM und benutzerdefinierte Generierungsframeworks|

|

|Erstellen Sie Wissensgraphen mit LLMs|Erstellen Sie Wissensgraphen mit LLM-gesteuerter Entitätsextraktion|

|

|Analysieren der Sterne mit txtai|Erkunden Sie einen astronomischen Wissensgraphen bekannter Sterne, Planeten und Galaxien|

|

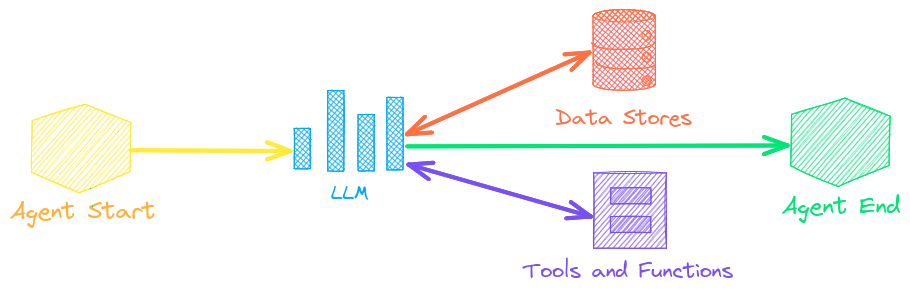

Agenten

Agenten verbinden Einbettungen, Pipelines, Workflows und andere Agenten miteinander, um komplexe Probleme autonom zu lösen.

txtai-Agenten basieren auf dem smolagents -Framework. Dieses unterstützt alle von txtai unterstützten LLMs (Hugging Face, llama.cpp, OpenAI / Claude / AWS Bedrock über LiteLLM).

Weitere Informationen finden Sie unter dem folgenden Link.

|Notizbuch|Beschreibung|

|:---|:---|---:|

|Analysieren von Hugging Face-Posts mit Graphen und Agenten|Erkunden Sie einen umfangreichen Datensatz mit Graphanalyse und Agenten||

|Gewährung von Autonomie für Agenten|Agenten, die Probleme iterativ nach eigenem Ermessen lösen|

|

|Analysieren von LinkedIn-Unternehmensbeiträgen mit Diagrammen und Agenten|Erkunden, wie sich das Social-Media-Engagement mithilfe von KI verbessern lässt|

|

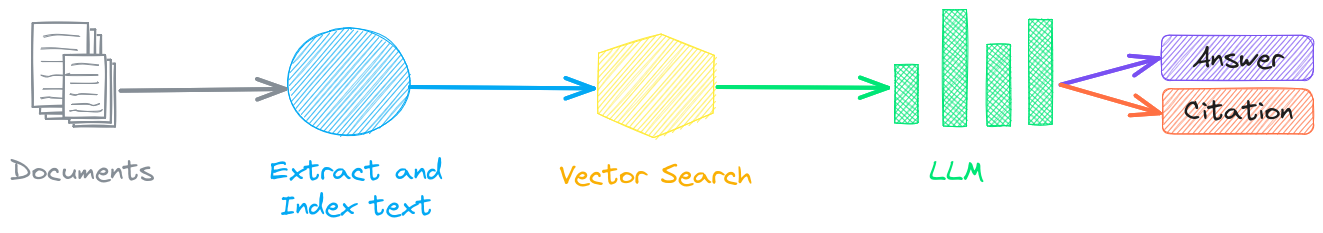

Retrieval-erweiterte Generierung

Retrieval Augmented Generation (RAG) reduziert das Risiko von LLM-Halluzinationen, indem es die Ausgabe mit einer Wissensbasis als Kontext einschränkt. RAG wird häufig verwendet, um „mit Ihren Daten zu chatten“.

Eine neuartige Funktion von txtai besteht darin, dass es sowohl eine Antwort als auch eine Quellenangabe bereitstellen kann.

|Notizbuch|Beschreibung|

|:---|:---|---:|

|Erstellen Sie RAG-Pipelines mit txtai|Leitfaden zur erweiterten Abfragegenerierung, einschließlich der Erstellung von Zitaten||

|Aufteilen Ihrer Daten für RAG|Extrahieren, Chunken und Indexieren von Inhalten für einen effektiven Abruf|

|

|Erweitertes RAG mit Graphpfad-Traversierung|Graph-Pfaddurchquerung zum Sammeln komplexer Datensätze für erweitertes RAG|

|

|Speech-to-Speech-RAG ▶️|Vollständiger Sprach-zu-Sprache-Workflow mit RAG|

|

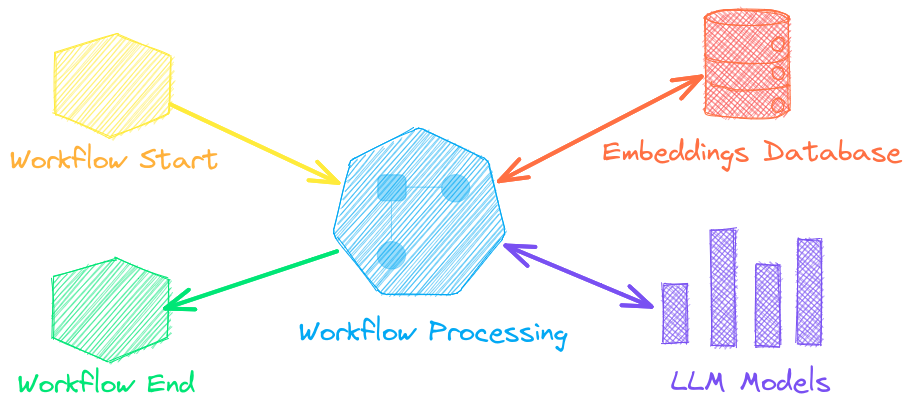

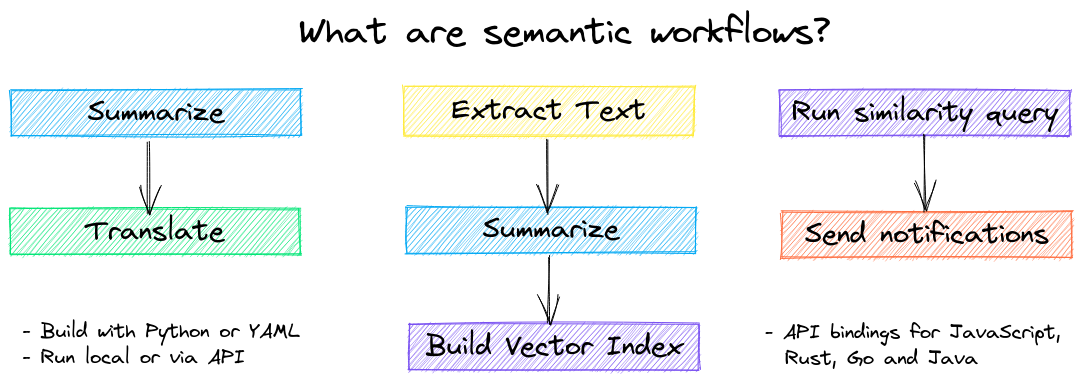

Sprachmodell-Workflows

Sprachmodell-Workflows, auch als semantische Workflows bekannt, verbinden Sprachmodelle miteinander, um intelligente Anwendungen zu erstellen.

Obwohl LLMs leistungsstark sind, gibt es viele kleinere, spezialisiertere Modelle, die für bestimmte Aufgaben besser und schneller funktionieren. Dazu gehören Modelle für die extraktiven Fragen und Antworten, automatische Zusammenfassung, Text-to-Speech, Transkription und Übersetzung.

|Notizbuch|Beschreibung|

|:---|:---|---:|

|Pipeline-Workflows ausführen ▶️|Einfache, aber leistungsstarke Konstrukte zur effizienten Datenverarbeitung||

|Erstellen abstrakter Textzusammenfassungen|Führen Sie eine abstrakte Textzusammenfassung durch|

|

|Audio in Text transkribieren|Audiodateien in Text konvertieren|

|

|Übersetzen Sie Text zwischen Sprachen|Optimieren Sie die maschinelle Übersetzung und Spracherkennung|

|

Installation

Die einfachste Möglichkeit zur Installation ist über Pip und PyPI

Python 3.10+ wird unterstützt. Die Verwendung einer virtuellen Python-Umgebung wird empfohlen.

Weitere Informationen zu optionalen Abhängigkeiten , umgebungsspezifischen Voraussetzungen , Installation aus der Quelle , Conda-Unterstützung und Ausführung mit Containern finden Sie in den ausführlichen Installationsanweisungen .

Modellhandbuch

Die aktuell empfohlenen Modelle finden Sie in der folgenden Tabelle. Diese Modelle sind alle für den gewerblichen Einsatz geeignet und bieten eine Kombination aus Geschwindigkeit und Leistung.

Komponente | Modell(e) |

Feinabstimmung mit der Trainingspipeline | |

Modelle können entweder über einen Pfad vom Hugging Face Hub oder über ein lokales Verzeichnis geladen werden. Modellpfade sind optional. Standardmodelle werden geladen, wenn sie nicht angegeben sind. Für Aufgaben ohne empfohlenes Modell verwendet txtai die Standardmodelle gemäß der Anleitung zu Hugging Face-Aufgaben.

Weitere Informationen finden Sie unter den folgenden Links.

Unterstützt von txtai

Die folgenden Anwendungen werden von txtai unterstützt.

Anwendung | Beschreibung |

Retrieval Augmented Generation (RAG)-Anwendung | |

Aufbau von Wissensdatenbanken für RAG | |

Semantische Suche und Workflows für medizinisch-wissenschaftliche Arbeiten | |

Automatische Kommentierung von Dokumenten mit LLMs |

Zusätzlich zu dieser Liste gibt es auch viele andere Open-Source-Projekte , veröffentlichte Forschungsergebnisse und geschlossene proprietäre/kommerzielle Projekte, die in der Produktion auf txtai aufgebaut sind.

Weitere Informationen

Was ist neu in txtai 8.0 | 7.0 | 6.0 | 5.0 | 4.0

Dokumentation

Eine vollständige Dokumentation zu txtai, einschließlich Konfigurationseinstellungen für Einbettungen, Pipelines, Workflows, API und einer FAQ mit häufig gestellten Fragen/Problemen, ist verfügbar.

Beitragen

Wer zu txtai beitragen möchte, findet in diesem Leitfaden weitere Informationen.