Task-Manager MCP-Server

Dies ist ein MCP-Server, der für die Integration mit KI-Code-Editoren wie Cursor entwickelt wurde. Das Hauptziel besteht darin, die Agentenfähigkeiten von Cursor und die hervorragenden Architekturfunktionen von Gemini 2.5 zu maximieren und gleichzeitig das extrem eingeschränkte Kontextfenster von Cursor zu umgehen. Dies wurde weitgehend vom Boomerang-Modus von Roo Code inspiriert, fand ihn aber extrem teuer, da das einzige Modell, das mit seinem Apply-Bot funktioniert, Claude 3.7 Sonnet ist. Mit diesem Server erhalten Sie das Beste aus beiden Welten: unbegrenztes Kontextfenster und unbegrenzte Nutzung zum Preis des Cursor-Abonnements von 20 $/Monat.

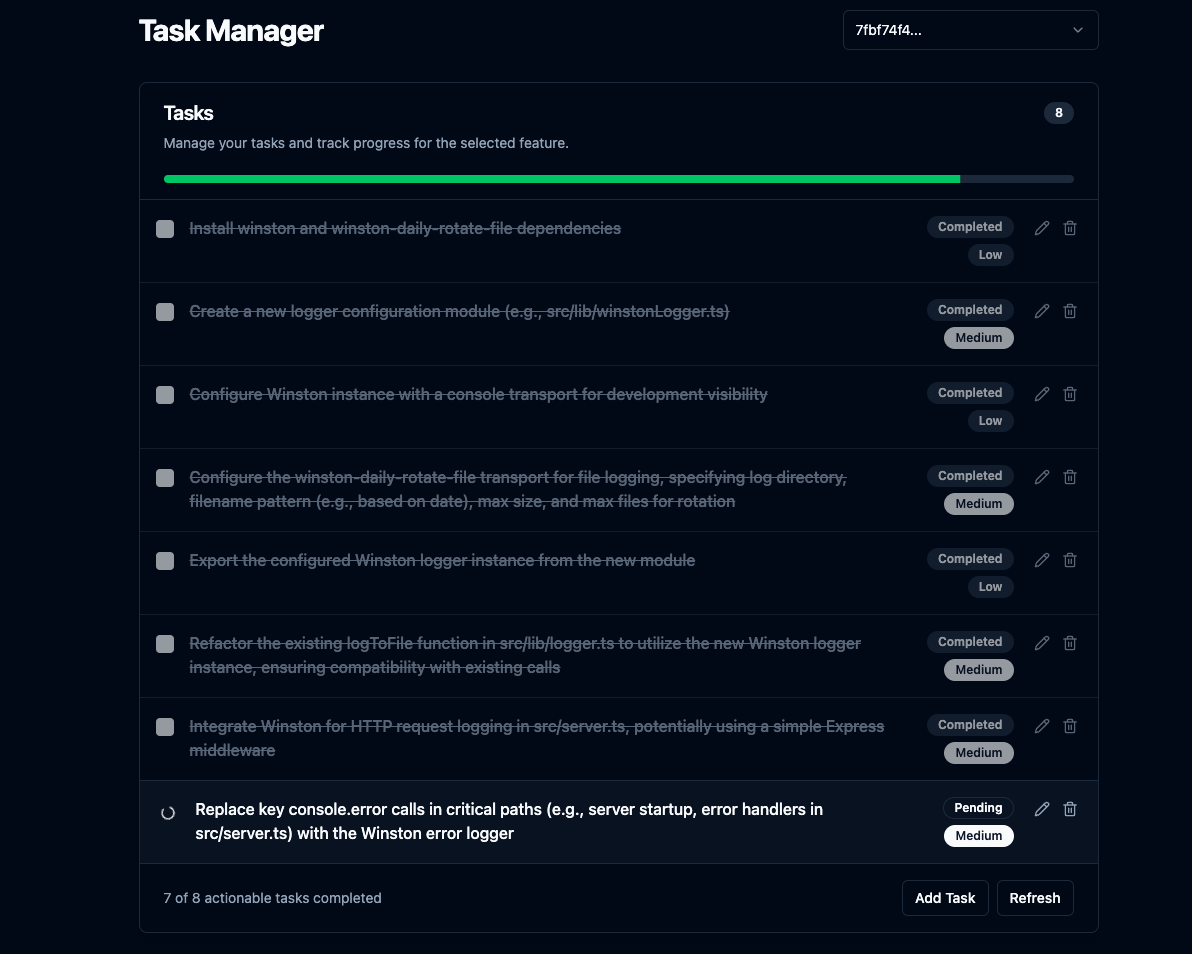

Darüber hinaus enthält es eine Svelte-Benutzeroberfläche, mit der Sie die Aufgabenliste und den Fortschritt anzeigen, den Plan manuell anpassen und die Änderungen überprüfen können.

Schlanke Benutzeroberfläche

Related MCP server: Fastn Server

Kernfunktionen

Komplexe Funktionsplanung: Geben Sie ihm eine Funktionsbeschreibung, und es verwendet ein LLM mit Projektkontext über

repomix, um einen schrittweisen Codierungsplan für den KI-Agenten zu generieren, der mit einer rekursiven Aufgabenaufschlüsselung für Aufgaben mit hohem Aufwand befolgt werden kann.Integrierter UI-Server: Führt einen Express-Server aus, um statische Frontend-Dateien bereitzustellen und grundlegende API-Endpunkte für die Benutzeroberfläche bereitzustellen. Öffnet die Benutzeroberfläche im Standardbrowser, nachdem die Planung abgeschlossen ist oder Klärungsbedarf besteht, und zeigt die Aufgabenliste und den Fortschritt an.

Unbegrenztes Kontextfenster: Verwendet das 1-Millionen-Token-Kontextfenster von Gemini 2.5 mit der Kürzung von

repomix, wenn nötig.Konversationsverlauf: Verfolgt den Konversationsverlauf für jede Funktion in einer separaten JSON-Datei unter

.mcp/features/, sodass Gemini 2.5 über den Kontext verfügt, wenn der Benutzer Anpassungen am Plan anfordert.Klärungs-Workflow: Behandelt Fälle, in denen das LLM weitere Informationen benötigt, indem es die Planung unterbricht und über WebSockets mit einer verbundenen Benutzeroberfläche interagiert.

Task CRUD: Ermöglicht das Erstellen, Lesen, Aktualisieren und Löschen von Aufgaben über die Benutzeroberfläche.

Codeüberprüfung: Analysiert

git diff HEADAusgabe mithilfe eines LLM und erstellt bei Bedarf neue Aufgaben.Automatische Überprüfung (optional): Wenn konfiguriert (

AUTO_REVIEW_ON_COMPLETION=true), wird der Codeüberprüfungsprozess automatisch ausgeführt, nachdem die letzte ursprüngliche Aufgabe für eine Funktion abgeschlossen wurde.Plananpassung: Ermöglicht die Anpassung des Plans nach seiner Erstellung über das Tool

adjust_plan.

Aufstellen

Voraussetzungen:

Node.js

npm

Git

Installation und Aufbau:

Klon:

git clone https://github.com/jhawkins11/task-manager-mcp.git cd task-manager-mcpBackend-Abhängigkeiten installieren:

npm installKonfigurieren: Sie konfigurieren API-Schlüssel später direkt in den MCP-Einstellungen von Cursor (siehe Abschnitt „Verwendung“), aber Sie benötigen möglicherweise dennoch eine lokale

.envDatei für manuelle Tests (siehe Abschnitt „Konfiguration“).Erstellen: Dieser Befehl erstellt die Backend- und Frontend-Server und kopiert die Svelte-Benutzeroberfläche in das Verzeichnis

dist/frontend-ui/.npm run build

Ausführen des Servers (manuell):

Für lokale Tests ohne Cursor können Sie den Server direkt über Node oder das npm-Skript ausführen. Diese Methode verwendet die .env Datei zur Konfiguration.

Node direkt verwenden (absoluten Pfad verwenden):

Verwenden von npm start:

Dadurch werden der MCP-Server (stdio), der WebSocket-Server und der HTTP-Server für die Benutzeroberfläche gestartet. Die Benutzeroberfläche sollte unter http://localhost:\ <UI_PORT> (Standard: 3000) erreichbar sein.

Konfiguration (.env-Datei für manuelle Ausführung):

Bei manueller Ausführung (nicht über Cursor) erstellen Sie eine .env-Datei im Projektstamm für API-Schlüssel und Ports. Hinweis: Bei Ausführung über Cursor sollten diese stattdessen in der mcp.json-Konfiguration von Cursor festgelegt werden (siehe Abschnitt „Verwendung“).

Kosten vermeiden

WICHTIG: Es wird dringend empfohlen, Ihren eigenen Google AI API-Schlüssel in OpenRouter zu integrieren, um die Ratenbegrenzungen der kostenlosen Modelle zu umgehen. Siehe unten.

Nutzung der kostenlosen Stufen von OpenRouter: Sie können Kosten deutlich minimieren oder eliminieren, indem Sie Modelle verwenden, die auf OpenRouter als „Kostenlos“ gekennzeichnet sind (wie zum Zeitpunkt des Schreibens google/gemini-2.5-flash-preview:thinking) und gleichzeitig Ihren eigenen Google AI API-Schlüssel verbinden. Weitere Informationen finden Sie in diesem Reddit-Thread: https://www.reddit.com/r/ChatGPTCoding/comments/1jrp1tj/a\_simple\_guide\_to\_setting\_up\_gemini\_25\_pro\_free/

Fallback-Kosten: Der Server versucht automatisch einen erneuten Versuch mit einem Fallback-Modell, wenn der primäre Server eine Ratenbegrenzung erreicht. Das Standard-Fallback (FALLBACK_OPENROUTER_MODEL) ist oft ein schnelleres/günstigeres Modell wie Gemini Flash, das je nach den aktuellen Preisen/Tarifen von OpenRouter dennoch Kosten verursachen kann. Überprüfen Sie die Website und passen Sie das Fallback-Modell in Ihrer Konfiguration gegebenenfalls an.

Verwendung mit Cursor (Task-Manager-Modus)

Dies ist die primäre Verwendungsmöglichkeit dieses Servers. Ich habe ihn noch nicht mit anderen KI-Code-Editoren getestet. Wenn Sie ihn ausprobieren, teilen Sie mir bitte mit, wie er funktioniert, und ich aktualisiere die README-Datei.

1. Konfigurieren Sie den MCP-Server im Cursor:

Nachdem Sie den Server erstellt haben ( npm run build ), müssen Sie Cursor mitteilen, wie er ausgeführt werden soll.

Suchen Sie die MCP-Konfigurationsdatei von Cursor. Dies kann sein:

Projektspezifisch: Erstellen/bearbeiten Sie eine Datei unter

.cursor/mcp.jsonim Stammverzeichnis Ihres Projekts.Global: Erstellen/bearbeiten Sie eine Datei unter

~/.cursor/mcp.jsonin Ihrem Benutzer-Home-Verzeichnis (zur Verwendung in allen Projekten).

Fügen Sie dem mcpServers-Objekt in dieser JSON-Datei den folgenden Eintrag hinzu:

WICHTIG:

Ersetzen Sie

/full/path/to/your/task-manager-mcp/dist/server.jsdurch den absoluten Pfad zum kompilierten Serverskript auf Ihrem Computer.Ersetzen Sie

sk-or-v1-xxxxxxxxxxxxxxxxxxxxdurch Ihren tatsächlichen OpenRouter-API-Schlüssel (oder legen Sie GEMINI_API_KEY fest, wenn Sie Google AI direkt verwenden).Diese hier definierten Umgebungsvariablen werden an den Serverprozess übergeben, wenn Cursor ihn startet, und überschreiben alle

.envDateien.

2. Erstellen Sie einen benutzerdefinierten Cursormodus:

Gehen Sie zu Cursoreinstellungen -> Funktionen -> Chat -> Benutzerdefinierte Modi aktivieren.

Gehen Sie zurück zur Chat-Ansicht, klicken Sie auf die Modusauswahl (unten links) und dann auf „Benutzerdefinierten Modus hinzufügen“.

Geben Sie ihm einen Namen (z. B. „MCP Planner“, „Task Dev“) und wählen Sie ein Symbol/eine Verknüpfung.

Tools aktivieren: Stellen Sie sicher, dass die von diesem Server bereitgestellten Tools (

plan_feature,mark_task_complete,get_next_task,review_changes,adjust_plan) für diesen Modus verfügbar und aktiviert sind. Je nach Arbeitsablauf können Sie weitere Tools wie Codebase, Terminal usw. aktivieren.Empfohlene Anweisungen für den Agenten: Fügen Sie diese Regeln genau in das Textfeld „Benutzerdefinierte Anweisungen“ ein:

Speichern Sie den benutzerdefinierten Modus.

Erwarteter Arbeitsablauf (unter Verwendung des benutzerdefinierten Modus):

Wählen Sie Ihren neuen benutzerdefinierten Modus im Cursor aus.

Geben Sie Cursor eine Funktionsanforderung (z. B. „Authentifizierung mit JWT hinzufügen“).

Der Cursor ruft gemäß den Anweisungen das Tool

plan_featureauf.Der Server plant, speichert Daten und gibt eine JSON-Antwort (innerhalb des Textinhalts) an Cursor zurück.

Bei Erfolg: Die Antwort enthält

status: "completed"und die Beschreibung der ersten Aufgabe immessage. Die Benutzeroberfläche (sofern ausgeführt) wird gestartet/aktualisiert.Falls Klärungsbedarf besteht: Die Antwort enthält

status: "awaiting_clarification", diefeatureId, dieuiUrlund Anweisungen für den Agenten, zu warten undget_next_taskspäter aufzurufen. Die Benutzeroberfläche wird mit der Frage gestartet/aktualisiert.

Cursor implementiert nur die beschriebene Aufgabe (sofern vorhanden).

Falls Klärungsbedarf besteht, antwortet der Benutzer in der Benutzeroberfläche, der Server nimmt die Planung wieder auf und aktualisiert die Benutzeroberfläche über WebSocket. Der Agent befolgt anschließend die Anweisungen und ruft

get_next_taskmit derfeatureIdauf.Wenn eine Aufgabe abgeschlossen wurde, ruft Cursor

mark_task_complete(mittaskIdundfeatureId) auf.Der Server markiert die Aufgabe als erledigt und gibt die nächste ausstehende Aufgabe in der Antwortnachricht zurück.

Der Cursor wiederholt die Schritte 4–8.

Wenn der Benutzer Cursor auffordert, eine „Überprüfung“ durchzuführen, ruft er

review_changesauf.

API-Endpunkte (für die Benutzeroberfläche)

Der integrierte Express-Server stellt diese grundlegenden Endpunkte für das Frontend bereit:

GET /api/features: Gibt eine Liste vorhandener Feature-IDs zurück.GET /api/tasks/:featureId: Gibt die Liste der Aufgaben für eine bestimmte Funktion zurück.GET /api/tasks: Gibt Aufgaben für die zuletzt erstellte/geänderte Funktion zurück.GET /api/features/:featureId/pending-question: Überprüft, ob eine aktive Klärungsfrage für die Funktion vorliegt.POST /api/tasks: Erstellt eine neue Aufgabe für eine Funktion.PUT /api/tasks/:taskId: Aktualisiert eine vorhandene Aufgabe.DELETE /api/tasks/:taskId: Löscht eine Aufgabe.(Statische Dateien) : Stellt Dateien aus

dist/frontend-ui/bereit (z. B.index.html).