mcp-server-opensearch: OpenSearch MCP サーバー

モデルコンテキストプロトコル(MCP)は、LLMアプリケーションと外部データソースおよびツールとのシームレスな統合を可能にするオープンプロトコルです。AI搭載IDEの構築、チャットインターフェースの拡張、カスタムAIワークフローの作成など、MCPはLLMと必要なコンテキストを接続する標準化された方法を提供します。

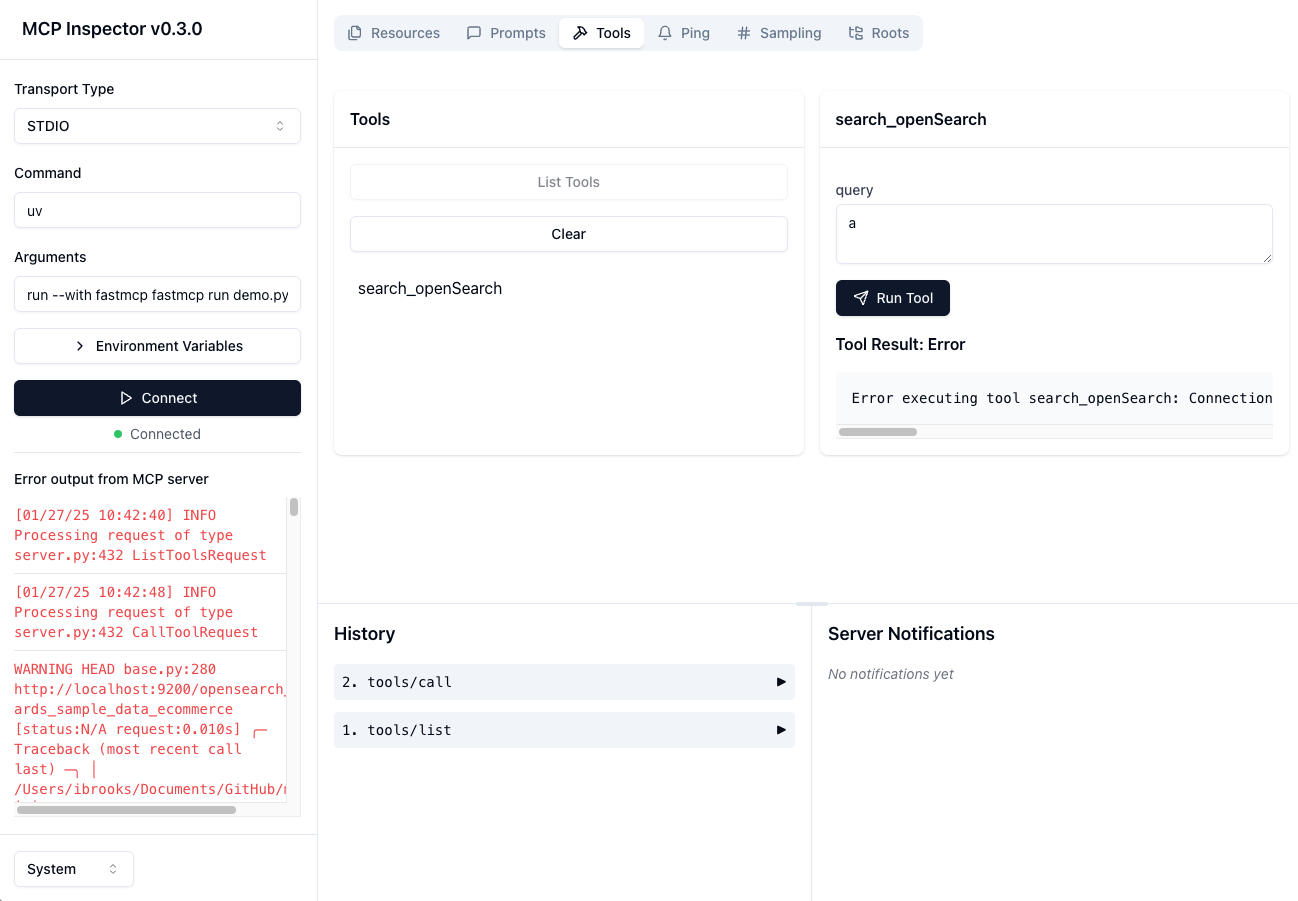

このリポジトリは、分散検索および分析エンジンであるOpenSearch用の MCP サーバーを作成する方法の例です。

建設中

現在のブロッカー - OpenSearch の非同期クライアントがインストールされません

Related MCP server: MCP DuckDuckGo Search Server

概要

OpenSearchエンジン内でメモリを保存および取得するための基本的なモデルコンテキストプロトコルサーバー。OpenSearchデータベース上のセマンティックメモリレイヤーとして機能します。

コンポーネント

ツール

search-openSearchOpenSearchデータベースにメモリを保存する

入力:

query(json): 準備された json クエリ メッセージ

戻り値: 確認メッセージ

インストール

Smithery経由でインストール

Smithery経由で Claude Desktop 用の mcp-server-opensearch を自動的にインストールするには:

uvの使用(推奨)

uvを使用する場合*、 mcp-server-opensearch を*直接実行するために特別なインストールは必要ありません。

または

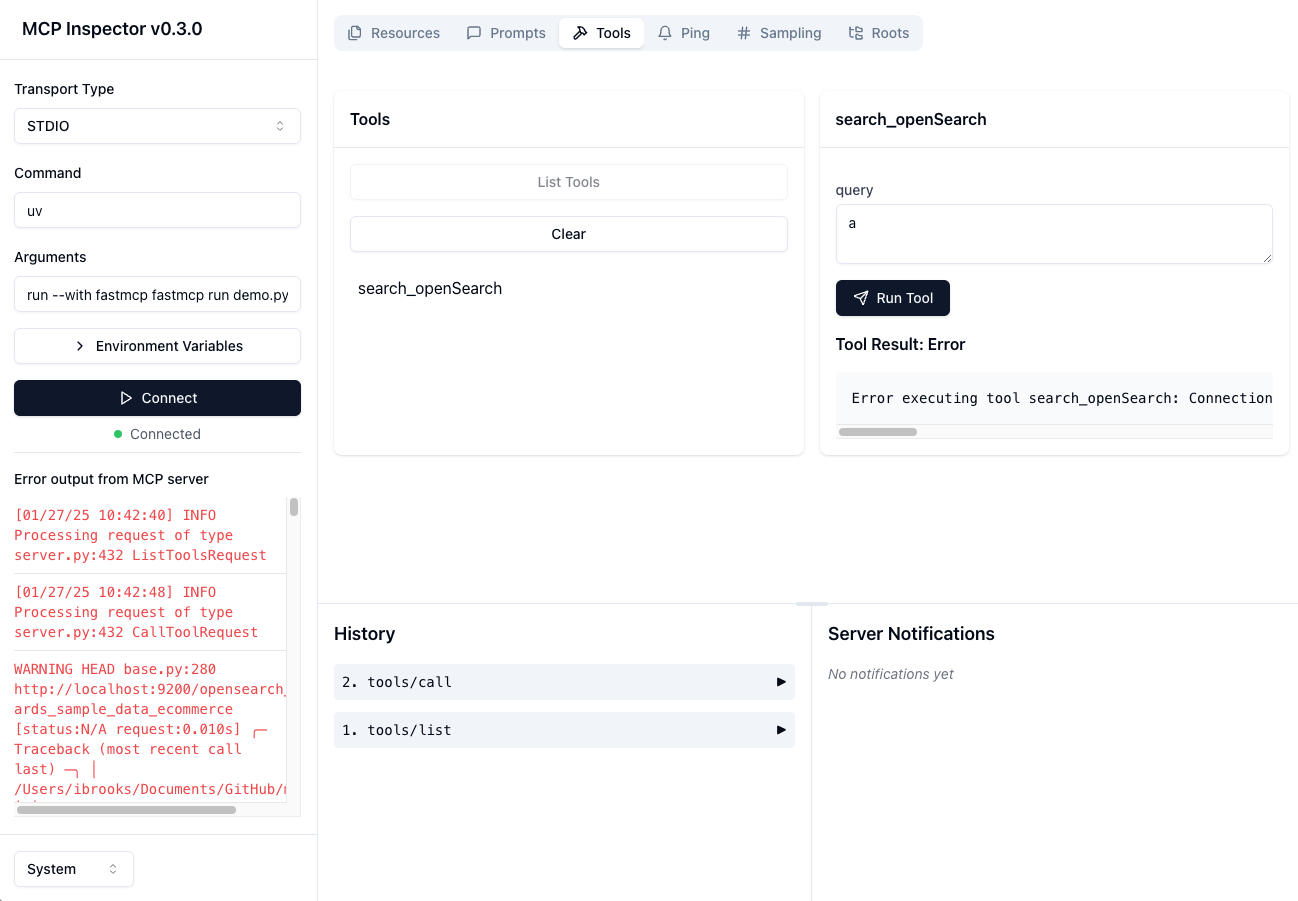

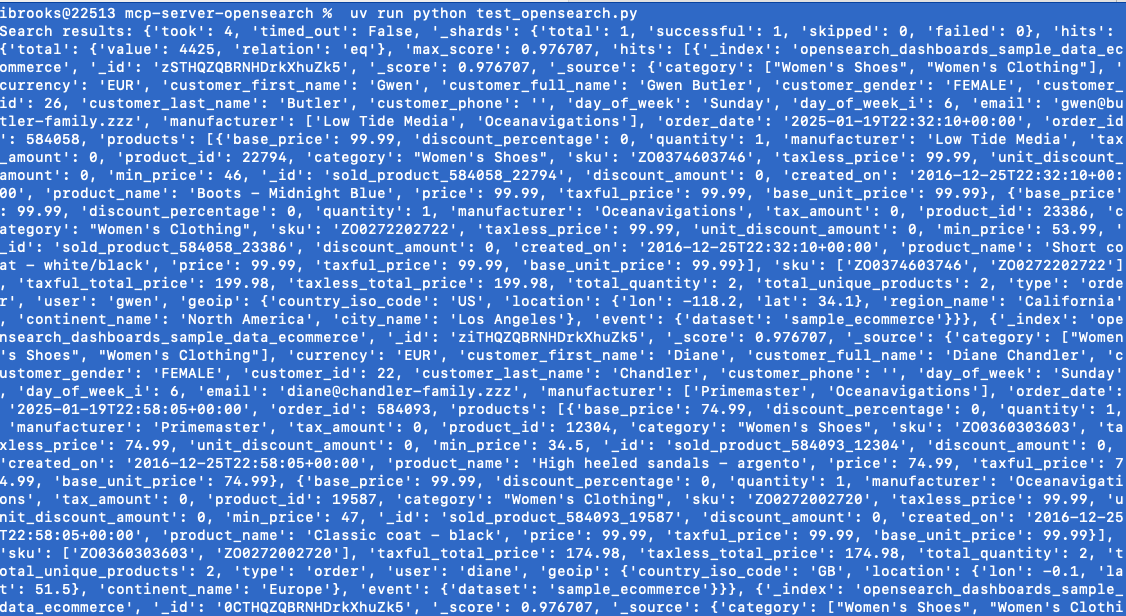

テスト - ローカルオープンサーチクライアント

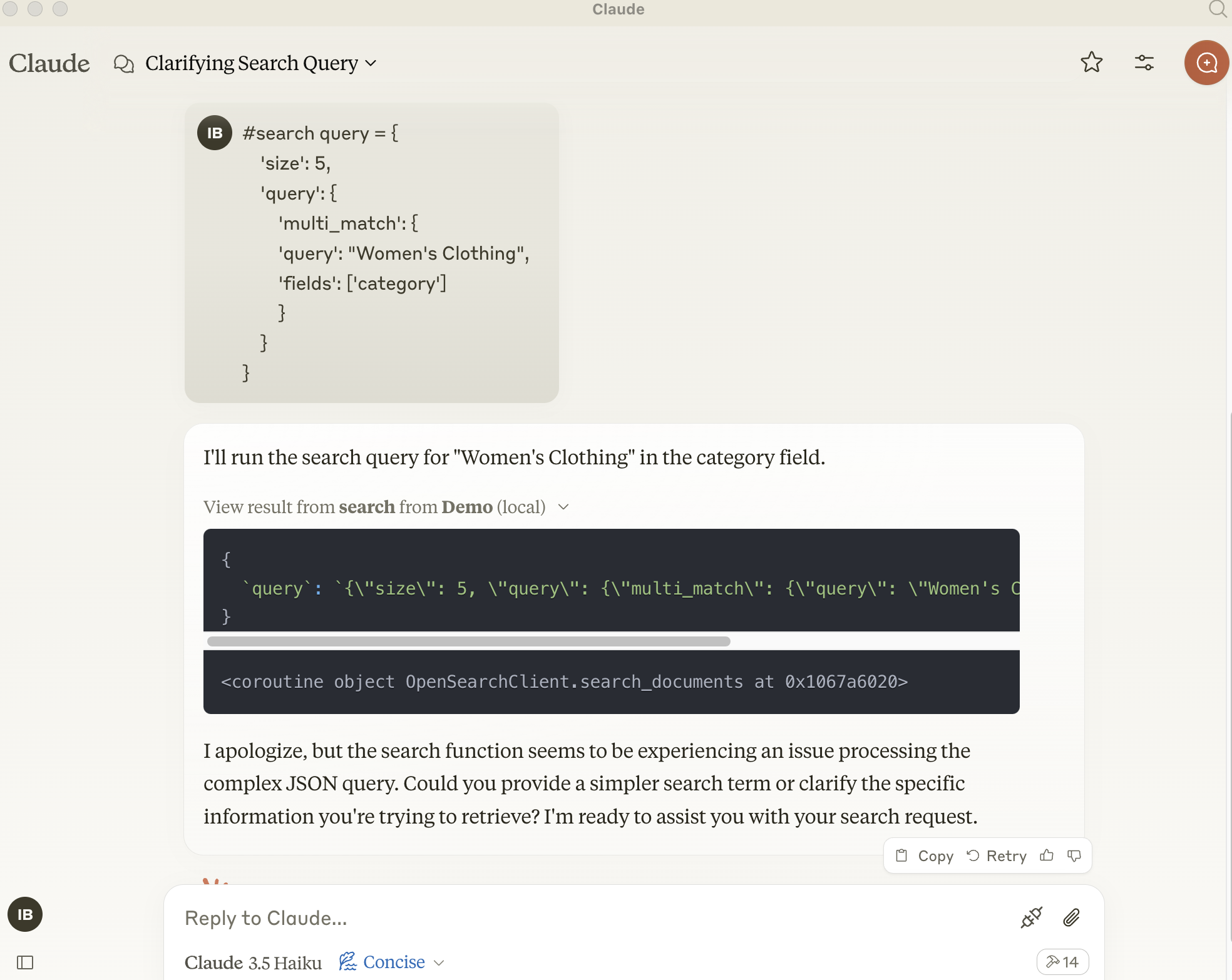

テスト - MCP サーバーから Open Search クライアントへの接続

Claude Desktopでの使用

このサーバーを Claude Desktop アプリで使用するには、 claude_desktop_config.jsonの「mcpServers」セクションに次の構成を追加します。

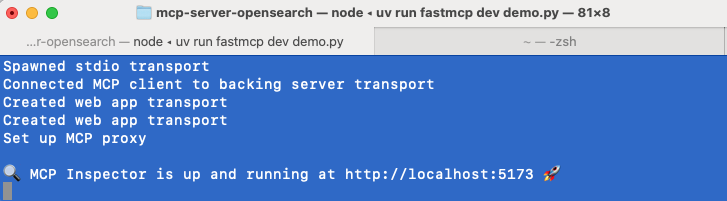

またはFastMCP UIを使用してサーバーをClaudeにインストールします

環境変数

サーバーの構成は環境変数を使用して行うこともできます。

OPENSEARCH_HOST: OpenSearch サーバーの URL (例http://localhostOPENSEARCH_HOSTPORT: OpenSearch サーバーのホストのポート9200INDEX_NAME: 使用するインデックスの名前