mcp-server-opensearch:OpenSearch MCP 服务器

模型上下文协议 (MCP)是一种开放协议,支持 LLM 应用程序与外部数据源和工具之间的无缝集成。无论您是构建 AI 驱动的 IDE、增强聊天界面,还是创建自定义 AI 工作流,MCP 都提供了一种标准化的方式,将 LLM 与其所需的上下文连接起来。

该存储库是如何为分布式搜索和分析引擎OpenSearch创建 MCP 服务器的示例。

正在建设中

当前阻止程序 - OpenSearch 的异步客户端未安装

Related MCP server: MCP DuckDuckGo Search Server

概述

一个基本的模型上下文协议服务器,用于保存和检索开放搜索引擎中的记忆。它充当开放搜索引擎数据库之上的语义记忆层。

成分

工具

search-openSearch将记忆存储在 OpenSearch 数据库中

输入:

query(json):准备好的json查询消息

返回:确认消息

安装

通过 Smithery 安装

要通过Smithery自动为 Claude Desktop 安装 mcp-server-opensearch:

使用 uv(推荐)

使用uv时无需特殊安装即可直接运行mcp-server-opensearch 。

或者

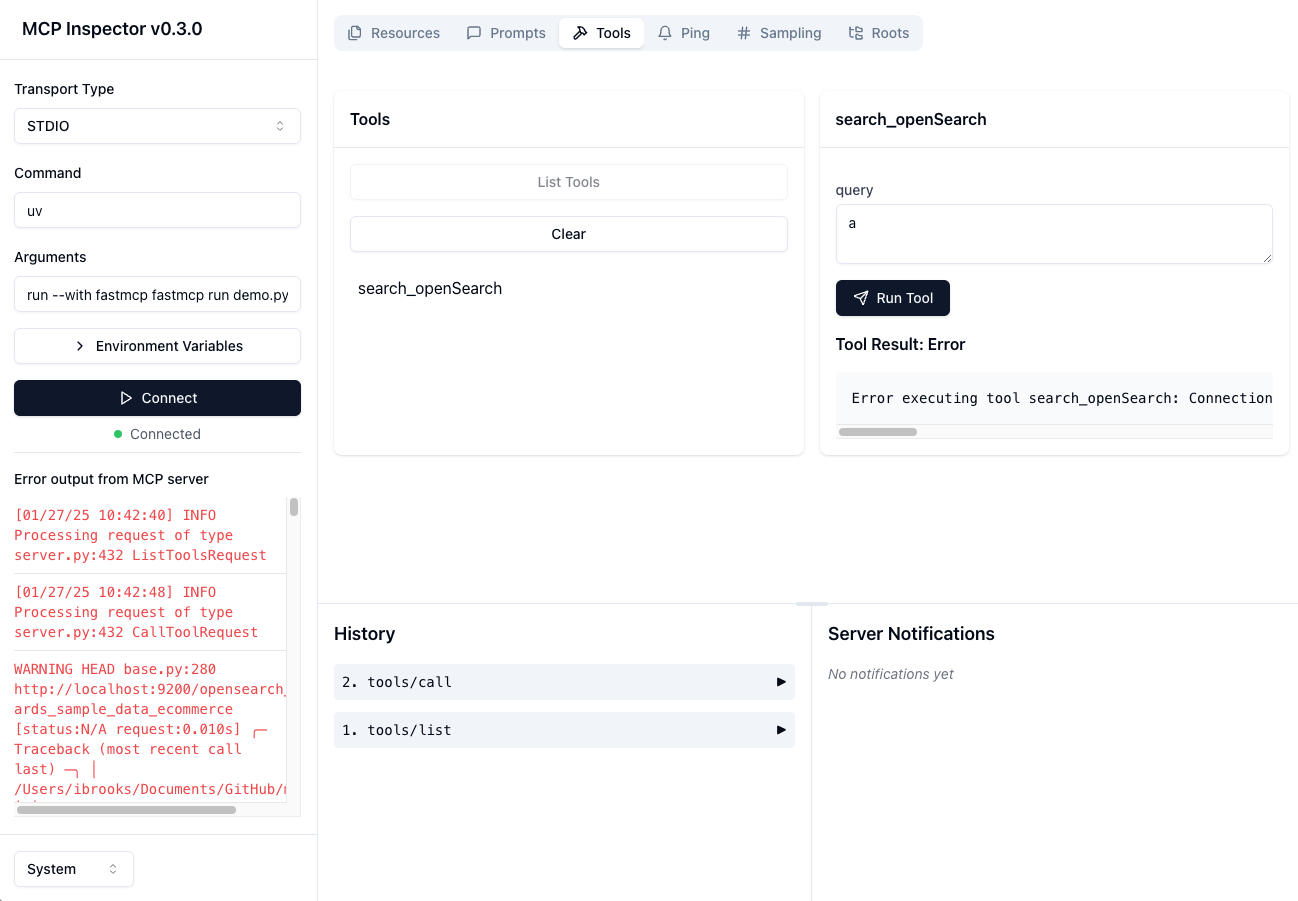

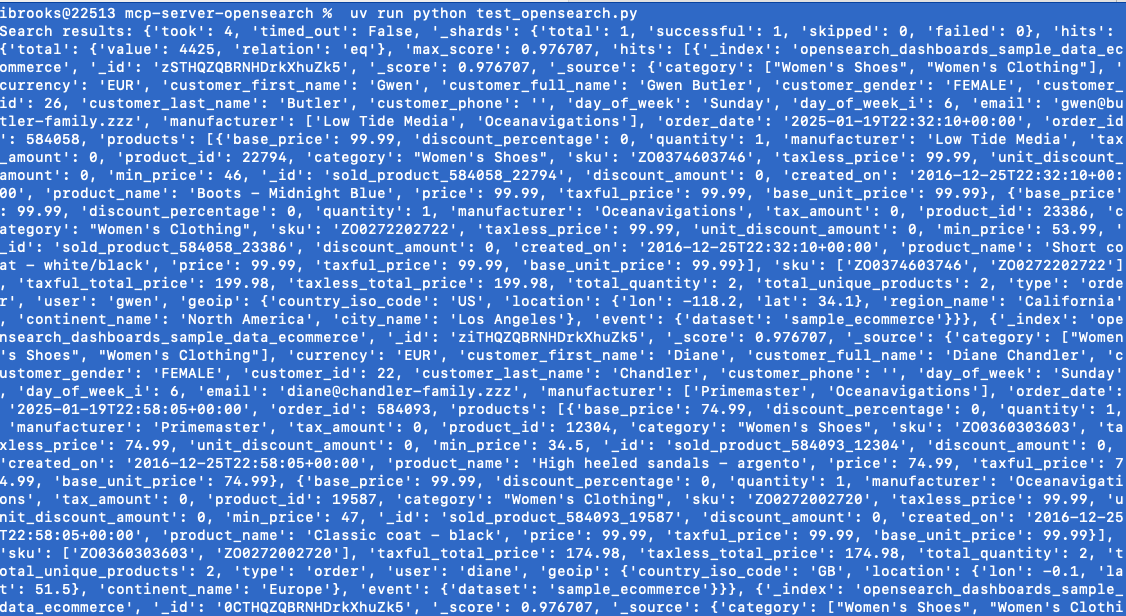

测试 - 本地开放搜索客户端

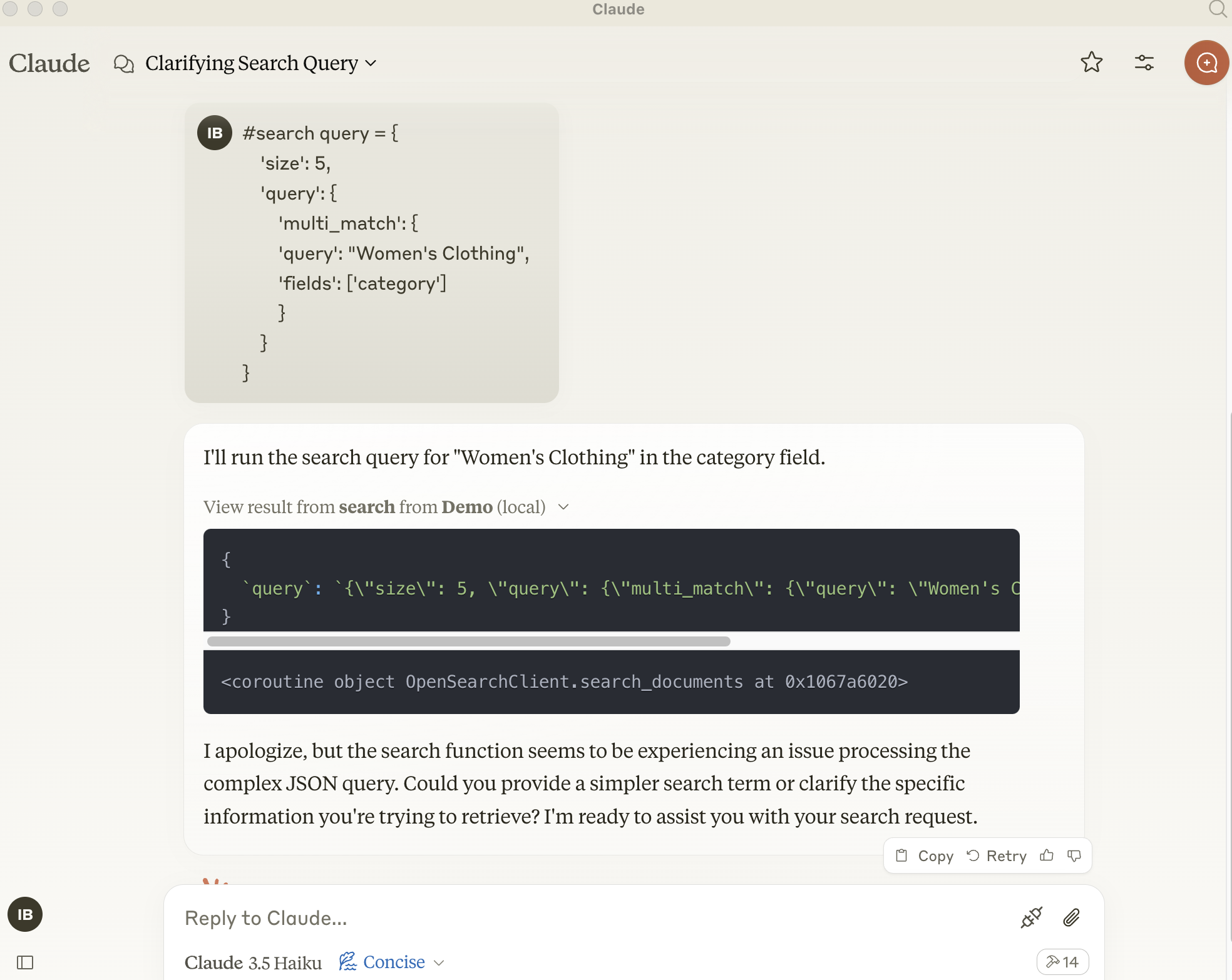

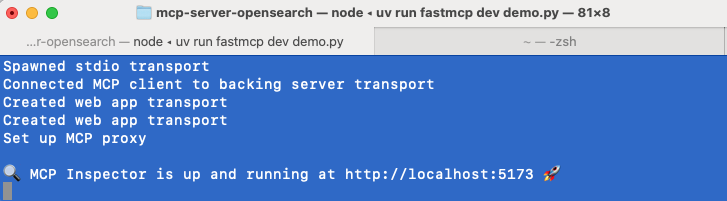

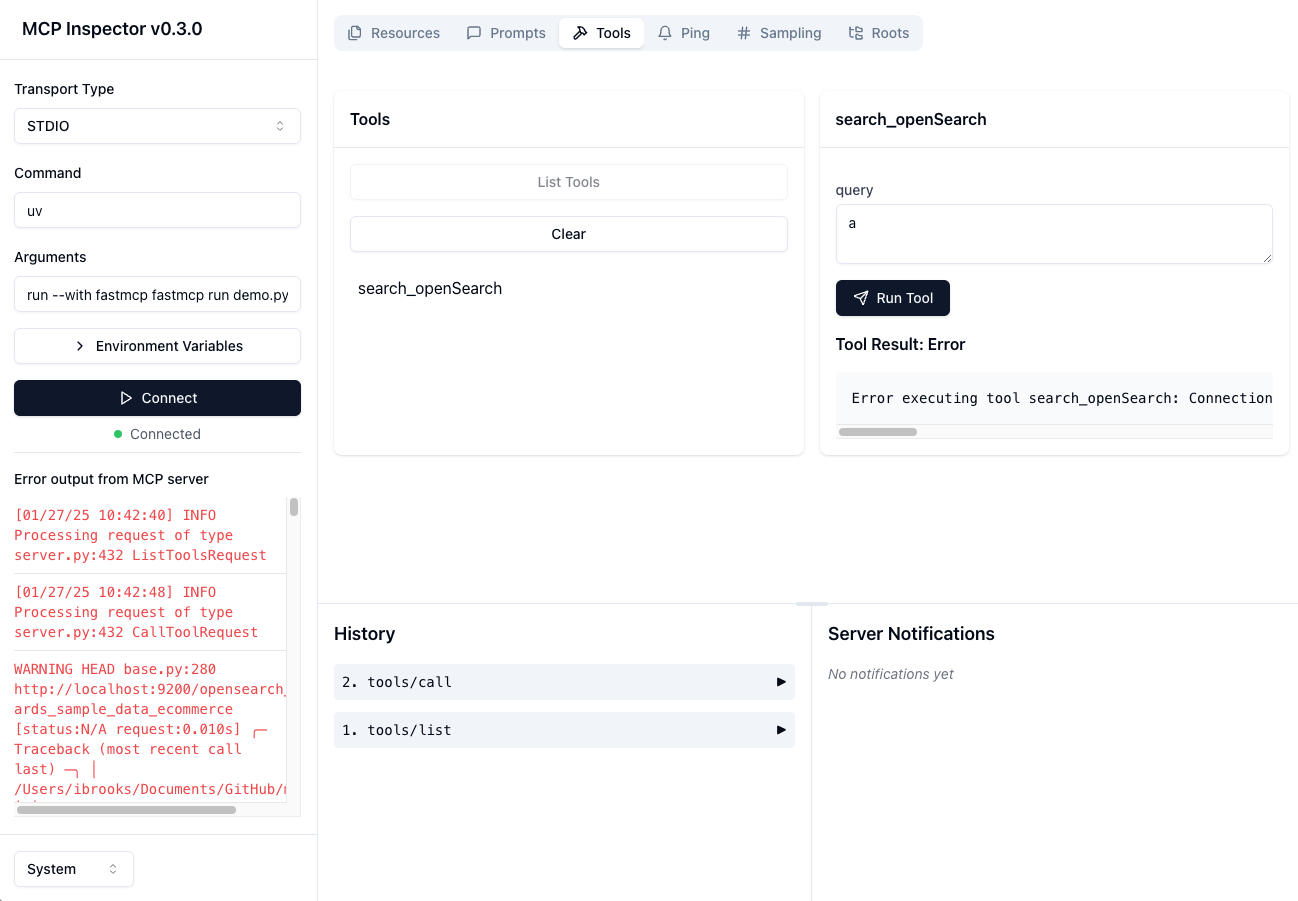

测试 - MCP 服务器连接至 Open Search 客户端

与 Claude Desktop 一起使用

要将此服务器与 Claude Desktop 应用程序一起使用,请将以下配置添加到claude_desktop_config.json的“mcpServers”部分:

或者使用 FastMCP UI 将服务器安装到 Claude

环境变量

也可以使用环境变量来配置服务器:

OPENSEARCH_HOST:OpenSearch 服务器的 URL,例如http://localhostOPENSEARCH_HOSTPORT:OpenSearch 服务器主机的端口9200INDEX_NAME:要使用的索引的名称