mcp-server-opensearch: OpenSearch MCP 서버

모델 컨텍스트 프로토콜(MCP) 은 LLM 애플리케이션과 외부 데이터 소스 및 도구 간의 원활한 통합을 지원하는 개방형 프로토콜입니다. AI 기반 IDE를 구축하거나, 채팅 인터페이스를 개선하거나, 맞춤형 AI 워크플로를 만드는 경우, MCP는 LLM을 필요한 컨텍스트에 연결하는 표준화된 방법을 제공합니다.

이 저장소는 분산 검색 및 분석 엔진인 OpenSearch를 위한 MCP 서버를 만드는 방법의 예입니다.

공사 중

현재 차단기 - OpenSearch의 비동기 클라이언트가 설치되지 않습니다.

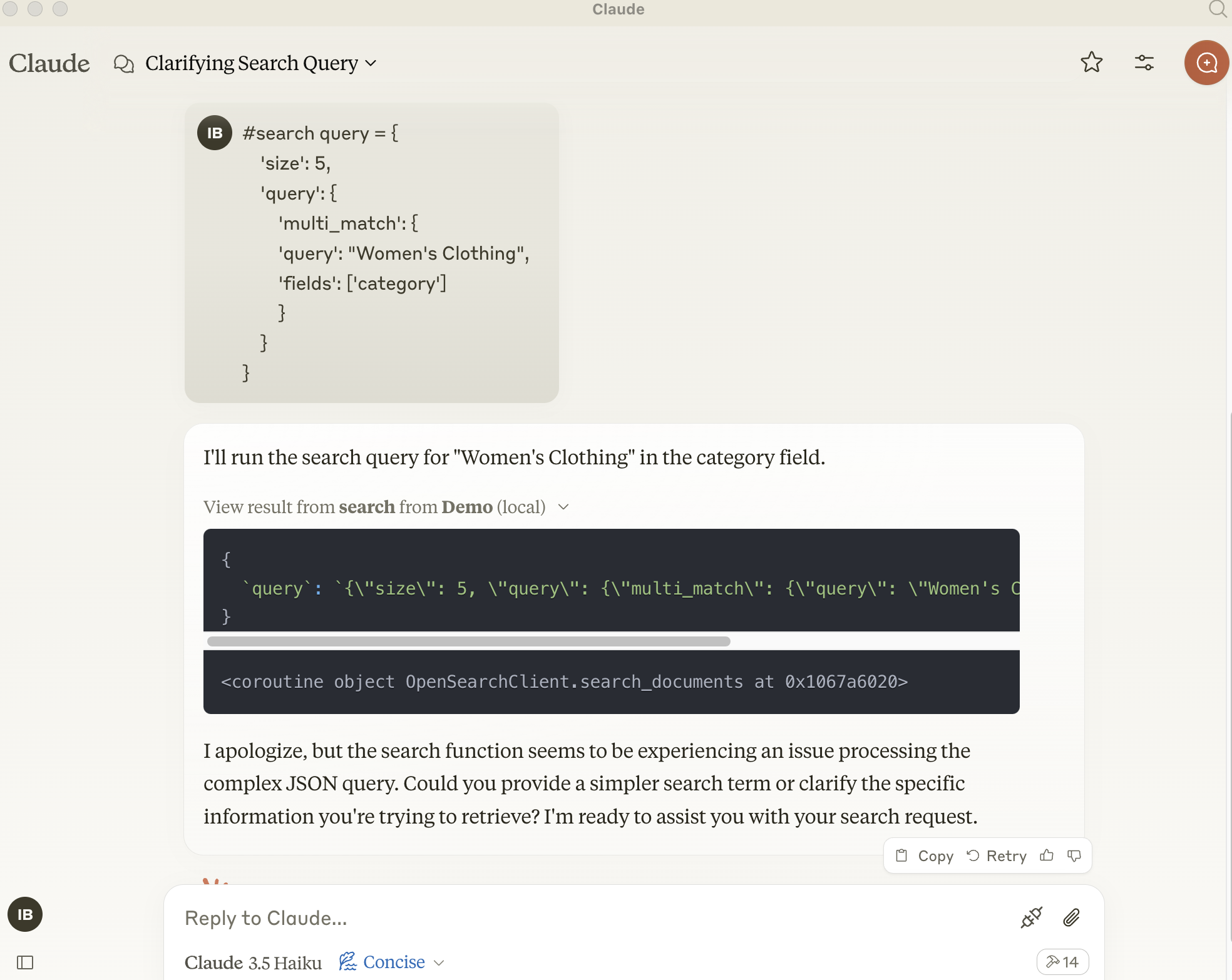

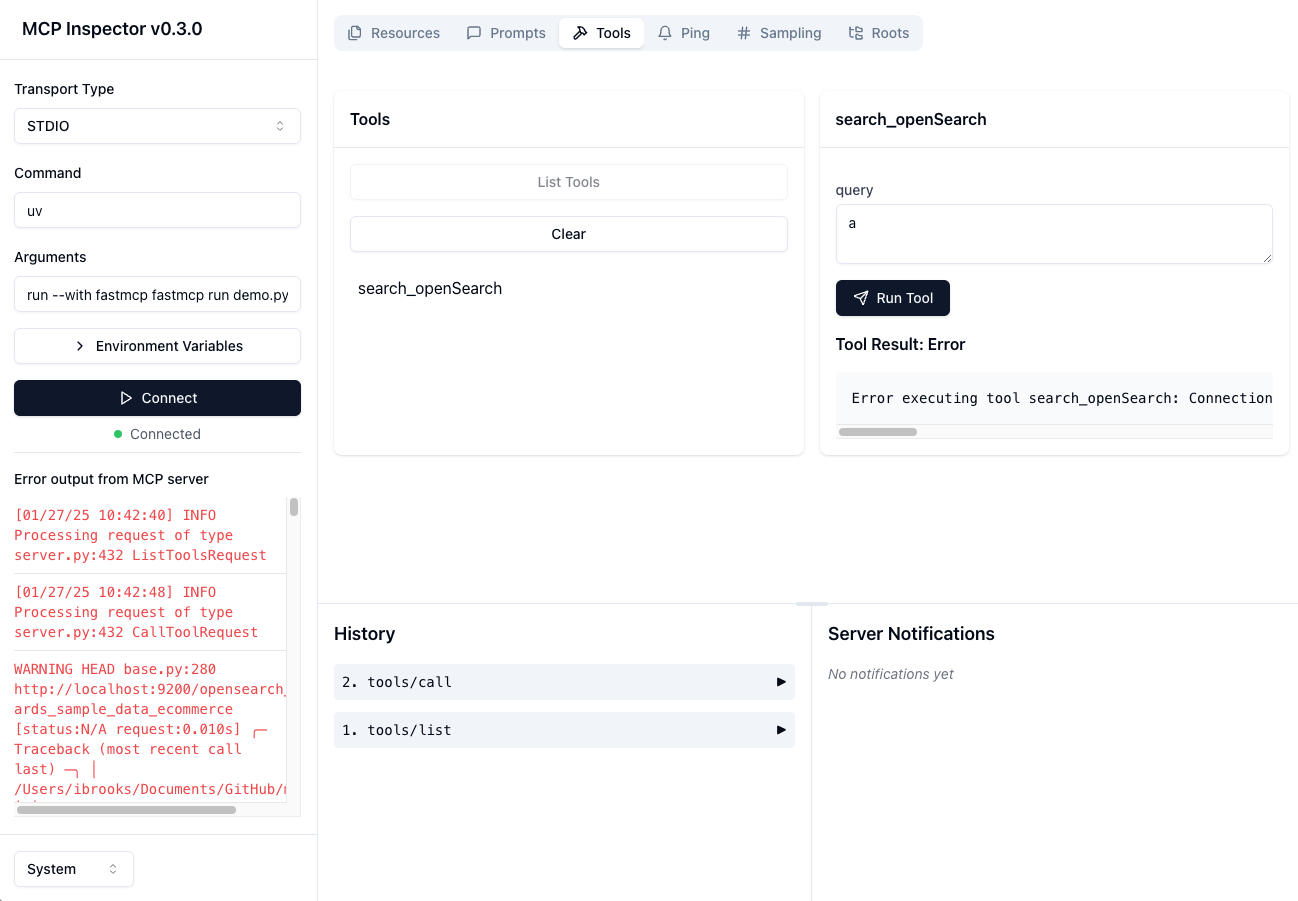

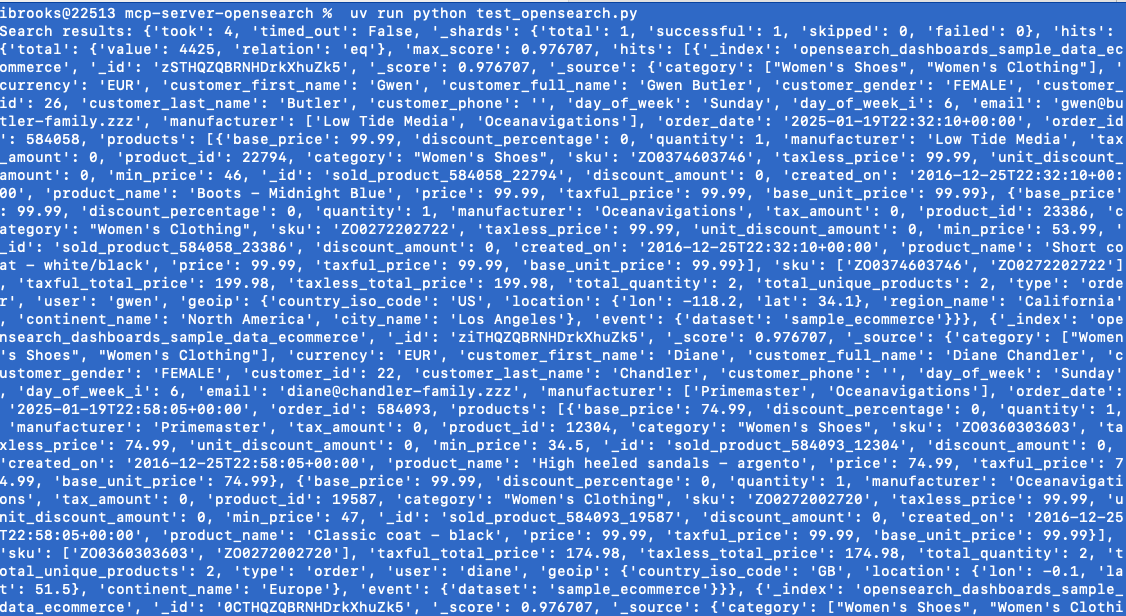

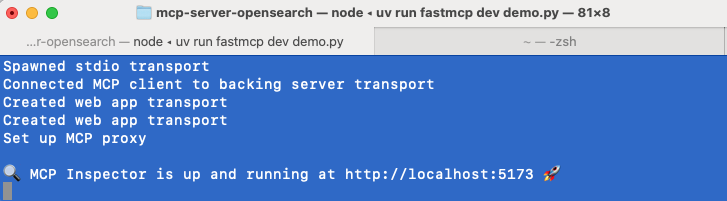

지엑스피1

Related MCP server: MCP DuckDuckGo Search Server

개요

OpenSearch 엔진에서 메모리를 보관하고 검색하는 기본 모델 컨텍스트 프로토콜 서버입니다. OpenSearch 데이터베이스 위에서 의미론적 메모리 계층 역할을 합니다.

구성 요소

도구

search-openSearchOpenSearch 데이터베이스에 메모리 저장

입력:

query(json): 준비된 json 쿼리 메시지

반환: 확인 메시지

설치

Smithery를 통해 설치

Smithery를 통해 Claude Desktop용 mcp-server-opensearch를 자동으로 설치하려면:

uv 사용(권장)

uv 사용하면 mcp-server-opensearch를 직접 실행하기 위해 특별한 설치가 필요하지 않습니다.

또는

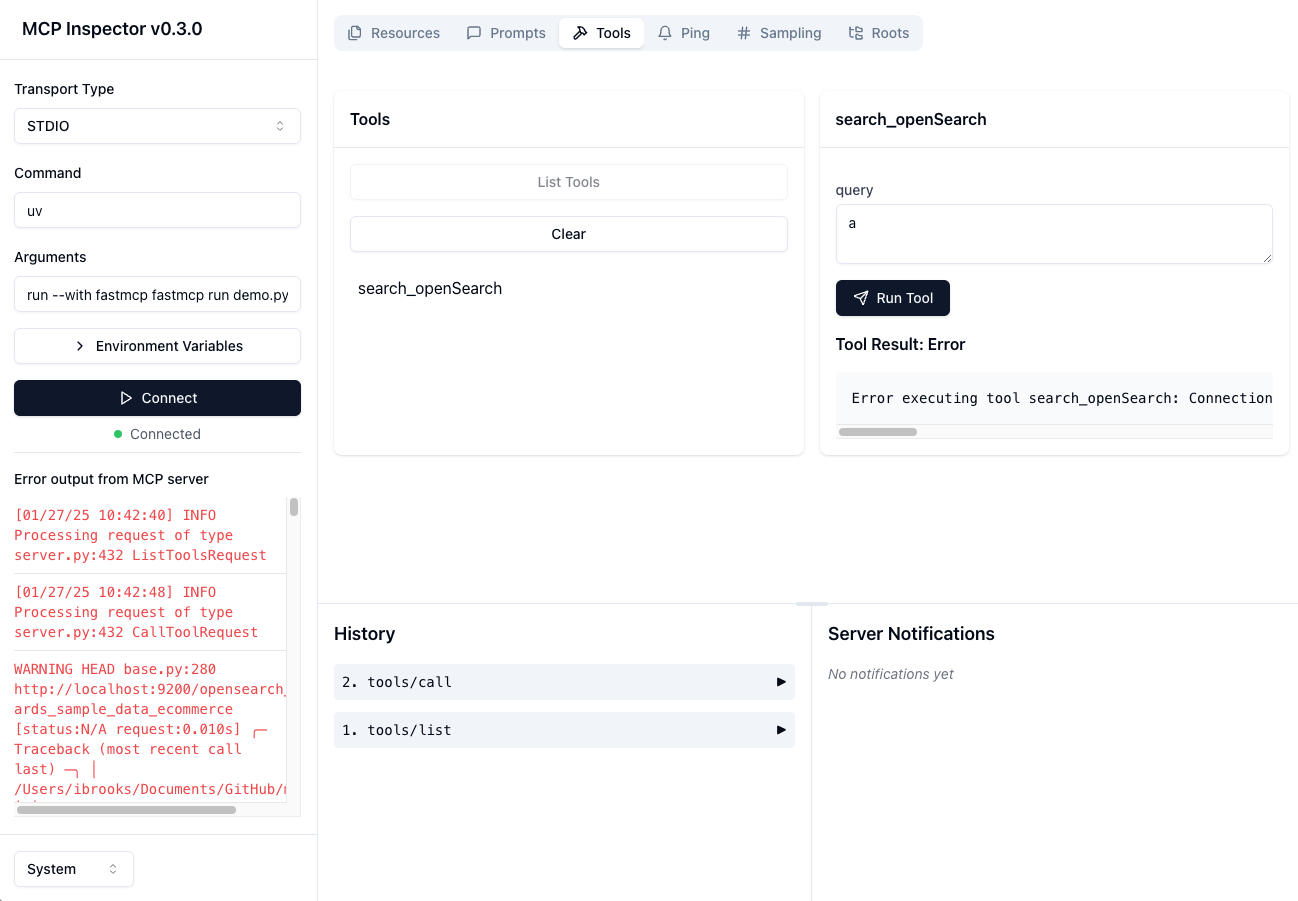

테스트 - 로컬 오픈 검색 클라이언트

테스트 - MCP 서버와 Open Search 클라이언트 연결

Claude Desktop과 함께 사용

Claude Desktop 앱과 함께 이 서버를 사용하려면 claude_desktop_config.json 의 "mcpServers" 섹션에 다음 구성을 추가하세요.

또는 FastMCP UI를 사용하여 Claude에 서버를 설치합니다.

환경 변수

서버 구성은 환경 변수를 사용하여 수행할 수도 있습니다.

OPENSEARCH_HOST: OpenSearch 서버의 URL, 예http://localhostOPENSEARCH_HOSTPORT: OpenSearch 서버 호스트의 포트9200INDEX_NAME: 사용할 인덱스의 이름