MCP Wolfram Alpha(服务器+客户端)

将 Wolfram Alpha 无缝集成到您的聊天应用程序中。

该项目实现了一个 MCP(模型上下文协议)服务器,旨在与 Wolfram Alpha API 交互。它使基于聊天的应用程序能够执行计算查询并检索结构化知识,从而实现高级对话功能。

其中包括一个通过 LangChain 利用 Gemini 的 MCP-Client 示例,演示如何将大型语言模型连接到 MCP 服务器,以便与 Wolfram Alpha 的知识引擎进行实时交互。

特征

Wolfram|Alpha 集成用于数学、科学和数据查询。

模块化架构可轻松扩展以支持额外的 API 和功能。

多客户端支持无缝处理来自多个客户端或界面的交互。

使用 Gemini 的MCP-Client 示例(通过 LangChain)。

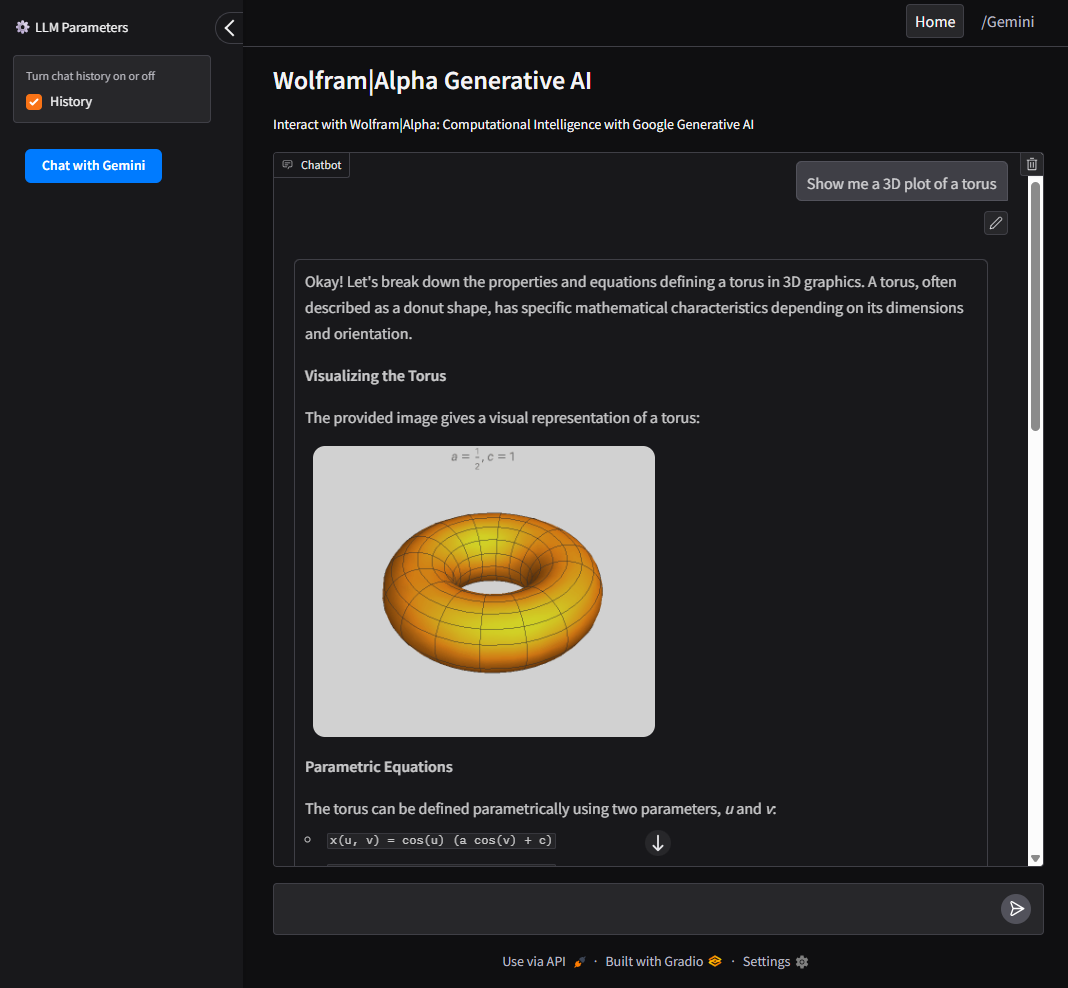

UI 支持使用 Gradio 来实现用户友好的 Web 界面与 Google AI 和 Wolfram Alpha MCP 服务器进行交互。

Related MCP server: Maya MCP

安装

克隆 Repo

设置环境变量

根据示例创建一个 .env 文件:

WOLFRAM_API_KEY=你的_wolframalpha_appid

GeminiAPI=your_google_gemini_api_key (如果使用下面的客户端方法,则为可选。)

安装要求

配置

要与 VSCode MCP 服务器一起使用:

在项目根目录中创建一个配置文件

.vscode/mcp.json。使用

configs/vscode_mcp.json中提供的示例作为模板。更多详细信息,请参阅VSCode MCP 服务器指南。

与 Claude Desktop 一起使用:

客户端使用示例

该项目包括一个与 MCP 服务器通信的 LLM 客户端。

使用 Gradio UI 运行

必需:GeminiAPI

提供本地网络界面与 Google AI 和 Wolfram Alpha 进行交互。

要从命令行直接运行客户端:

Docker

要在 Docker 容器内构建并运行客户端:

用户界面

使用 Gradio 构建的直观界面可与 Google AI(Gemini)和 Wolfram Alpha MCP 服务器进行交互。

允许用户在 Wolfram Alpha、Google AI(Gemini)和查询历史记录之间切换。

作为 CLI 工具运行

必需:GeminiAPI

要从命令行直接运行客户端:

Docker

要在 Docker 容器内构建并运行客户端: