MCP Wolfram Alpha (Сервер + Клиент)

Легко интегрируйте Wolfram Alpha в ваши чат-приложения.

Этот проект реализует сервер MCP (Model Context Protocol), разработанный для взаимодействия с API Wolfram Alpha. Он позволяет приложениям на основе чата выполнять вычислительные запросы и извлекать структурированные знания, облегчая расширенные возможности общения.

В комплект входит пример MCP-клиента, использующего Gemini через LangChain, демонстрирующий, как подключать большие языковые модели к серверу MCP для взаимодействия в реальном времени с ядром знаний Wolfram Alpha.

Функции

Wolfram|Alpha Integration для математических, научных и информационных запросов.

Модульная архитектура Легко расширяется для поддержки дополнительных API и функций.

Поддержка нескольких клиентов. Удобная обработка взаимодействий с несколькими клиентами или интерфейсами.

Пример MCP-клиента с использованием Gemini (через LangChain).

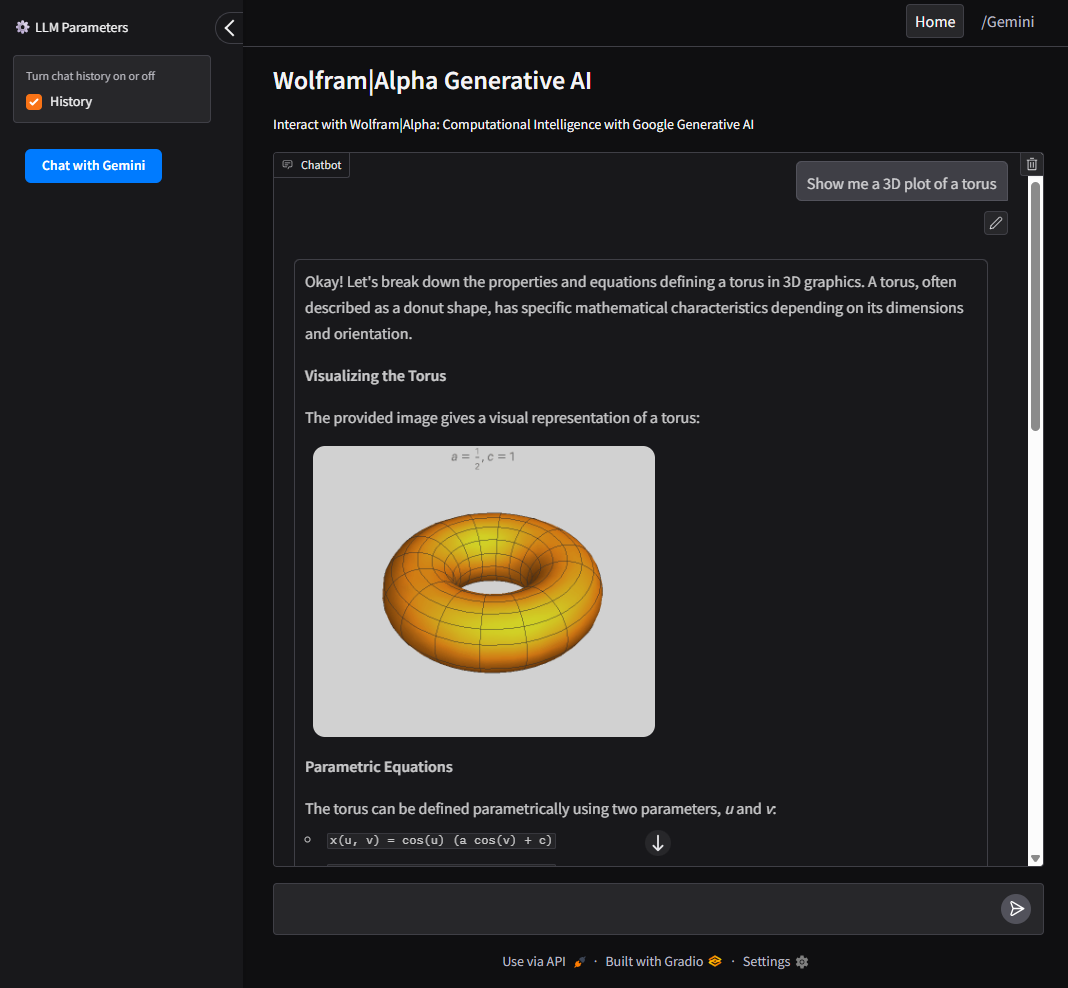

Поддержка пользовательского интерфейса с использованием Gradio для удобного веб-интерфейса взаимодействия с Google AI и сервером Wolfram Alpha MCP.

Related MCP server: Maya MCP

Установка

Клонировать репозиторий

Настройка переменных среды

Создайте файл .env на основе примера:

WOLFRAM_API_KEY=your_wolframalpha_appid

GeminiAPI=your_google_gemini_api_key (Необязательно, если используется клиентский метод, описанный ниже.)

Требования к установке

Конфигурация

Для использования с сервером VSCode MCP:

Создайте файл конфигурации

.vscode/mcp.jsonв корневом каталоге вашего проекта.Используйте пример, представленный в

configs/vscode_mcp.jsonв качестве шаблона.Более подробную информацию можно найти в Руководстве по серверу VSCode MCP .

Для использования с Claude Desktop:

Пример использования клиентом

Этот проект включает в себя клиент LLM, который взаимодействует с сервером MCP.

Запуск с помощью Gradio UI

Требуется: GeminiAPI

Предоставляет локальный веб-интерфейс для взаимодействия с Google AI и Wolfram Alpha.

Чтобы запустить клиент непосредственно из командной строки:

Докер

Чтобы собрать и запустить клиент внутри контейнера Docker:

Пользовательский интерфейс

Интуитивно понятный интерфейс, созданный с помощью Gradio для взаимодействия как с Google AI (Gemini), так и с сервером Wolfram Alpha MCP.

Позволяет пользователям переключаться между Wolfram Alpha, Google AI (Gemini) и историей запросов.

Запустить как CLI-инструмент

Требуется: GeminiAPI

Чтобы запустить клиент непосредственно из командной строки:

Докер

Чтобы собрать и запустить клиент внутри контейнера Docker: