MCP Wolfram Alpha (サーバー + クライアント)

Wolfram Alpha をチャット アプリケーションにシームレスに統合します。

このプロジェクトは、Wolfram Alpha APIとのインターフェースとして設計されたMCP(Model Context Protocol)サーバーを実装します。これにより、チャットベースのアプリケーションは計算クエリを実行し、構造化された知識を取得できるようになり、高度な会話機能を実現できます。

LangChain 経由で Gemini を利用する MCP クライアントの例が含まれており、大規模な言語モデルを MCP サーバーに接続して、Wolfram Alpha の知識エンジンとリアルタイムでやりとりする方法が示されています。

特徴

数学、科学、データクエリのためのWolfram|Alpha 統合。

モジュラー アーキテクチャ追加の API と機能をサポートするために簡単に拡張できます。

マルチクライアント サポート複数のクライアントまたはインターフェースからのやり取りをシームレスに処理します。

Gemini を使用したMCP クライアントの例(LangChain 経由)。

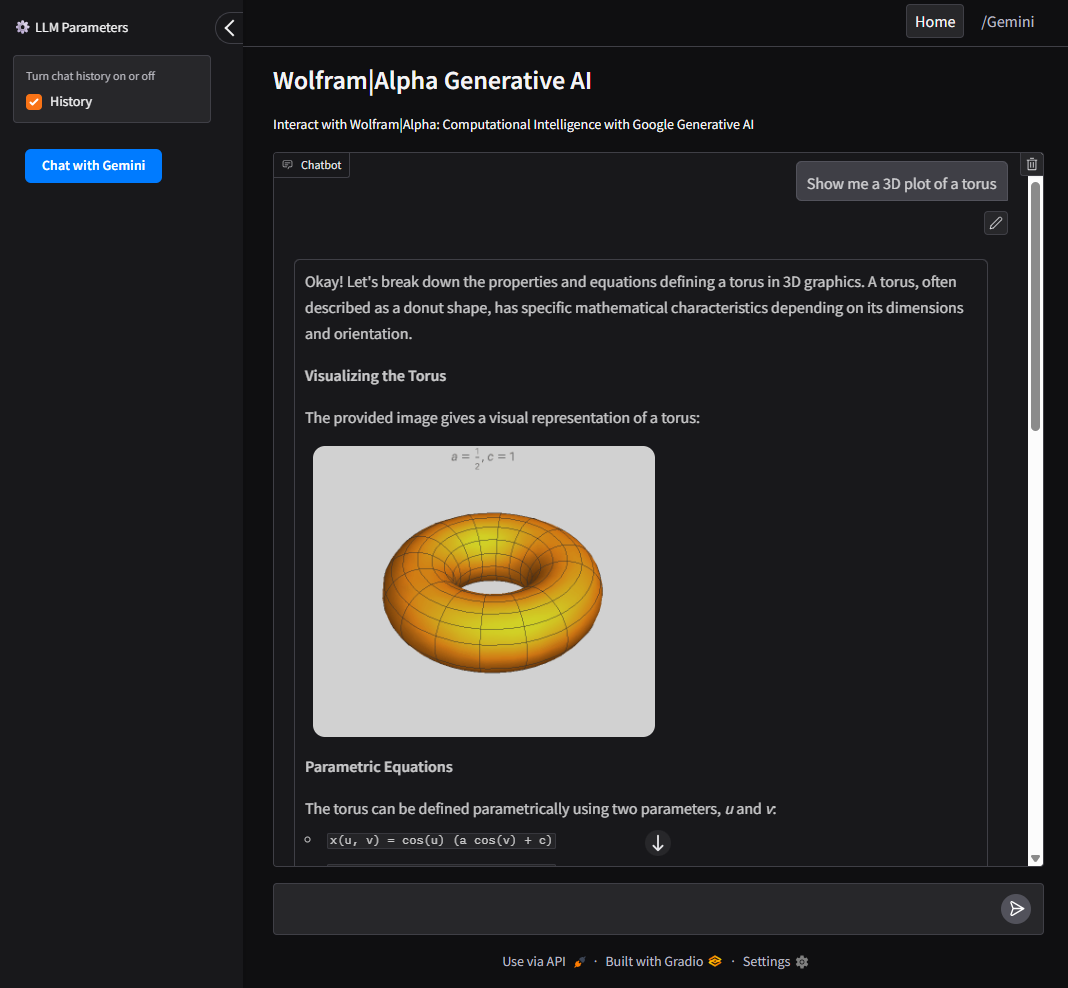

Google AI および Wolfram Alpha MCP サーバーと対話するためのユーザーフレンドリーな Web インターフェースとして Gradio を使用したUI サポート。

Related MCP server: Maya MCP

インストール

リポジトリをクローンする

環境変数を設定する

例に基づいて .env ファイルを作成します。

WOLFRAM_API_KEY=あなたのwolframalpha_appid

GeminiAPI=your_google_gemini_api_key (以下のクライアント方式を使用する場合はオプション)

インストール要件

構成

VSCode MCP サーバーで使用するには:

プロジェクト ルートの

.vscode/mcp.jsonに構成ファイルを作成します。configs/vscode_mcp.jsonで提供されている例をテンプレートとして使用します。詳細については、 VSCode MCP サーバー ガイドを参照してください。

Claude Desktop で使用するには:

クライアントの使用例

このプロジェクトには、MCP サーバーと通信する LLM クライアントが含まれています。

Gradio UIで実行

必須: GeminiAPI

Google AI および Wolfram Alpha と対話するためのローカル Web インターフェースを提供します。

コマンドラインからクライアントを直接実行するには:

ドッカー

Docker コンテナ内でクライアントをビルドして実行するには:

UI

Gradio で構築された直感的なインターフェースで、Google AI (Gemini) と Wolfram Alpha MCP サーバーの両方と対話できます。

ユーザーは Wolfram Alpha、Google AI (Gemini)、クエリ履歴を切り替えることができます。

CLIツールとして実行

必須: GeminiAPI

コマンドラインからクライアントを直接実行するには:

ドッカー

Docker コンテナ内でクライアントをビルドして実行するには: