MCP Wolfram Alpha(서버 + 클라이언트)

Wolfram Alpha를 채팅 애플리케이션에 완벽하게 통합하세요.

이 프로젝트는 Wolfram Alpha API와 연동되도록 설계된 MCP(Model Context Protocol) 서버를 구현합니다. 이 서버를 통해 채팅 기반 애플리케이션은 계산 쿼리를 수행하고 구조화된 지식을 검색하여 고급 대화 기능을 활용할 수 있습니다.

LangChain을 통해 Gemini를 활용하는 MCP-Client 예제가 포함되어 있으며, Wolfram Alpha의 지식 엔진과 실시간으로 상호 작용하기 위해 대규모 언어 모델을 MCP 서버에 연결하는 방법을 보여줍니다.

특징

수학, 과학 및 데이터 쿼리를 위한 Wolfram|Alpha 통합 .

모듈식 아키텍처 추가 API 및 기능을 지원하도록 쉽게 확장 가능합니다.

다중 클라이언트 지원 여러 클라이언트나 인터페이스의 상호작용을 원활하게 처리합니다.

Gemini를 사용한 MCP-Client 예제 (LangChain을 통해).

Google AI 및 Wolfram Alpha MCP 서버와 상호 작용할 수 있는 사용자 친화적인 웹 인터페이스를 제공하는 Gradio를 사용한 UI 지원 .

Related MCP server: Maya MCP

설치

저장소 복제

지엑스피1

환경 변수 설정

다음 예를 기반으로 .env 파일을 만듭니다.

WOLFRAM_API_KEY=당신의_울프라말파_앱ID

GeminiAPI=your_google_gemini_api_key (아래의 클라이언트 방법을 사용하는 경우 선택 사항)

설치 요구 사항

구성

VSCode MCP 서버와 함께 사용하려면:

프로젝트 루트의

.vscode/mcp.json에 구성 파일을 만듭니다.configs/vscode_mcp.json에 제공된 예를 템플릿으로 사용하세요.자세한 내용은 VSCode MCP 서버 가이드 를 참조하세요.

Claude Desktop과 함께 사용하려면:

클라이언트 사용 예

이 프로젝트에는 MCP 서버와 통신하는 LLM 클라이언트가 포함되어 있습니다.

Gradio UI로 실행

필수: GeminiAPI

Google AI 및 Wolfram Alpha와 상호작용할 수 있는 로컬 웹 인터페이스를 제공합니다.

명령줄에서 직접 클라이언트를 실행하려면:

도커

Docker 컨테이너 내에서 클라이언트를 빌드하고 실행하려면:

사용자 인터페이스

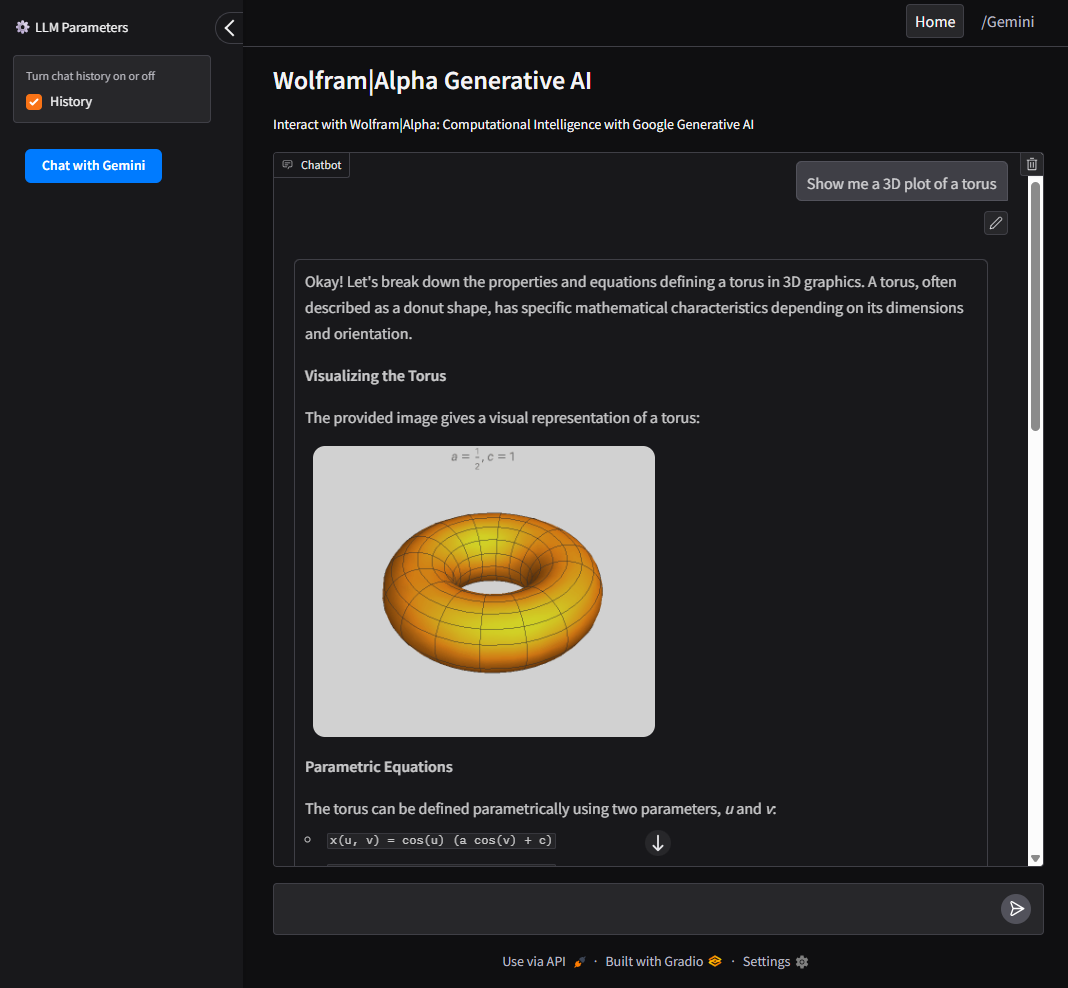

Google AI(Gemini)와 Wolfram Alpha MCP 서버 모두와 상호 작용할 수 있도록 Gradio로 구축된 직관적인 인터페이스입니다.

사용자가 Wolfram Alpha, Google AI(Gemini), 쿼리 기록 간을 전환할 수 있습니다.

CLI 도구로 실행

필수: GeminiAPI

명령줄에서 직접 클라이언트를 실행하려면:

도커

Docker 컨테이너 내에서 클라이언트를 빌드하고 실행하려면: