Vertex AI Search 的 MCP 服务器

这是一个使用 Vertex AI 搜索文档的 MCP 服务器。

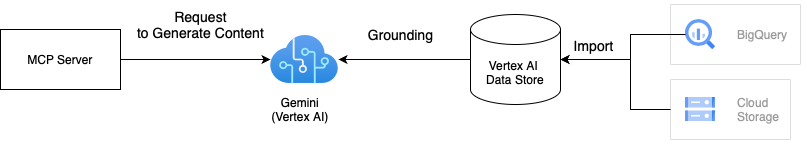

建筑学

此解决方案结合 Gemini 与 Vertex AI 基础功能,使用您的私人数据搜索文档。基础功能通过将 Gemini 的响应与存储在 Vertex AI 数据存储区中的数据相结合,从而提高搜索结果的质量。我们可以将一个或多个 Vertex AI 数据存储区集成到 MCP 服务器。有关基础功能的更多详细信息,请参阅Vertex AI 基础文档。

Related MCP server: Vertex AI MCP Server

如何使用

有两种方法可以使用此 MCP 服务器。如果您想在 Docker 上运行它,则第一种方法比较好,因为项目中提供了 Dockerfile。

1. 克隆存储库

# Clone the repository

git clone git@github.com:ubie-oss/mcp-vertexai-search.git

# Create a virtual environment

uv venv

# Install the dependencies

uv sync --all-extras

# Check the command

uv run mcp-vertexai-search安装python包

该软件包尚未发布到 PyPI,但我们可以从仓库中安装它。我们需要一个源自config.yml.template的配置文件来运行 MCP 服务器,因为 Python 软件包中不包含配置模板。有关配置文件的详细信息,请参阅附录 A:配置文件。

# Install the package

pip install git+https://github.com/ubie-oss/mcp-vertexai-search.git

# Check the command

mcp-vertexai-search --help发展

先决条件

Vertex AI 数据存储

请参阅有关数据存储的官方文档以获取更多信息

设置本地环境

# Optional: Install uv

python -m pip install -r requirements.setup.txt

# Create a virtual environment

uv venv

uv sync --all-extras运行 MCP 服务器

它支持两种传输方式:SSE(服务器发送事件)和 stdio(标准输入输出)。我们可以通过设置--transport标志来控制传输。

我们可以使用 YAML 文件配置 MCP 服务器。config.yml.template是配置文件的模板。请根据自己的需求修改配置文件。

uv run mcp-vertexai-search serve \

--config config.yml \

--transport <stdio|sse>测试 Vertex AI 搜索

我们可以在不使用 MCP 服务器的情况下使用mcp-vertexai-search search命令来测试 Vertex AI Search。

uv run mcp-vertexai-search search \

--config config.yml \

--query <your-query>附录 A:配置文件

config.yml.template是配置文件的模板。

serverserver.name:MCP 服务器的名称

modelmodel.model_name:Vertex AI 模型的名称model.project_id:Vertex AI 模型的项目 IDmodel.location:模型的位置(例如 us-central1)model.impersonate_service_account:要模拟的服务帐户model.generate_content_config:生成内容 API 的配置

data_stores:Vertex AI 数据存储列表data_stores.project_id:Vertex AI 数据存储的项目 IDdata_stores.location:Vertex AI 数据存储的位置(例如我们)data_stores.datastore_id:Vertex AI 数据存储的 IDdata_stores.tool_name:工具的名称data_stores.description:Vertex AI 数据存储的描述