Vertex AI Search 用 MCP サーバー

これは、Vertex AI を使用してドキュメントを検索するための MCP サーバーです。

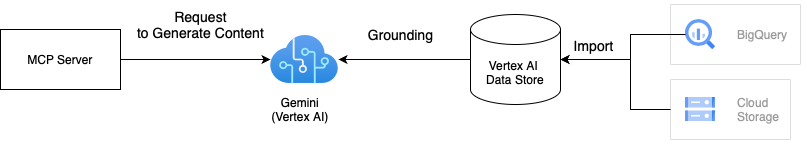

建築

このソリューションは、GeminiとVertex AI Groundingを活用し、お客様のプライベートデータを使用してドキュメントを検索します。Groundingは、GeminiのレスポンスをVertex AI Datastoreに保存されているデータにグラウンディングすることで、検索結果の品質を向上させます。MCPサーバーには、1つまたは複数のVertex AIデータストアを統合できます。Groundingの詳細については、 Vertex AI Groundingのドキュメントをご覧ください。

Related MCP server: Vertex AI MCP Server

使い方

このMCPサーバーを使用するには2つの方法があります。Docker上で実行したい場合は、プロジェクト内にDockerfileが提供されているため、最初の方法をお勧めします。

1. リポジトリをクローンする

# Clone the repository

git clone git@github.com:ubie-oss/mcp-vertexai-search.git

# Create a virtual environment

uv venv

# Install the dependencies

uv sync --all-extras

# Check the command

uv run mcp-vertexai-searchPythonパッケージをインストールする

このパッケージはまだPyPIに公開されていませんが、リポジトリからインストールできます。MCPサーバーを実行するには、 config.yml.templateから派生した設定ファイルが必要です。Pythonパッケージには設定テンプレートが含まれていないためです。設定ファイルの詳細については、付録A「設定ファイル」を参照してください。

# Install the package

pip install git+https://github.com/ubie-oss/mcp-vertexai-search.git

# Check the command

mcp-vertexai-search --help発達

前提条件

Vertex AI データストア

詳細については、データストアに関する公式ドキュメントをご覧ください。

ローカル環境の設定

# Optional: Install uv

python -m pip install -r requirements.setup.txt

# Create a virtual environment

uv venv

uv sync --all-extrasMCPサーバーを実行する

これはSSE(Server-Sent Events)とstdio(Standard Input Output)の2つのトランスポートをサポートしています。-- --transportフラグを設定することでトランスポートを制御できます。

MCPサーバーはYAMLファイルで設定できます。config.yml.templateは設定ファイルのテンプレートです。必要に応じて設定ファイルを修正してください。

uv run mcp-vertexai-search serve \

--config config.yml \

--transport <stdio|sse>Vertex AI Searchをテストする

MCP サーバーなしでmcp-vertexai-search searchコマンドを使用して Vertex AI Search をテストできます。

uv run mcp-vertexai-search search \

--config config.yml \

--query <your-query>付録A: 設定ファイル

config.yml.templateは設定ファイルのテンプレートです。

serverserver.name: MCPサーバーの名前

modelmodel.model_name: Vertex AI モデルの名前model.project_id: Vertex AI モデルのプロジェクト IDmodel.location: モデルの場所(例:us-central1)model.impersonate_service_account: 偽装するサービスアカウントmodel.generate_content_config: コンテンツ生成APIの設定

data_stores: Vertex AI データストアのリストdata_stores.project_id: Vertex AI データストアのプロジェクト IDdata_stores.location: Vertex AI データストアの場所 (例: us)data_stores.datastore_id: Vertex AI データストアのIDdata_stores.tool_name: ツールの名前data_stores.description: Vertex AI データストアの説明