Servidor MCP para Vertex AI Search

Este es un servidor MCP para buscar documentos utilizando Vertex AI.

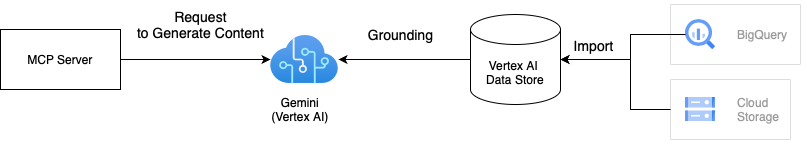

Arquitectura

Esta solución utiliza Gemini con Vertex AI Grounding para buscar documentos utilizando sus datos privados. Grounding mejora la calidad de los resultados de búsqueda al integrar las respuestas de Gemini con sus datos almacenados en el almacén de datos de Vertex AI. Podemos integrar uno o varios almacenes de datos de Vertex AI en el servidor MCP. Para más información sobre grounding, consulte la documentación de Vertex AI Grounding .

Related MCP server: Vertex AI MCP Server

Cómo utilizar

Hay dos maneras de usar este servidor MCP. Si desea ejecutarlo en Docker, la primera opción es recomendable, ya que el proyecto incluye Dockerfile.

1. Clonar el repositorio

# Clone the repository

git clone git@github.com:ubie-oss/mcp-vertexai-search.git

# Create a virtual environment

uv venv

# Install the dependencies

uv sync --all-extras

# Check the command

uv run mcp-vertexai-searchInstalar el paquete de Python

El paquete aún no está publicado en PyPI, pero podemos instalarlo desde el repositorio. Necesitamos un archivo de configuración derivado de config.yml.template para ejecutar el servidor MCP, ya que el paquete de Python no incluye la plantilla de configuración. Consulte el Apéndice A: Archivo de configuración para obtener más información sobre el archivo de configuración.

# Install the package

pip install git+https://github.com/ubie-oss/mcp-vertexai-search.git

# Check the command

mcp-vertexai-search --helpDesarrollo

Prerrequisitos

Almacén de datos de Vertex AI

Consulte la documentación oficial sobre almacenes de datos para obtener más información.

Configurar el entorno local

# Optional: Install uv

python -m pip install -r requirements.setup.txt

# Create a virtual environment

uv venv

uv sync --all-extrasEjecutar el servidor MCP

Esto admite dos transportes para SSE (Eventos enviados por el servidor) y stdio (Entrada/Salida estándar). Podemos controlar el transporte configurando el indicador --transport .

Podemos configurar el servidor MCP con un archivo YAML. config.yml.template es una plantilla para el archivo de configuración. Por favor, modifique el archivo de configuración según sus necesidades.

uv run mcp-vertexai-search serve \

--config config.yml \

--transport <stdio|sse>Prueba la búsqueda de Vertex AI

Podemos probar la búsqueda Vertex AI usando el comando mcp-vertexai-search search sin el servidor MCP.

uv run mcp-vertexai-search search \

--config config.yml \

--query <your-query>Apéndice A: Archivo de configuración

config.yml.template es una plantilla para el archivo de configuración.

serverserver.name: El nombre del servidor MCP

modelmodel.model_name: El nombre del modelo Vertex AImodel.project_id: El ID del proyecto del modelo Vertex AImodel.location: La ubicación del modelo (por ejemplo, us-central1)model.impersonate_service_account: La cuenta de servicio que se suplantarámodel.generate_content_config: La configuración para la API de generación de contenido

data_stores: La lista de almacenes de datos de Vertex AIdata_stores.project_id: El ID del proyecto del almacén de datos de Vertex AIdata_stores.location: La ubicación del almacén de datos de Vertex AI (por ejemplo, nosotros)data_stores.datastore_id: El ID del almacén de datos de Vertex AIdata_stores.tool_name: El nombre de la herramientadata_stores.description: La descripción del almacén de datos de Vertex AI