Vertex AI Search용 MCP 서버

이는 Vertex AI를 사용하여 문서를 검색하는 MCP 서버입니다.

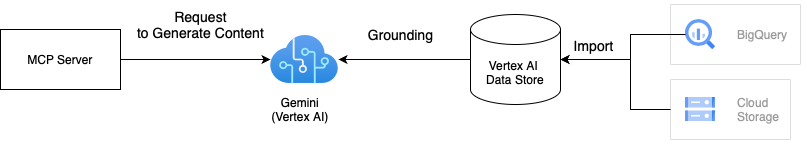

건축학

이 솔루션은 Vertex AI 기반 기능을 갖춘 Gemini를 사용하여 사용자의 개인 데이터를 기반으로 문서를 검색합니다. 기반 기능은 Vertex AI 데이터스토어에 저장된 사용자 데이터를 기반으로 Gemini의 응답을 분석하여 검색 결과의 품질을 향상시킵니다. 하나 이상의 Vertex AI 데이터스토어를 MCP 서버에 통합할 수 있습니다. 기반 기능에 대한 자세한 내용은 Vertex AI 기반 기능 설명서를 참조하세요.

Related MCP server: Vertex AI MCP Server

사용 방법

이 MCP 서버를 사용하는 방법은 두 가지가 있습니다. Docker에서 실행하려면 첫 번째 방법이 좋습니다. Dockerfile이 프로젝트에 포함되어 있기 때문입니다.

1. 저장소를 복제합니다.

지엑스피1

파이썬 패키지를 설치하세요

이 패키지는 아직 PyPI에 공개되지 않았지만, 저장소에서 설치할 수 있습니다. Python 패키지에는 구성 템플릿이 포함되어 있지 않으므로 MCP 서버를 실행하려면 config.yml.template 에서 파생된 구성 파일이 필요합니다. 구성 파일에 대한 자세한 내용은 부록 A: 구성 파일을 참조하세요.

# Install the package

pip install git+https://github.com/ubie-oss/mcp-vertexai-search.git

# Check the command

mcp-vertexai-search --help개발

필수 조건

Vertex AI 데이터 저장소

자세한 내용은 데이터 저장소에 대한 공식 문서를 참조하세요.

로컬 환경 설정

# Optional: Install uv

python -m pip install -r requirements.setup.txt

# Create a virtual environment

uv venv

uv sync --all-extrasMCP 서버 실행

이 기능은 SSE(Server-Sent Events)와 stdio(Standard Input Output) 두 가지 전송 방식을 지원합니다. --transport 플래그를 설정하여 전송 방식을 제어할 수 있습니다.

YAML 파일을 사용하여 MCP 서버를 구성할 수 있습니다. config.yml.template은 구성 파일 템플릿입니다. 필요에 맞게 구성 파일을 수정하세요.

uv run mcp-vertexai-search serve \

--config config.yml \

--transport <stdio|sse>Vertex AI 검색 테스트

MCP 서버 없이 mcp-vertexai-search search 명령을 사용하여 Vertex AI 검색을 테스트할 수 있습니다.

uv run mcp-vertexai-search search \

--config config.yml \

--query <your-query>부록 A: 구성 파일

config.yml.template은 구성 파일의 템플릿입니다.

serverserver.name: MCP 서버의 이름

modelmodel.model_name: Vertex AI 모델의 이름model.project_id: Vertex AI 모델의 프로젝트 IDmodel.location: 모델의 위치(예: us-central1)model.impersonate_service_account: 가장할 서비스 계정model.generate_content_config: 콘텐츠 생성 API에 대한 구성

data_stores: Vertex AI 데이터 저장소 목록data_stores.project_id: Vertex AI 데이터 저장소의 프로젝트 IDdata_stores.location: Vertex AI 데이터 저장소의 위치(예: 미국)data_stores.datastore_id: Vertex AI 데이터 저장소의 IDdata_stores.tool_name: 도구의 이름data_stores.description: Vertex AI 데이터 저장소에 대한 설명