Servidor Storm MCP con RAG sin servidor de Sionic AI

coreano

Servidor Storm MCP (Protocolo de contexto de modelo)

Storm MCP (Protocolo de contexto modelo) LLM LLM RAG RAG 하는 개방형 프로토콜입니다.

Plataforma Sionic AI Storm https://sionicstorm.ai API Token Quiero saber Sí.

Usar

La clave API es scripts/run.sh y se export STORM_API_KEY='' .

Por favor seleccione

Lo siento por los inconvenientes ocasionados.

Mensaje : Mensaje (enviar_chat_no_stream, lista_agentes, lista_buckets, cargar_documento_por_archivo).

파일 관리 : 파일 업로드, 읽기 및 관리를 위한 파일 시스템 작업을 구현합니다.

Servicio API : Servicio API de Storm.

Formación profesional

main.py : código MCP.

core/file_manager.py :

FileSystemManagerarchivos .core/internal_api.py : API REST de Storm.

tools/tool_definitions.py : Configuración de MCP.

tools/tool_handlers.py : Controladores.

tools/tool_upload_file.py : archivo de descarga de MCP.

Una cocina

MCP (LLM), (LLM), (LLM) Storm MCP Storm MCP versión LLM.

Cómo empezar

Escritorio Claude MCP

Abra el archivo de instalación

Datos JSON Datos MCP:

Related MCP server: Raccoon AI MCP Server

japonés

Servidor Storm MCP (Protocolo de contexto de modelo)

El servidor MCP (Protocolo de contexto de modelo) Storm es un protocolo abierto que permite una integración perfecta entre las aplicaciones LLM y las fuentes de datos y herramientas RAG. Implementa el Protocolo de Contexto de Modelo de Anthropic, lo que le permite utilizar la Plataforma Storm directamente en Claude Desktop.

Al integrarse con la plataforma Storm de Sionic AI, puede conectar y utilizar sus propios y potentes productos de bases de datos vectoriales y modelos integrados. Puede registrarse por agente en https://sionicstorm.ai para obtener un token API y crear su solución RAG de inmediato.

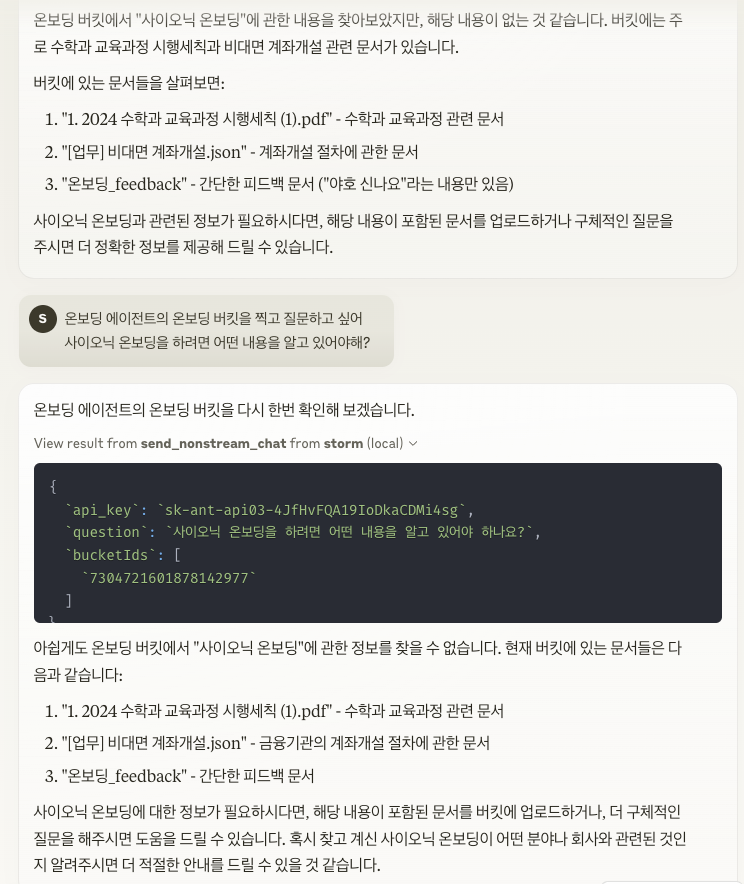

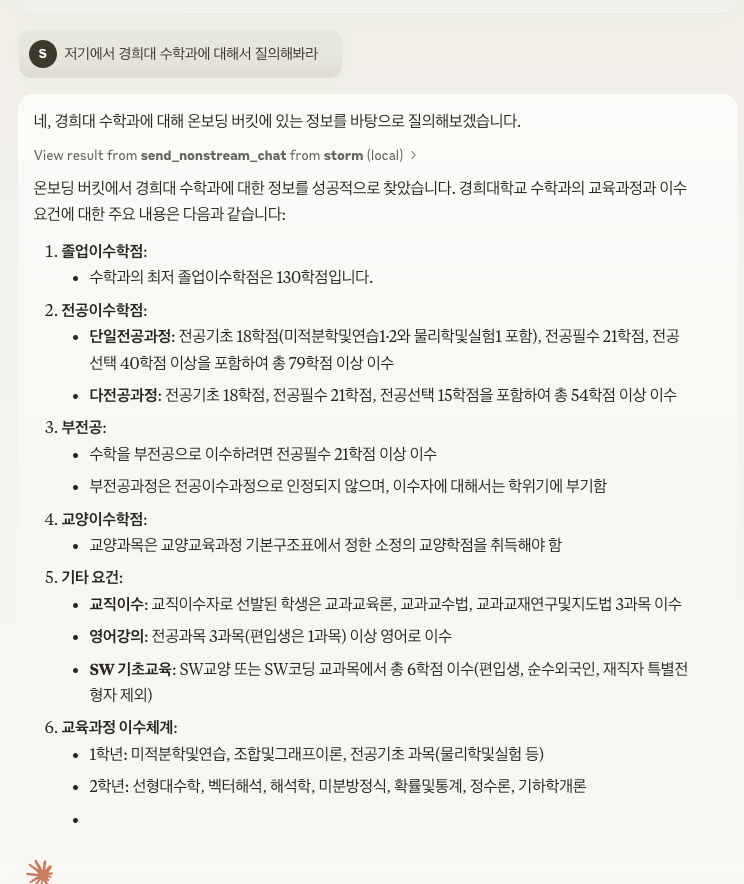

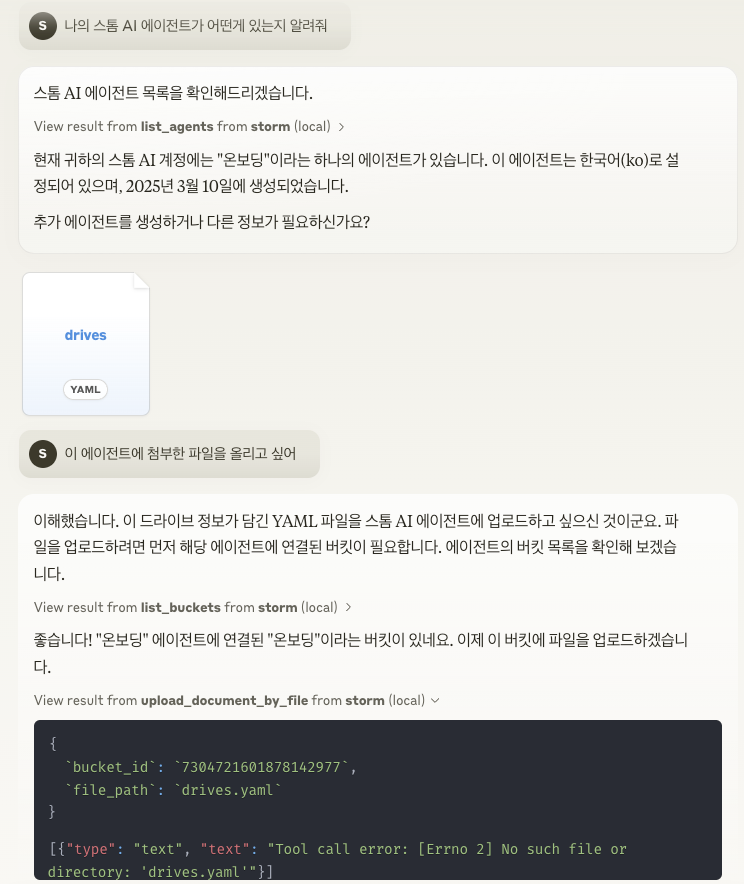

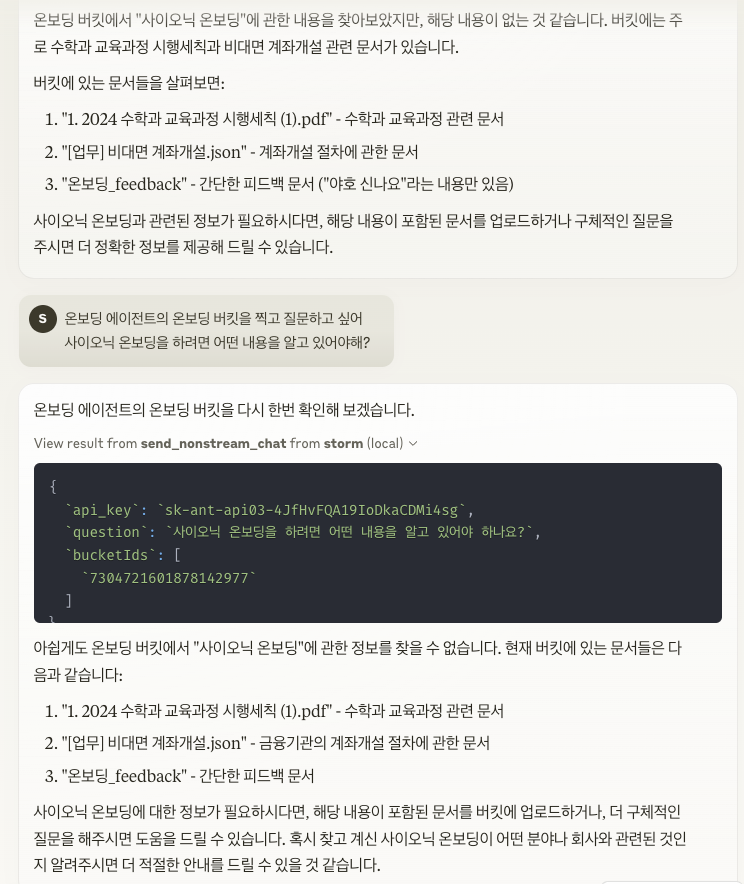

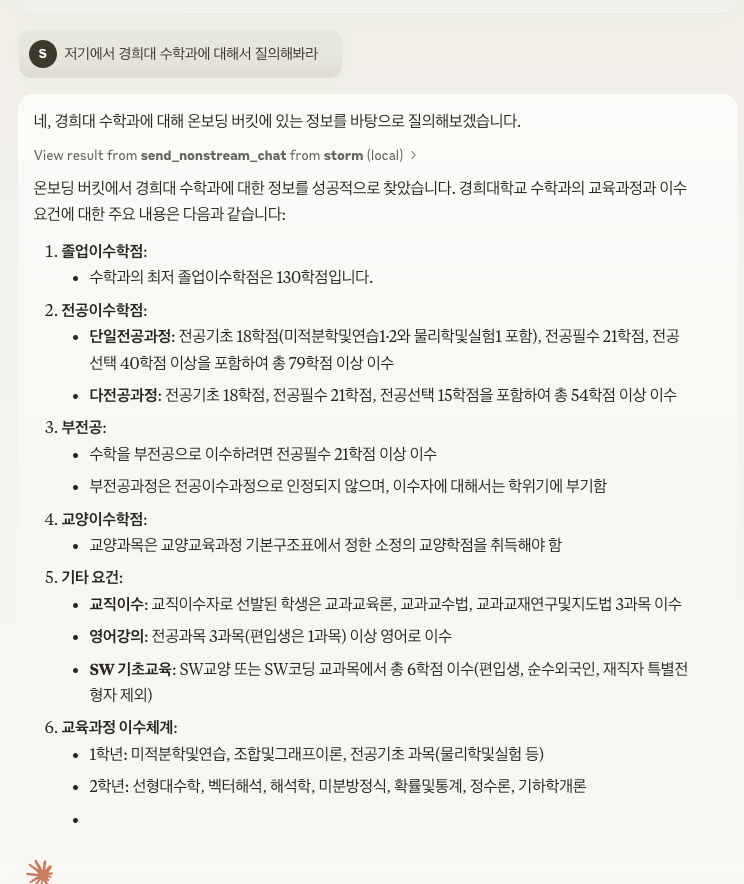

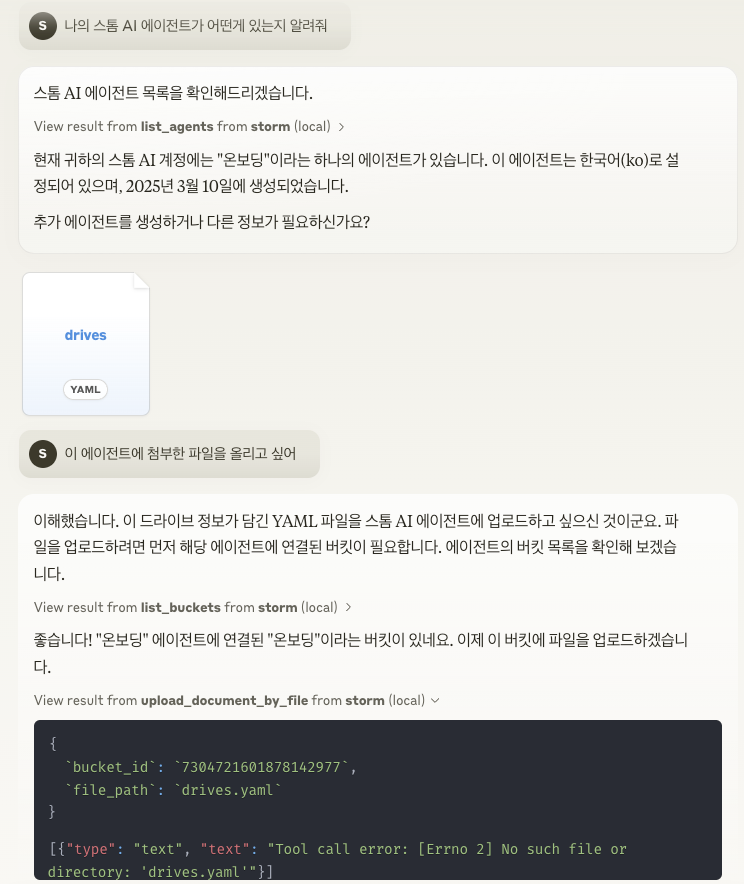

Ejemplo de uso

Ingrese la clave API en export STORM_API_KEY='' en scripts/run.sh .

Características principales

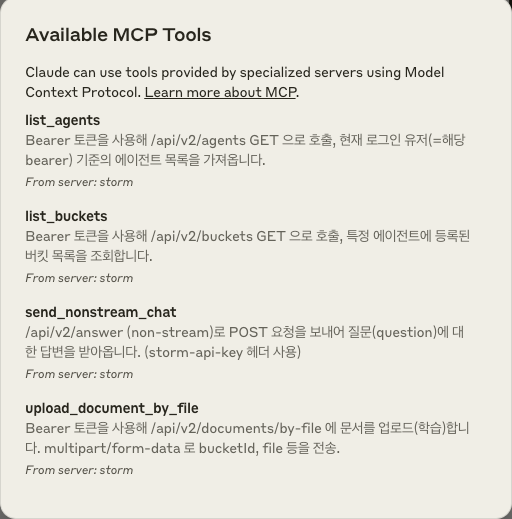

Compartir contexto : proporciona un protocolo estándar para la interacción entre LLM y las fuentes de datos.

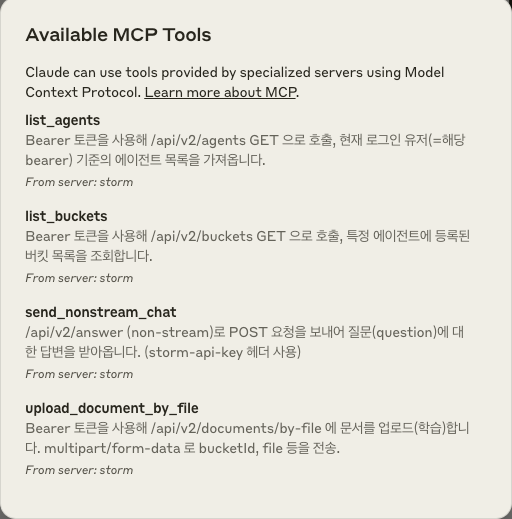

Sistema de herramientas : proporciona una forma estandarizada de definir e invocar herramientas (send_nonstream_chat, list_agents, list_buckets, upload_document_by_file, etc.).

Gestión de archivos : implementa operaciones del sistema de archivos para cargar, leer y administrar archivos.

Integración de API : conéctese a los puntos finales de API de Storm para proporcionar una variedad de funciones.

Estructura del proyecto

main.py : inicializa el servidor MCP y configura los controladores de eventos.

core/file_manager.py : Implementa la clase

FileSystemManagerpara operaciones de archivos.core/internal_api.py : contiene funciones de cliente API para interactuar con los puntos finales de API REST de Storm.

tools/tool_definitions.py : define las herramientas disponibles en el servidor MCP.

tools/tool_handlers.py : Implementa controladores para operaciones de herramientas.

tools/tool_upload_file.py : Implementa un servidor de archivos separado para operaciones de archivos con su propio controlador MCP.

arquitectura

MCP está diseñado con una estructura de tres capas entre el host (aplicación LLM), el cliente (implementación del protocolo) y el servidor (proveedor de funciones). El servidor Storm MCP implementa la parte de servidor de esto y proporciona recursos y herramientas al LLM.

Cómo empezar

Para conectar un servidor MCP en un entorno de Claude Desktop , se deben aplicar las siguientes configuraciones:

Abrir un archivo de configuración

Agregue la configuración del servidor MCP en JSON: