Storm MCP Server with Sionic AI serverless RAG

Korean (한국어)

Storm MCP (Model Context Protocol) Server

Storm MCP (Model Context Protocol) 서버는 LLM 응용 프로그램과 RAG 데이터 소스 및 도구 간의 원활한 통합을 가능하게하는 개방형 프로토콜입니다. Anthropic의 Model Context Protocol 을 구현하여 Claude Desktop에서 Storm Platform을 바로 활용하십시오.

Sionic AI의 Storm Platform 을 통합하여 사용하면 자신 만의 강력한 임베딩 모델과 벡터 DB 제품군을 연결하여 사용할 수 있습니다. https://sionicstorm.ai 에서 에이전트 단위로 가입하여 API Token을 얻어서 RAG 솔루션을 바로 만드실 수 있습니다.

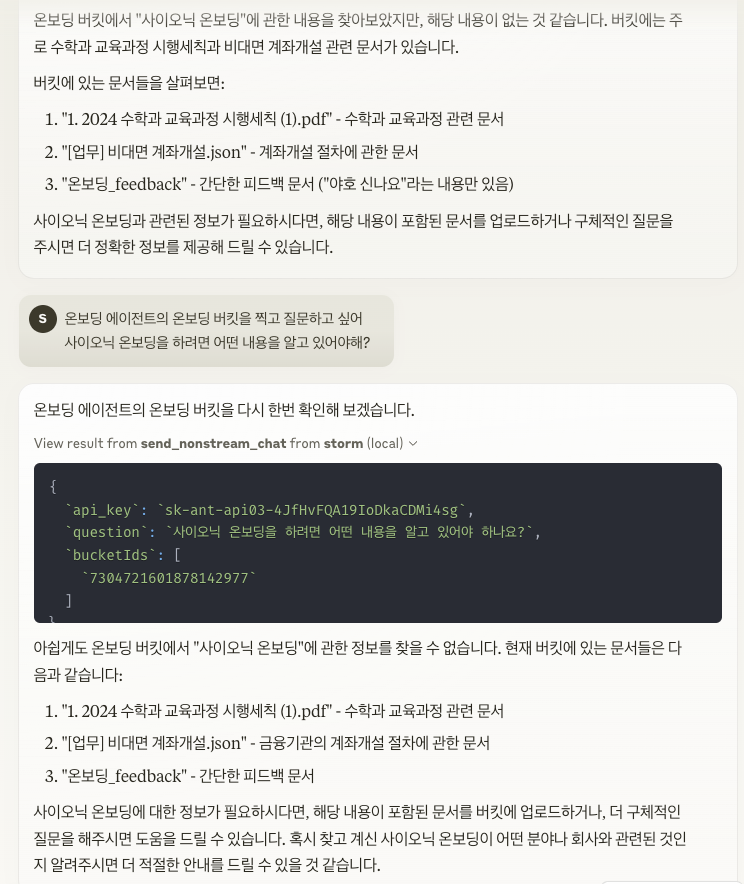

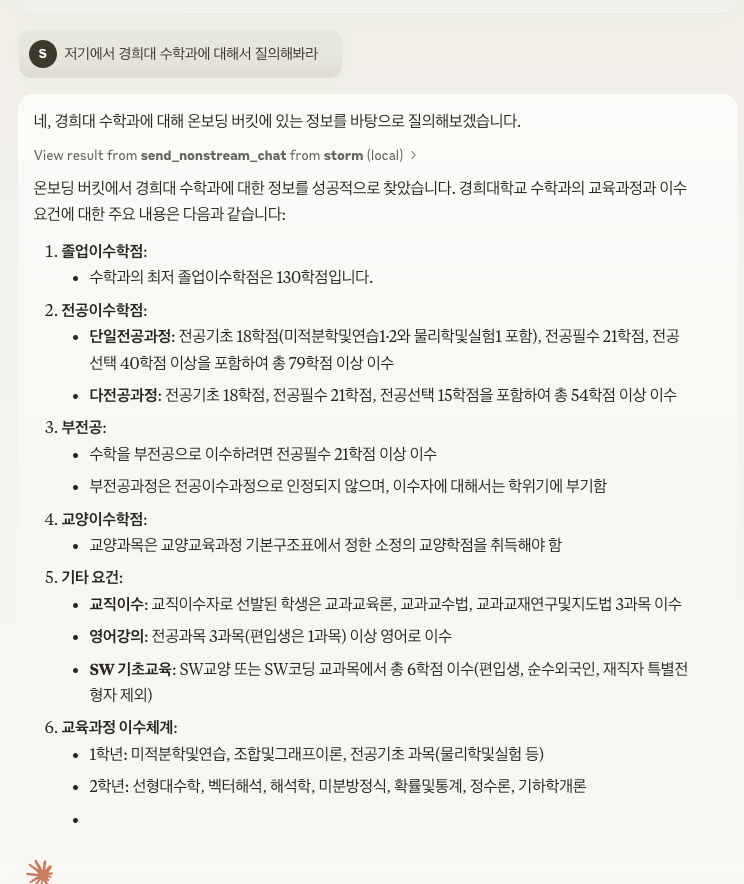

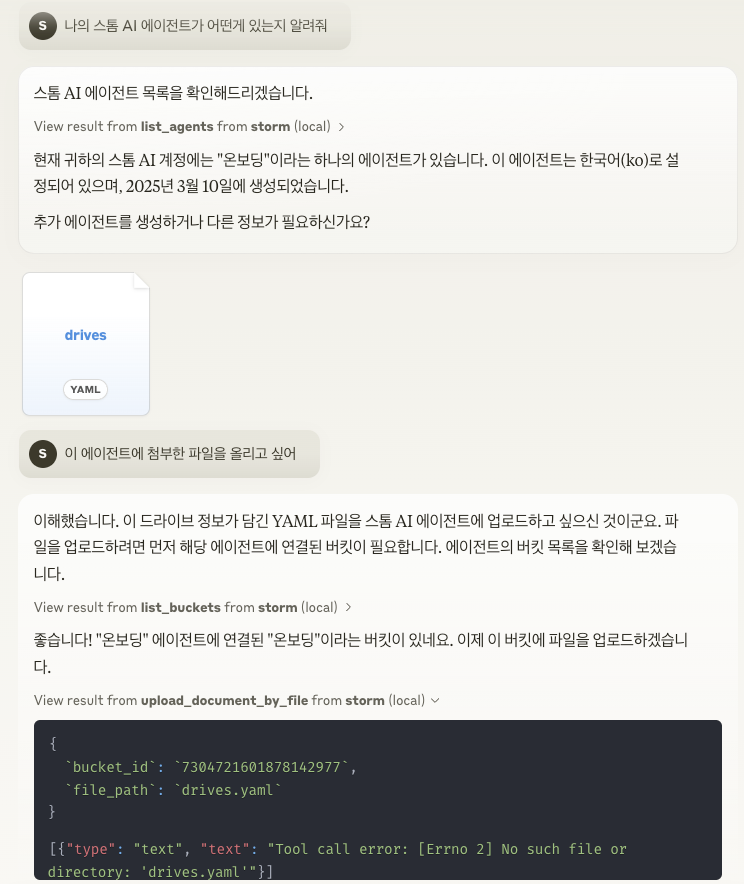

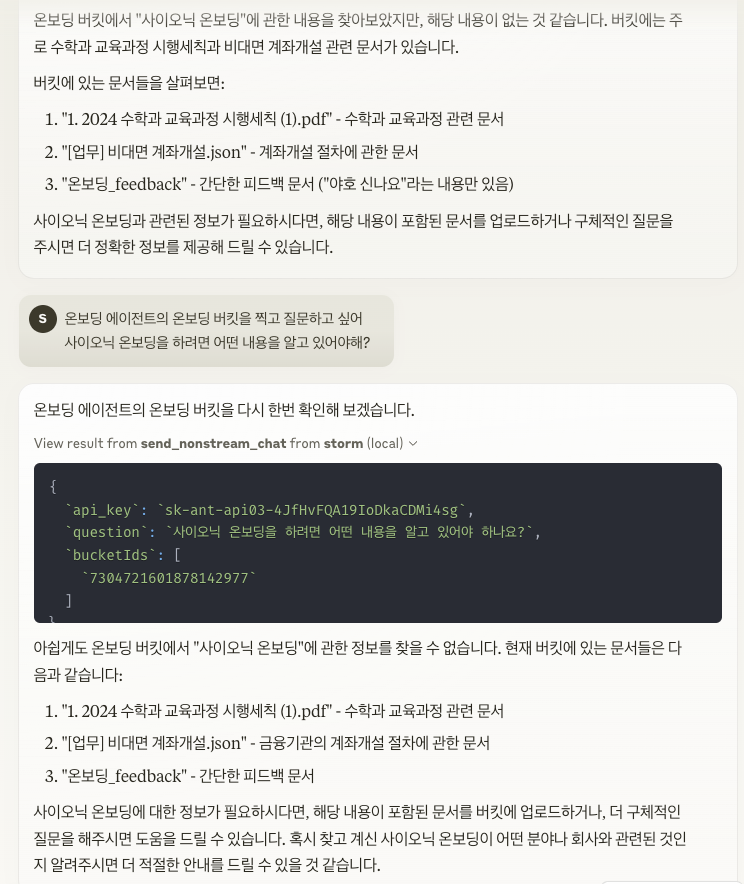

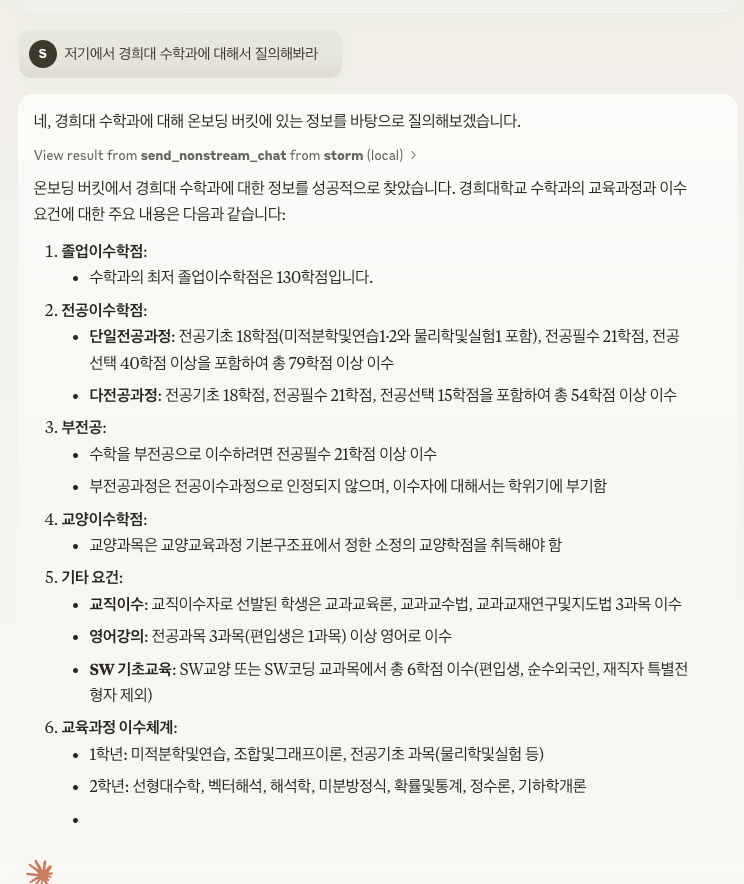

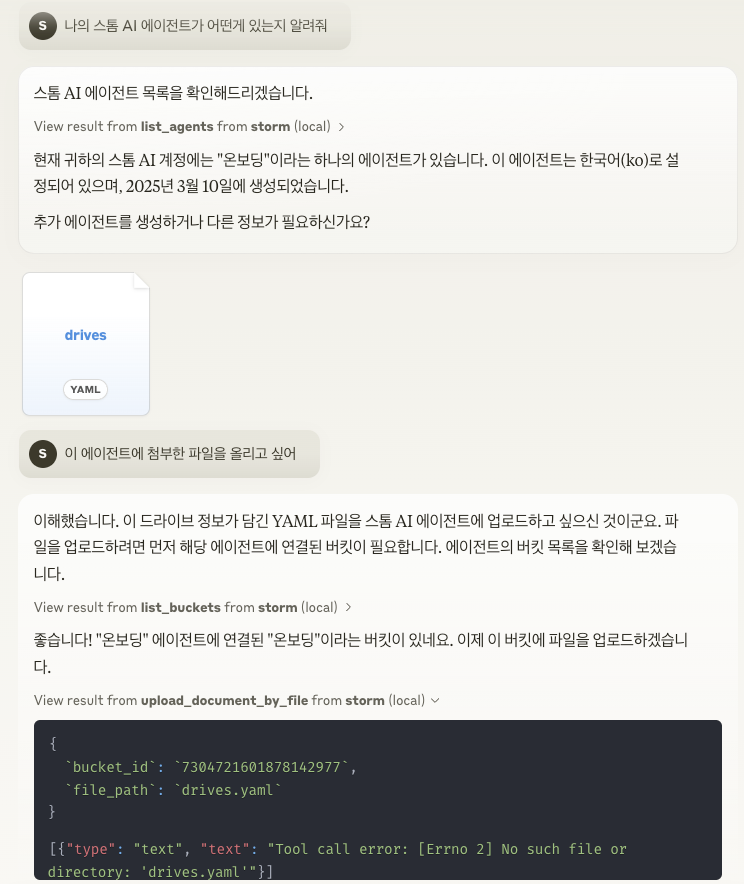

사용 예

API Key는 scripts/run.sh 에있는 export STORM_API_KEY='' 에 입력하십시오.

주요 기능

컨텍스트 공유 : LLM과 데이터 소스 간의 상호 작용을위한 표준 프로토콜을 제공합니다.

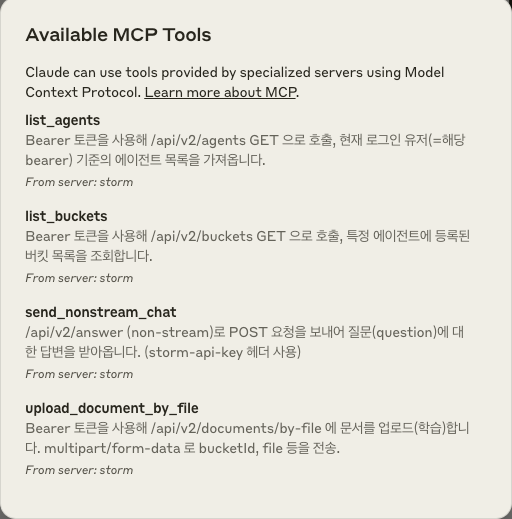

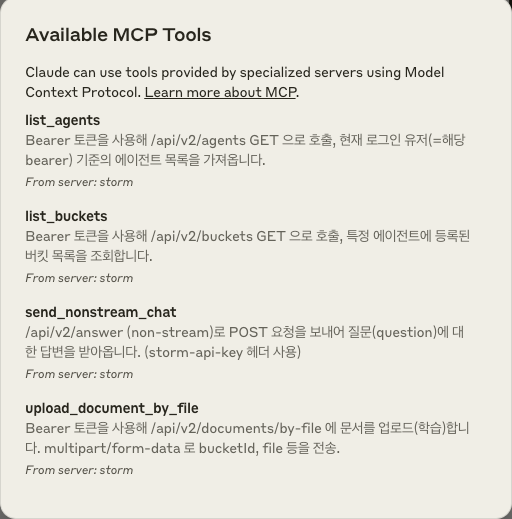

도구 시스템 : 도구를 정의하고 호출하는 표준화 된 방법을 제공합니다 (send_nonstream_chat, list_agents, list_buckets, upload_document_by_file 등).

파일 관리 : 파일 업로드, 읽기 및 관리를위한 파일 시스템 작업을 구현합니다.

API 통합 : Storm의 API 엔드 포인트와 연결하여 다양한 기능을 제공합니다.

프로젝트 구조

main.py : MCP 서버를 초기화하고 이벤트 핸들러를 설정합니다.

core / file_manager.py : 파일 작업을위한

FileSystemManager클래스를 구현합니다.core / internal_api.py : Storm의 REST API 엔드 포인트와 상호 작용하기위한 API 클라이언트 함수를 포함합니다.

tools / tool_definitions.py : MCP 서버에서 사용 가능한 도구를 정의합니다.

tools / tool_handlers.py : 도구 작업을위한 핸들러를 구현합니다.

tools / tool_upload_file.py : 자체 MCP 핸들러가있는 파일 작업을위한 별도의 파일 서버를 구현합니다.

아키텍처

MCP는 호스트 (LLM 응용 프로그램), 클라이언트 (프로토콜 구현) 및 서버 (기능 공급자) 간의 3 계층 구조로 설계되었습니다. Storm MCP 서버는 서버 부분을 구현하여 리소스와 도구를 LLM에 제공합니다.

시작하기

Claude Desktop 환경에서 MCP 서버를 연결하려면 다음 설정을 적용해야합니다.

설정 파일 열기

JSON 내부에 MCP 서버 설정 추가:

Related MCP server: Raccoon AI MCP Server

Japanese (일본어)

Storm MCP (Model Context Protocol) Server

Storm MCP (Model Context Protocol) 서버는 LLM 응용 프로그램과 RAG 데이터 소스 및 도구 간의 원활한 통합을 가능하게하는 개방형 프로토콜입니다. Anthropic의 Model Context Protocol 을 구현하고 Claude Desktop에서 Storm Platform을 직접 사용할 수 있습니다.

Sionic AI의 Storm Platform을 통합하여 사용하면 자신만의 강력한 임베디드 모델과 벡터 DB 제품군을 연결하여 사용할 수 있습니다. https://sionicstorm.ai 에서 에이전트별로 등록하여 API 토큰을 얻고 즉시 RAG 솔루션을 만들 수 있습니다.

사용 예

API 키는 scripts/run.sh 의 export STORM_API_KEY='' 에 입력하십시오.

주요 기능

컨텍스트 공유 : LLM과 데이터 소스 간의 상호 작용을위한 표준 프로토콜을 제공합니다.

도구 시스템 : 도구를 정의하고 호출하는 표준화된 방법을 제공합니다(send_nonstream_chat, list_agents, list_buckets, upload_document_by_file 등).

파일 관리 : 파일 업로드, 로드 및 관리를 위한 파일 시스템 작업을 구현합니다.

API 통합 : Storm의 API 엔드포인트와 연결하여 다양한 기능을 제공합니다.

프로젝트 구조

main.py : MCP 서버를 초기화하고 이벤트 핸들러를 설정합니다.

core/file_manager.py : 파일 조작을 위한

FileSystemManager클래스를 구현합니다.core/internal_api.py : Storm의 RESTAPI 엔드포인트와 상호작용하기 위한 API 클라이언트 함수를 포함합니다.

tools/tool_definitions.py : MCP 서버에서 사용할 수 있는 도구를 정의합니다.

tools/tool_handlers.py : 도구 조작을 위한 핸들러를 구현합니다.

tools/tool_upload_file.py : 고유한 MCP 핸들러로 파일 조작을 위한 별도의 파일 서버를 구현합니다.

아키텍처

MCP는 호스트(LLM 애플리케이션), 클라이언트(프로토콜 구현), 서버(기능 제공자) 간의 3계층 구조로 설계되었습니다. Storm MCP 서버는 이 중 서버 부분을 구현하고 리소스와 도구를 LLM에 제공합니다.

시작하는 방법

Claude Desktop 환경에서 MCP 서버를 연결하려면 다음 설정을 적용해야 합니다.

설정 파일 열기

JSON 내에 MCP 서버 설정 추가: