Interaktives Feedback MCP

Entwickelt von Fábio Ferreira ( @fabiomlferreira ). Weitere Verbesserungen bei der KI-Entwicklung finden Sie auf dotcursorrules.com .

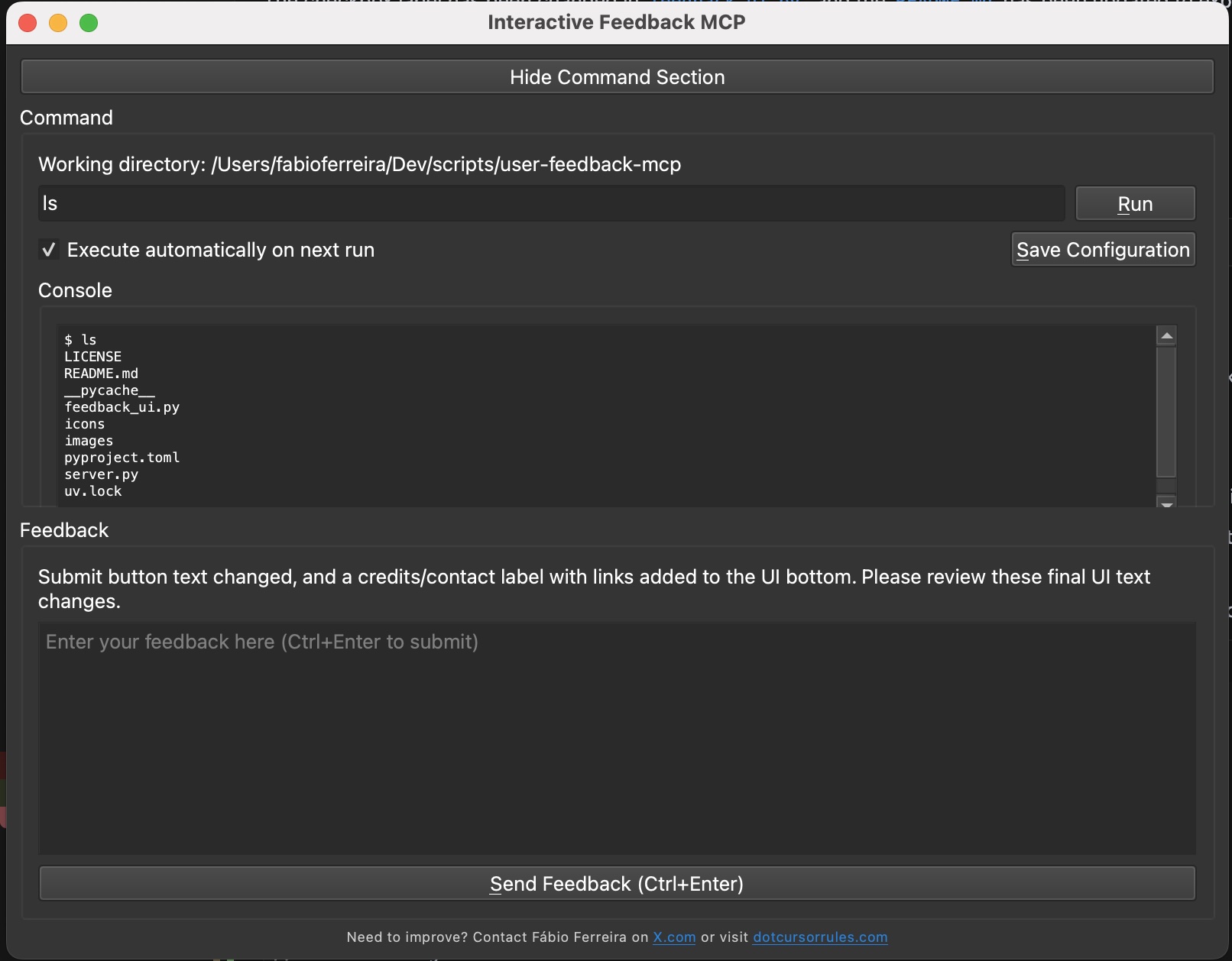

Einfacher MCP-Server für einen Human-in-the-Loop-Workflow in KI-gestützten Entwicklungstools wie Cursor . Mit diesem Server können Sie Befehle ausführen, deren Ausgabe anzeigen und Textfeedback direkt an die KI senden. Er ist außerdem mit Cline und Windsurf kompatibel.

Prompt Engineering

Um die besten Ergebnisse zu erzielen, fügen Sie Ihrer benutzerdefinierten Eingabeaufforderung in Ihrem KI-Assistenten Folgendes hinzu. Sie sollten es einer Regel oder direkt in der Eingabeaufforderung (z. B. Cursor) hinzufügen:

Wenn Sie eine Frage stellen möchten, rufen Sie immer das MCP

interactive_feedbackauf.

Wenn Sie eine Benutzeranfrage abschließen möchten, rufen Sie den MCPinteractive_feedbackauf, anstatt den Prozess einfach zu beenden. Wenn das Feedback leer ist, können Sie die Anfrage beenden und den MCP nicht in einer Schleife aufrufen.

Dadurch wird sichergestellt, dass Ihr KI-Assistent diesen MCP-Server verwendet, um Benutzerfeedback anzufordern, bevor er die Aufgabe als erledigt markiert.

Related MCP server: Interactive Feedback MCP

💡 Warum dies verwenden?

Indem der Assistent beim Benutzer nachfragt, anstatt spekulative, kostenintensive Tool-Aufrufe durchzuführen, kann dieses Modul die Anzahl von Premium-Anfragen (z. B. OpenAI-Tool-Aufrufe) auf Plattformen wie Cursor drastisch reduzieren. In manchen Fällen hilft es, bis zu 25 Tool-Aufrufe in einer einzigen, Feedback-basierten Anfrage zu konsolidieren – das spart Ressourcen und verbessert die Leistung.

Konfiguration

Dieser MCP-Server verwendet Qts QSettings , um Konfigurationen projektbezogen zu speichern. Dies umfasst:

Der auszuführende Befehl.

Ob der Befehl beim nächsten Start für dieses Projekt automatisch ausgeführt werden soll (siehe Kontrollkästchen „Beim nächsten Start automatisch ausführen“).

Der Sichtbarkeitsstatus (angezeigt/ausgeblendet) des Befehlsbereichs (dieser wird beim Umschalten sofort gespeichert).

Fenstergeometrie und -status (allgemeine UI-Einstellungen).

Diese Einstellungen werden normalerweise an plattformspezifischen Speicherorten (z. B. Registrierung unter Windows, plist-Dateien unter macOS, Konfigurationsdateien in ~/.config oder ~/.local/share unter Linux) unter dem Organisationsnamen „FabioFerreira“ und dem Anwendungsnamen „InteractiveFeedbackMCP“ gespeichert, mit einer eindeutigen Gruppe für jedes Projektverzeichnis.

Die Schaltfläche „Konfiguration speichern“ in der Benutzeroberfläche speichert in erster Linie den aktuell im Befehlseingabefeld eingegebenen Befehl und den Status des Kontrollkästchens „Beim nächsten Start automatisch ausführen“ für das aktive Projekt. Die Sichtbarkeit des Befehlsbereichs wird automatisch gespeichert, wenn Sie ihn umschalten. Die allgemeine Fenstergröße und -position werden beim Schließen der Anwendung gespeichert.

Installation (Cursor)

Voraussetzungen:

Python 3.11 oder neuer.

uv (Python-Paketmanager). Installieren Sie es mit:

Windows:

pip install uvLinux/Mac:

curl -LsSf https://astral.sh/uv/install.sh | sh

Holen Sie sich den Code:

Klonen Sie dieses Repository:

git clone https://github.com/noopstudios/interactive-feedback-mcp.gitOder laden Sie den Quellcode herunter.

Navigieren Sie zum Verzeichnis:

cd path/to/interactive-feedback-mcp

Installieren Sie Abhängigkeiten:

uv sync(dies erstellt eine virtuelle Umgebung und installiert Pakete)

Führen Sie den MCP-Server aus:

uv run server.py

Im Cursor konfigurieren:

Cursor ermöglicht in der Regel die Angabe benutzerdefinierter MCP-Server in seinen Einstellungen. Sie müssen Cursor auf diesen laufenden Server verweisen. Der genaue Mechanismus kann variieren. Informationen zum Hinzufügen benutzerdefinierter MCPs finden Sie in der Cursor-Dokumentation.

Manuelle Konfiguration (z. B. über Denken Sie daran, den Pfad

{ "mcpServers": { "interactive-feedback-mcp": { "command": "uv", "args": [ "--directory", "/Users/fabioferreira/Dev/scripts/interactive-feedback-mcp", "run", "server.py" ], "timeout": 600, "autoApprove": [ "interactive_feedback" ] } } }Sie können bei der Konfiguration in Cursor eine Serverkennung wie

interactive-feedback-mcpverwenden.

Für Cline / Windsurf

Es gelten ähnliche Einrichtungsprinzipien. Sie konfigurieren den Serverbefehl (z. B. uv run server.py mit dem korrekten Argument --directory , das auf das Projektverzeichnis verweist) in den MCP-Einstellungen des jeweiligen Tools und verwenden dabei interactive-feedback-mcp als Serverkennung.

Entwicklung

So führen Sie den Server zum Testen im Entwicklungsmodus mit einer Weboberfläche aus:

Dadurch wird eine Weboberfläche geöffnet und Sie können zum Testen mit den MCP-Tools interagieren.

Verfügbare Werkzeuge

Hier ist ein Beispiel, wie der KI-Assistent das Tool interactive_feedback aufrufen würde:

Danksagungen & Kontakt

Wenn Sie dieses interaktive Feedback-MCP nützlich finden, können Sie Ihre Wertschätzung am besten zeigen, indem Sie Fábio Ferreira auf X @fabiomlferreira folgen.

Wenn Sie Fragen oder Vorschläge haben oder uns einfach mitteilen möchten, wie Sie es verwenden, können Sie sich jederzeit unter X melden!

Weitere Ressourcen zur Verbesserung Ihres KI-gestützten Entwicklungsworkflows finden Sie auch auf dotcursorrules.com .