🚀 Demostración interactiva disponible aquí: https://centralmind.ai

¿Qué es Centralmind/Gateway?

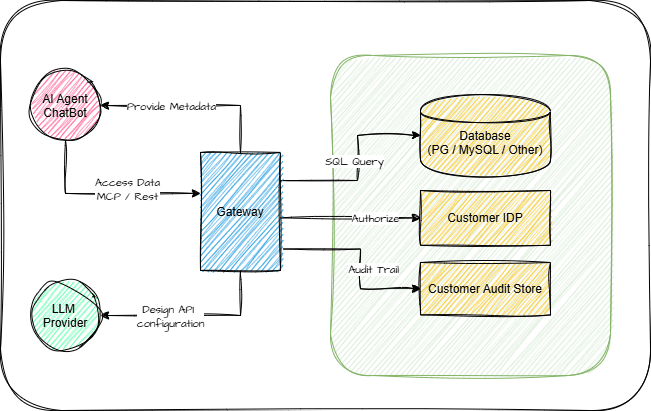

Una forma sencilla de exponer su base de datos a AI-Agent a través de los protocolos MCP o OpenAPI 3.1.

Esto ejecutará una API para usted:

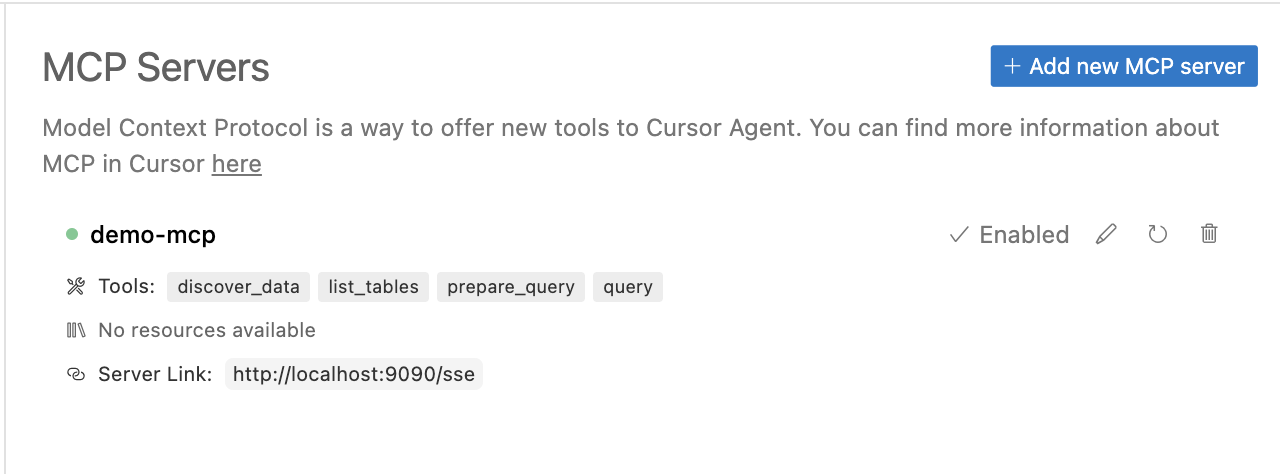

Que puedes utilizar dentro de tu agente de IA:

Gateway generará una API optimizada para IA.

Related MCP server: Database Tools for Claude AI

¿Por qué Centralmind/Gateway?

Los agentes de IA y las aplicaciones basadas en LLM necesitan un acceso rápido y seguro a los datos. Estamos desarrollando una capa de API que genera automáticamente API seguras y optimizadas para LLM para sus datos estructurados.

Comience rápidamente con MCP o OpenAPI, o utilice las API de SQL directo/sin procesar

Filtra información personal identificable (PII) y datos confidenciales para garantizar el cumplimiento de GDPR, CPRA, SOC 2 y otras regulaciones.

Agrega capacidades de trazabilidad y auditoría, lo que garantiza que las aplicaciones de IA no sean cajas negras y permite que los equipos de seguridad mantengan el control.

Optimizado para cargas de trabajo de IA: admite el Protocolo de contexto de modelo (MCP) con metadatos mejorados para ayudar a los agentes de IA a comprender las API, junto con funciones de seguridad y almacenamiento en caché integradas.

Puede ser útil durante el desarrollo, cuando un LLM necesita crear, ajustar o consultar datos de su base de datos. En escenarios analíticos, le permite interactuar con su base de datos o almacén de datos. Enriquezca a sus agentes de IA con datos de su base de datos mediante llamadas remotas a funciones/herramientas.

Características

⚡ Generación automática de API : crea API automáticamente utilizando LLM según el esquema de tabla y los datos muestreados

🗄️ Compatibilidad con bases de datos estructuradas : compatible con PostgreSQL, MySQL, ClickHouse, Snowflake, MSSQL, BigQuery, Oracle Database, SQLite, ElasticSearch

🌍 Compatibilidad con múltiples protocolos : proporciona API como servidor REST o MCP, incluido el modo SSE

📜 Documentación API : documentación Swagger generada automáticamente y especificación OpenAPI 3.1.0

Protección de PII : implementa el complemento de expresiones regulares o el complemento de Microsoft Presidio para la redacción de PII y datos confidenciales

⚡ Configuración flexible : fácilmente extensible a través de la configuración YAML y el sistema de complementos

🐳 Opciones de implementación : Ejecútelo como un contenedor binario o Docker con un gráfico Helm listo para usar

🤖 Compatibilidad con varios proveedores de IA : compatibilidad con OpenAI , Anthropic , Amazon Bedrock , Google Gemini y Google VertexAI

📦 Local y en las instalaciones : compatibilidad con LLM autoalojados mediante puntos finales y modelos de IA configurables

Seguridad a nivel de fila (RLS): control de acceso a datos de grano fino mediante scripts Lua

🔐 Opciones de autenticación : soporte integrado para claves API y OAuth

👀 Monitoreo integral : integración con OpenTelemetry (OTel) para seguimiento de solicitudes y registros de auditoría

🏎️ Optimización del rendimiento : implementa estrategias de almacenamiento en caché LRU y basadas en tiempo

Cómo funciona

1. Conéctate y descubre

Gateway se conecta a sus bases de datos estructuradas, como PostgreSQL, y analiza automáticamente el esquema y las muestras de datos para generar una estructura de API optimizada según sus indicaciones. LLM se utiliza únicamente en la etapa de descubrimiento para generar la configuración de la API. La herramienta utiliza proveedores de IA para generar la configuración de la API, garantizando al mismo tiempo la seguridad mediante la detección de información de identificación personal (PII).

2. Implementar

Gateway admite múltiples opciones de implementación: desde binarios independientes, Docker o Kubernetes. Consulta nuestra guía de lanzamiento para obtener instrucciones detalladas. El sistema utiliza configuración YAML y complementos para una fácil personalización.

3. Usar e integrar

Acceda a sus datos mediante API REST o el Protocolo de Contexto de Modelo (MCP) con funciones de seguridad integradas. Gateway se integra a la perfección con modelos de IA y aplicaciones como LangChain, OpenAI y Claude Desktop mediante llamadas a funciones o Cursor a través de MCP. También puede configurar la telemetría a destinos locales o remotos en formato hotel.

Documentación

Empezando

Guía de inicio rápido

Instrucciones de instalación

Guía de generación de API

Guía de lanzamiento de API

Recursos adicionales

Guía de integración de ChatGPT

Documentación del conector de base de datos

Documentación del complemento

Cómo construir

Generación de API

Gateway utiliza modelos LLM para generar la configuración de su API. Siga estos pasos:

Elija uno de nuestros proveedores de inteligencia artificial compatibles:

OpenAI y todos los proveedores compatibles con OpenAI

Google Gemini ofrece un generoso nivel gratuito . Puedes obtener una clave API visitando Google AI Studio:

Una vez iniciada la sesión, puede crear una clave API en la sección API de AI Studio. El plan gratuito incluye una generosa asignación mensual de tokens, lo que lo hace accesible para fines de desarrollo y pruebas.

Configurar la autorización del proveedor de IA. Para Google Gemini, configure una clave API.

Ejecute el comando de descubrimiento:

Disfruta del proceso de generación:

Revise la configuración generada en

gateway.yaml:

Ejecución de la API

Ejecutar localmente

Docker Compose

Integración del protocolo MCP

Gateway implementa el protocolo MCP para una integración fluida con Claude y otras herramientas. Para obtener instrucciones detalladas de configuración, consulte nuestra guía de integración con Claude.

Para agregar la herramienta MCP a Claude Desktop simplemente ajuste la configuración de Claude:

Hoja de ruta

Está sujeto a cambios constantes y la hoja de ruta dependerá en gran medida de los comentarios de los usuarios. Actualmente, estamos planificando las siguientes funciones:

Base de datos y conectividad

🗄️ Integraciones de bases de datos extendidas : Redshift, S3 (Iceberg y Parquet), Oracle DB, Microsoft SQL Server, Elasticsearch

🔑 Túnel SSH : capacidad de usar jumphost o ssh bastion para tunelizar conexiones

Funcionalidad mejorada

🔍 Capacidades de consulta avanzadas : sintaxis de filtrado compleja y funciones de agregación como parámetros

🔐 Seguridad MCP mejorada : clave API y autenticación OAuth

Mejoras de la plataforma

📦 Gestión de esquemas : evolución automatizada de esquemas y control de versiones de API

🚦 Gestión avanzada del tráfico : limitación inteligente de velocidad, limitación de solicitudes

✍️ Soporte de operaciones de escritura : operaciones de inserción y actualización

Appeared in Searches

- Connecting Cursor to Oracle Database for Data Learning

- MCP server for PostgreSQL and MySQL database indexing and DDL queries

- System capable of integrating with ERP and other information system databases

- Google BigQuery cloud data warehouse service

- Connecting to Oracle DB and summarizing table details with schema, relationships, and associated components