🚀 Interaktive Demo hier verfügbar: https://centralmind.ai

Was ist Centralmind/Gateway

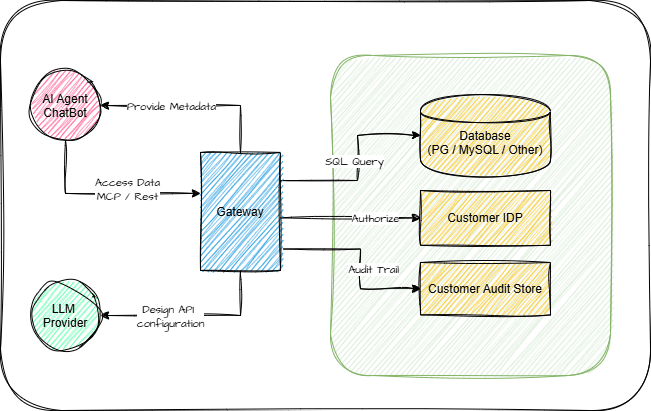

Einfache Möglichkeit, Ihre Datenbank über die Protokolle MCP oder OpenAPI 3.1 dem AI-Agent zugänglich zu machen.

Dadurch wird für Sie eine API ausgeführt:

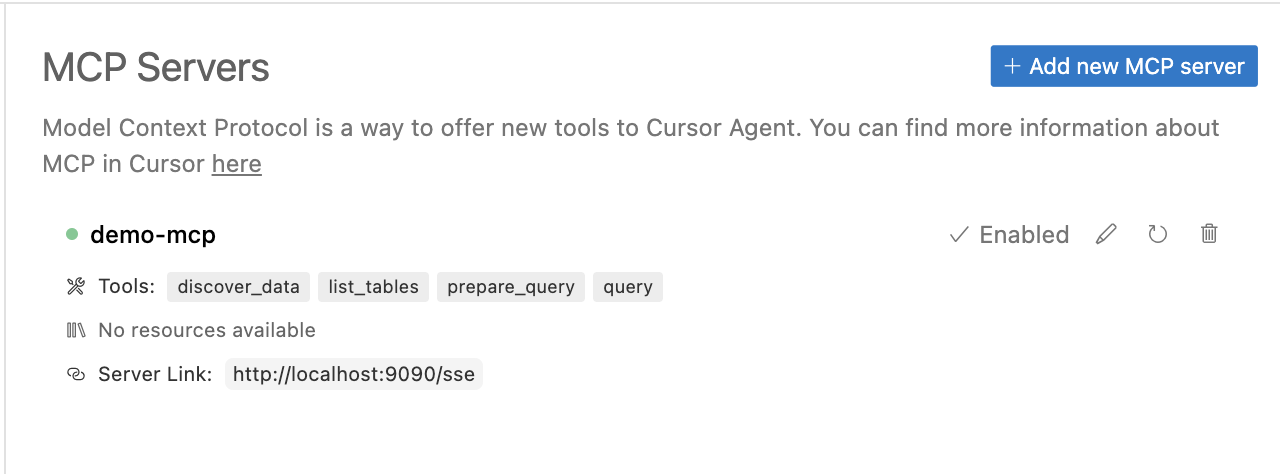

Was Sie in Ihrem KI-Agenten verwenden können:

Gateway generiert eine KI-optimierte API.

Related MCP server: Database Tools for Claude AI

Warum Centralmind/Gateway

KI-Agenten und LLM-basierte Anwendungen benötigen schnellen und sicheren Datenzugriff. Wir entwickeln eine API-Schicht, die automatisch sichere, LLM-optimierte APIs für Ihre strukturierten Daten generiert.

Starten Sie schnell mit MCP oder OpenAPI oder verwenden Sie Direct/Raw SQL APIs

Filtert PII und sensible Daten heraus, um die Einhaltung von GDPR, CPRA, SOC 2 und anderen Vorschriften sicherzustellen

Fügt Rückverfolgbarkeits- und Auditfunktionen hinzu, um sicherzustellen, dass KI-Anwendungen keine Blackboxes sind und Sicherheitsteams die Kontrolle behalten

Optimiert für KI-Workloads: unterstützt das Model Context Protocol (MCP) mit erweiterten Metadaten, um KI-Agenten das Verständnis von APIs zu erleichtern, sowie integrierte Caching- und Sicherheitsfunktionen

Dies kann während der Entwicklung nützlich sein, wenn ein LLM Daten aus Ihrer Datenbank erstellen, anpassen oder abfragen muss. In analytischen Szenarien ermöglicht es Ihnen, mit Ihrer Datenbank oder Ihrem Data Warehouse zu chatten. Bereichern Sie Ihre KI-Agenten mit Daten aus Ihrer Datenbank durch Remote Function/Tool Calling.

Merkmale

⚡ Automatische API-Generierung – Erstellt APIs automatisch mithilfe von LLM basierend auf Tabellenschema und Stichprobendaten

🗄️ Strukturierte Datenbankunterstützung – Unterstützt PostgreSQL, MySQL, ClickHouse, Snowflake, MSSQL, BigQuery, Oracle Database, SQLite, ElasticSearch

🌍 Unterstützung mehrerer Protokolle – Bietet APIs als REST- oder MCP-Server einschließlich SSE-Modus

📜 API-Dokumentation – Automatisch generierte Swagger-Dokumentation und OpenAPI 3.1.0-Spezifikation

🔒 PII-Schutz – Implementiert ein Regex-Plugin oder ein Microsoft Presidio-Plugin für die Schwärzung von PII und sensiblen Daten

⚡ Flexible Konfiguration – Einfach erweiterbar über YAML-Konfiguration und Plugin-System

🐳 Bereitstellungsoptionen – Ausführung als Binär- oder Docker-Container mit einsatzbereitem Helm-Diagramm

🤖 Unterstützung mehrerer KI-Anbieter – Unterstützung für OpenAI , Anthropic , Amazon Bedrock , Google Gemini und Google VertexAI

📦 Lokal und vor Ort – Unterstützung für selbstgehostete LLMs durch konfigurierbare KI-Endpunkte und -Modelle

🔑 Row-Level Security (RLS) – Feinkörnige Datenzugriffskontrolle mithilfe von Lua-Skripten

🔐 Authentifizierungsoptionen – Integrierte Unterstützung für API-Schlüssel und OAuth

👀 Umfassende Überwachung – Integration mit OpenTelemetry (OTel) für Anforderungsverfolgung und Prüfpfade

🏎️ Leistungsoptimierung – Implementiert zeitbasierte und LRU-Caching-Strategien

So funktioniert es

1. Verbinden und Entdecken

Gateway verbindet sich mit Ihren strukturierten Datenbanken wie PostgreSQL und analysiert automatisch das Schema und die Datenbeispiele, um basierend auf Ihren Vorgaben eine optimierte API-Struktur zu generieren. LLM wird ausschließlich in der Discovery-Phase zur Erstellung der API-Konfiguration verwendet. Das Tool nutzt KI-Anbieter zur Generierung der API-Konfiguration und gewährleistet gleichzeitig die Sicherheit durch PII-Erkennung.

2. Bereitstellen

Gateway unterstützt verschiedene Bereitstellungsoptionen: Standalone-Binärdateien, Docker oder Kubernetes. Detaillierte Anweisungen finden Sie in unserer Einführungsanleitung. Das System nutzt YAML-Konfiguration und Plugins für eine einfache Anpassung.

3. Nutzen & Integrieren

Greifen Sie über REST-APIs oder das Model Context Protocol (MCP) mit integrierten Sicherheitsfunktionen auf Ihre Daten zu. Gateway lässt sich nahtlos in KI-Modelle und Anwendungen wie LangChain, OpenAI und Claude Desktop integrieren, indem es Funktionsaufrufe oder Cursor über MCP nutzt. Sie können auch Telemetriedaten zu lokalen oder entfernten Zielen im Hotelformat einrichten.

Dokumentation

Erste Schritte

Kurzanleitung

Installationsanweisungen

API-Generierungshandbuch

API-Starthandbuch

Weitere Ressourcen

ChatGPT-Integrationshandbuch

Dokumentation zum Datenbankkonnektor

Plugin-Dokumentation

Wie man baut

API-Generierung

Gateway verwendet LLM-Modelle, um Ihre API-Konfiguration zu generieren. Führen Sie die folgenden Schritte aus:

Wählen Sie einen unserer unterstützten KI-Anbieter:

OpenAI und alle OpenAI-kompatiblen Anbieter

Google Gemini bietet eine großzügige kostenlose Version . Einen API-Schlüssel erhalten Sie im Google AI Studio:

Nach der Anmeldung können Sie im API-Bereich von AI Studio einen API-Schlüssel erstellen. Die kostenlose Version beinhaltet eine großzügige monatliche Token-Zuteilung und ermöglicht Ihnen so den Zugriff für Entwicklungs- und Testzwecke.

Konfigurieren Sie die Autorisierung des KI-Anbieters. Legen Sie für Google Gemini einen API-Schlüssel fest.

Führen Sie den Erkennungsbefehl aus:

Viel Spaß beim Generierungsprozess:

Überprüfen Sie die generierte Konfiguration in

gateway.yaml:

Ausführen der API

Lokal ausführen

Docker Compose

MCP-Protokollintegration

Gateway implementiert das MCP-Protokoll für eine nahtlose Integration mit Claude und anderen Tools. Detaillierte Einrichtungsanweisungen finden Sie in unserem Claude-Integrationshandbuch.

Um das MCP-Tool zu Claude Desktop hinzuzufügen, passen Sie einfach Claudes Konfiguration an:

Fahrplan

Änderungen sind jederzeit möglich, und die Roadmap hängt stark vom Nutzerfeedback ab. Aktuell planen wir folgende Features:

Datenbank und Konnektivität

🗄️ Erweiterte Datenbankintegrationen – Redshift, S3 (Iceberg und Parquet), Oracle DB, Microsoft SQL Server, Elasticsearch

🔑 SSH-Tunneling – Möglichkeit, Jumphost oder SSH-Bastion zum Tunneln von Verbindungen zu verwenden

Erweiterte Funktionalität

🔍 Erweiterte Abfragefunktionen – Komplexe Filtersyntax und Aggregatfunktionen als Parameter

🔐 Verbesserte MCP-Sicherheit – API-Schlüssel und OAuth-Authentifizierung

Plattformverbesserungen

📦 Schemaverwaltung – Automatisierte Schemaentwicklung und API-Versionierung

🚦 Erweitertes Verkehrsmanagement – Intelligente Ratenbegrenzung, Anforderungsdrosselung

✍️ Unterstützung für Schreibvorgänge – Einfüge- und Aktualisierungsvorgänge

Appeared in Searches

- Connecting Cursor to Oracle Database for Data Learning

- MCP server for PostgreSQL and MySQL database indexing and DDL queries

- System capable of integrating with ERP and other information system databases

- Google BigQuery cloud data warehouse service

- Connecting to Oracle DB and summarizing table details with schema, relationships, and associated components