다중 모델 어드바이저

(锵锵사인행)

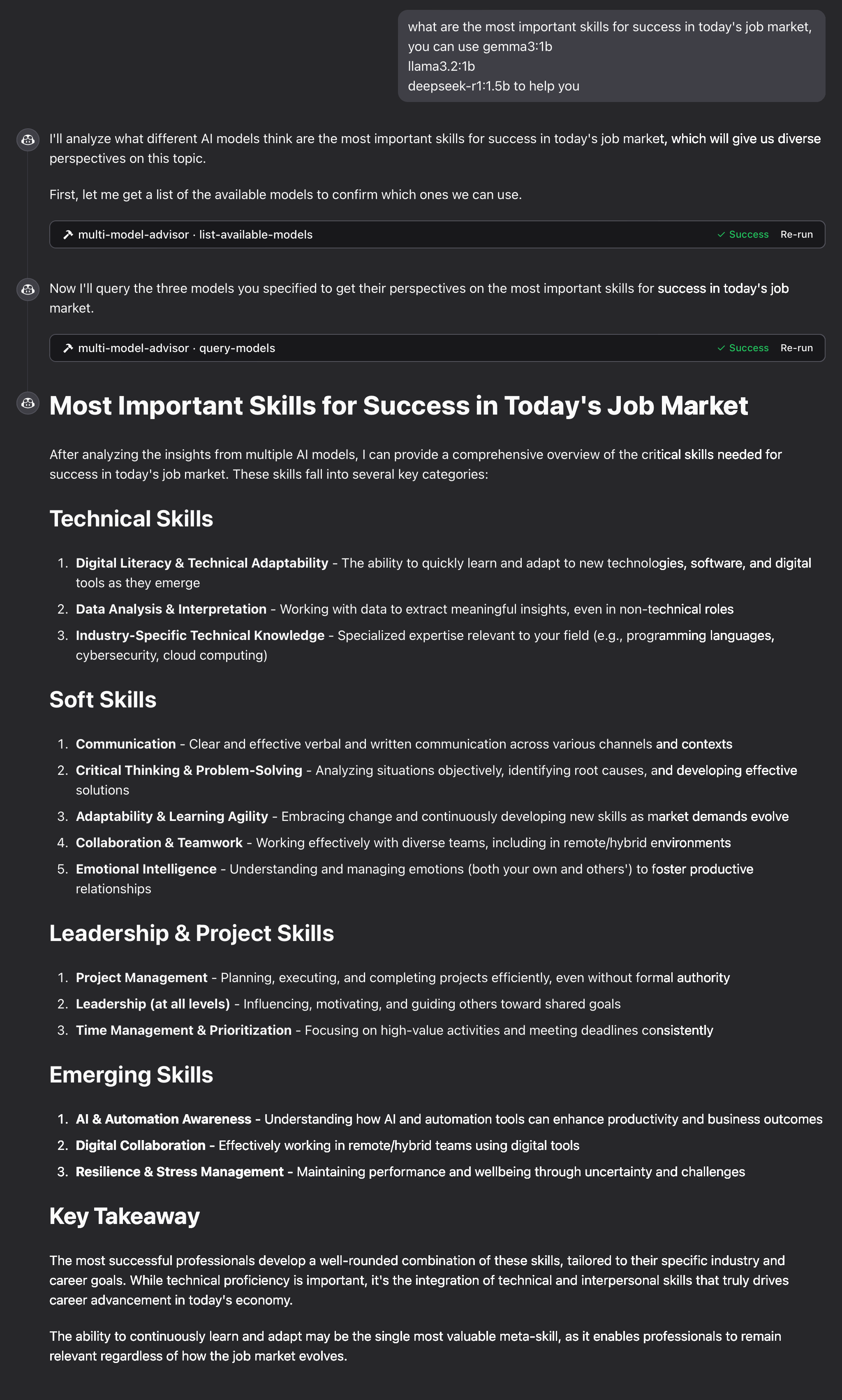

여러 Ollama 모델을 쿼리하고 그 응답을 결합하여 단일 질문에 대한 다양한 AI 관점을 제공하는 모델 컨텍스트 프로토콜(MCP) 서버입니다. 이를 통해 Claude가 여러 관점을 자신의 관점과 결합하여 더욱 포괄적인 답변을 제공할 수 있는 "자문 위원회" 방식이 구축됩니다.

지엑스피1

Related MCP server: MCP Ollama Server

특징

단일 질문으로 여러 Ollama 모델 쿼리

각 모델에 다른 역할/페르소나를 할당합니다.

시스템에서 사용 가능한 모든 Ollama 모델을 확인하세요

각 모델에 맞게 시스템 프롬프트를 사용자 정의합니다.

환경 변수를 통해 구성

데스크톱용 Claude와 완벽하게 통합

필수 조건

Node.js 16.x 이상

Ollama가 설치되고 실행 중입니다( Ollama 설치 참조)

데스크톱용 Claude(전체 자문 경험용)

설치

Smithery를 통해 설치

Smithery를 통해 Claude Desktop용 multi-ai-advisor-mcp를 자동으로 설치하려면:

수동 설치

이 저장소를 복제하세요:

git clone https://github.com/YuChenSSR/multi-ai-advisor-mcp.git cd multi-ai-advisor-mcp종속성 설치:

npm install프로젝트를 빌드하세요:

npm run build필요한 Ollama 모델을 설치하세요:

ollama pull gemma3:1b ollama pull llama3.2:1b ollama pull deepseek-r1:1.5b

구성

원하는 구성으로 프로젝트 루트에 .env 파일을 만듭니다.

데스크톱용 Claude에 연결

Claude for Desktop 구성 파일을 찾으세요.

MacOS:

~/Library/Application Support/Claude/claude_desktop_config.jsonWindows:

%APPDATA%\Claude\claude_desktop_config.json

파일을 편집하여 Multi-Model Advisor MCP 서버를 추가합니다.

/absolute/path/to/프로젝트 디렉토리의 실제 경로로 바꾸세요.데스크톱용 Claude를 다시 시작하세요

용법

Claude for Desktop에 연결하면 여러 가지 방법으로 Multi-Model Advisor를 사용할 수 있습니다.

사용 가능한 모델 목록

시스템에서 사용 가능한 모든 모델을 볼 수 있습니다.

이렇게 하면 설치된 모든 Ollama 모델이 표시되고 기본값으로 구성된 모델이 표시됩니다.

기본 사용법

Claude에게 다중 모델 자문을 사용해 달라고 요청하기만 하면 됩니다.

클로드는 모든 기본 모델을 쿼리하고 다양한 관점을 기반으로 합성된 응답을 제공합니다.

작동 원리

MCP 서버는 두 가지 도구를 제공합니다.

list-available-models: 시스템의 모든 Ollama 모델을 표시합니다.query-models: 질문을 사용하여 여러 모델을 쿼리합니다.

클로드에게 다중 모델 자문가에 관해 질문할 때:

Claude는

query-models도구를 사용하기로 결정했습니다.서버는 귀하의 질문을 여러 Ollama 모델로 전송합니다.

각 모델은 자신의 관점으로 대응합니다.

Claude는 모든 응답을 받고 포괄적인 답변을 종합합니다.

각 모델에는 서로 다른 "페르소나" 또는 역할이 할당되어 다양한 관점을 장려합니다.

문제 해결

올라마 연결 문제

서버가 Ollama에 연결할 수 없는 경우:

Ollama가 실행 중인지 확인하세요(

ollama serve).env 파일에서 OLLAMA_API_URL이 올바른지 확인하세요.

브라우저에서 http://localhost:11434에 접속하여 Ollama가 응답하는지 확인하세요.

모델을 찾을 수 없습니다

모델이 사용 불가능하다고 보고된 경우:

ollama pull <model-name>사용하여 모델을 끌어왔는지 확인하세요.ollama list사용하여 정확한 모델 이름을 확인하세요list-available-models도구를 사용하여 사용 가능한 모든 모델을 확인하세요.

Claude가 MCP 도구를 표시하지 않음

Claude에 도구가 나타나지 않는 경우:

구성을 업데이트한 후 Claude를 다시 시작했는지 확인하세요.

claude_desktop_config.json의 절대 경로가 올바른지 확인하세요.

오류 메시지는 Claude의 로그에서 확인하세요.

램이 부족해요

일부 관리자의 AI 모델이 더 큰 모델을 선택했지만, 이를 실행할 메모리가 부족할 수 있습니다. 더 작은 모델을 지정하거나( 기본 사용 방법 참조) 메모리를 업그레이드해 보세요.

특허

MIT 라이센스

자세한 내용은 이 프로젝트 저장소 의 LICENSE 파일을 참조하세요.

기여하다

기여를 환영합니다! 풀 리퀘스트를 제출해 주세요.