Asesor Multimodelo

(El hombre que lleva el bolso de compras)

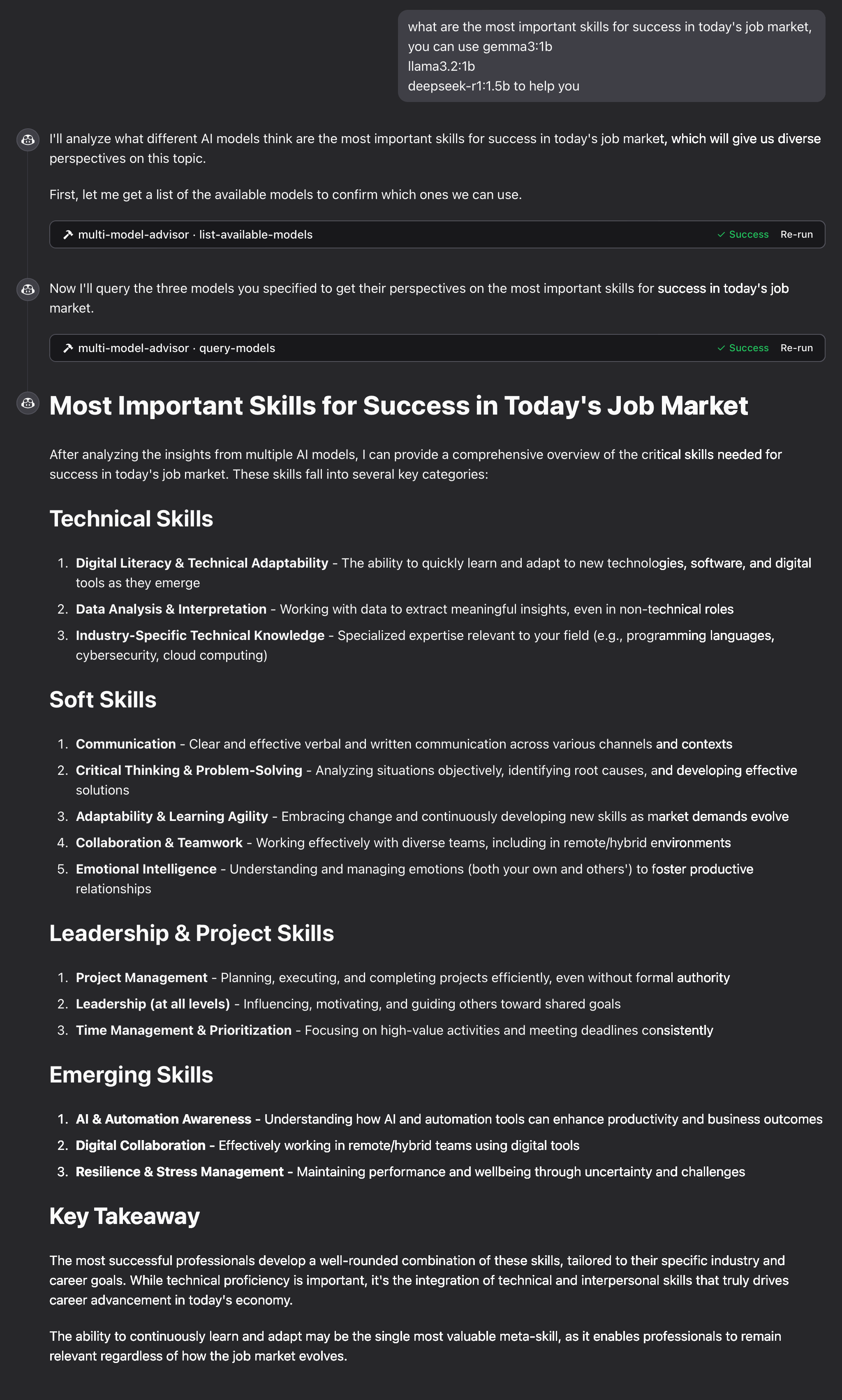

Un servidor de Protocolo de Contexto de Modelo (MCP) que consulta múltiples modelos de Ollama y combina sus respuestas, proporcionando diversas perspectivas de IA sobre una misma pregunta. Esto crea un enfoque de "consejo de asesores" donde Claude puede sintetizar múltiples puntos de vista junto con los suyos para proporcionar respuestas más completas.

Related MCP server: MCP Ollama Server

Características

Consultar múltiples modelos de Ollama con una sola pregunta

Asignar diferentes roles/personajes a cada modelo

Ver todos los modelos de Ollama disponibles en su sistema

Personalice las indicaciones del sistema para cada modelo

Configurar mediante variables de entorno

Se integra perfectamente con Claude for Desktop

Prerrequisitos

Node.js 16.x o superior

Ollama instalado y funcionando (ver Instalación de Ollama )

Claude para escritorio (para una experiencia de asesoramiento completa)

Instalación

Instalación mediante herrería

Para instalar multi-ai-advisor-mcp para Claude Desktop automáticamente a través de Smithery :

Instalación manual

Clonar este repositorio:

git clone https://github.com/YuChenSSR/multi-ai-advisor-mcp.git cd multi-ai-advisor-mcpInstalar dependencias:

npm installConstruir el proyecto:

npm run buildInstalar los modelos Ollama necesarios:

ollama pull gemma3:1b ollama pull llama3.2:1b ollama pull deepseek-r1:1.5b

Configuración

Cree un archivo .env en la raíz del proyecto con la configuración deseada:

Conectarse a Claude para escritorio

Localice el archivo de configuración de Claude for Desktop:

MacOS:

~/Library/Application Support/Claude/claude_desktop_config.jsonVentanas:

%APPDATA%\Claude\claude_desktop_config.json

Edite el archivo para agregar el servidor MCP de Multi-Model Advisor:

Reemplace

/absolute/path/to/con la ruta real al directorio de su proyectoReiniciar Claude para escritorio

Uso

Una vez conectado a Claude for Desktop, puede utilizar el Asesor Multimodelo de varias maneras:

Lista de modelos disponibles

Puedes ver todos los modelos disponibles en tu sistema:

Esto mostrará todos los modelos de Ollama instalados e indicará cuáles están configurados como predeterminados.

Uso básico

Simplemente pídale a Claude que utilice el asesor multimodelo:

Claude cuestionará todos los modelos predeterminados y proporcionará una respuesta sintetizada basada en sus diferentes perspectivas.

Cómo funciona

El servidor MCP expone dos herramientas:

list-available-models: muestra todos los modelos de Ollama en su sistemaquery-models: Consulta múltiples modelos con una pregunta

Cuando le haces una pregunta a Claude refiriéndose al asesor multimodelo:

Claude decide utilizar la herramienta

query-modelsEl servidor envía tu pregunta a múltiples modelos de Ollama

Cada modelo responde con su perspectiva

Claude recibe todas las respuestas y sintetiza una respuesta completa.

A cada modelo se le puede asignar una “persona” o rol diferente, lo que fomenta diversas perspectivas.

Solución de problemas

Problemas de conexión de Ollama

Si el servidor no puede conectarse a Ollama:

Asegúrese de que Ollama se esté ejecutando (

ollama serve)Verifique que la OLLAMA_API_URL sea correcta en su archivo .env

Intente acceder a http://localhost:11434 en su navegador para verificar que Ollama esté respondiendo

Modelo no encontrado

Si un modelo se informa como no disponible:

Comprueba que has extraído el modelo usando

ollama pull <model-name>Verifique el nombre exacto del modelo usando

ollama listUtilice la herramienta de

list-available-modelspara ver todos los modelos disponibles

Claude no muestra las herramientas MCP

Si las herramientas no aparecen en Claude:

Asegúrese de haber reiniciado Claude después de actualizar la configuración

Verifique que la ruta absoluta en claude_desktop_config.json sea correcta

Mire los registros de Claude para ver los mensajes de error

La RAM no es suficiente

Es posible que los modelos de IA de algunos administradores hayan elegido modelos más grandes, pero no hay suficiente memoria para ejecutarlos. Puede intentar especificar un modelo más pequeño (consulte Uso básico ) o aumentar la memoria.

Licencia

Licencia MIT

Para obtener más detalles, consulte el archivo LICENCIA en este repositorio del proyecto.

Contribuyendo

¡Agradecemos sus contribuciones! No dude en enviar una solicitud de incorporación de cambios.