マルチモデルアドバイザー

(锵锵四人行)

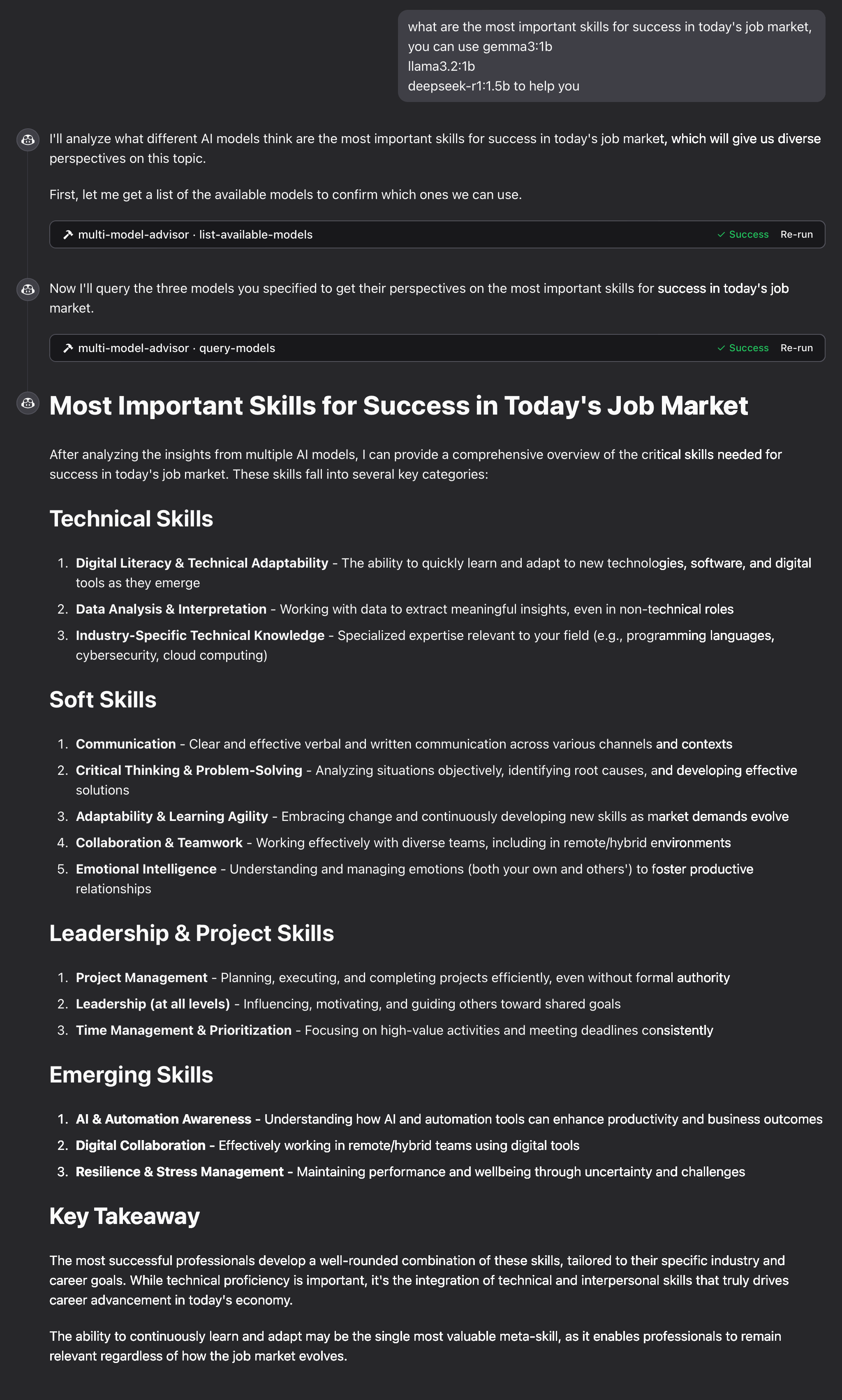

モデルコンテキストプロトコル(MCP)サーバーは、複数のOllamaモデルにクエリを実行し、それらの応答を統合することで、単一の質問に対して多様なAIの視点を提供します。これにより、「アドバイザー評議会」のようなアプローチが実現し、Claudeは自身の視点に加えて複数の視点を統合することで、より包括的な回答を提供できます。

Related MCP server: MCP Ollama Server

特徴

1つの質問で複数のOllamaモデルをクエリする

各モデルに異なる役割/ペルソナを割り当てる

システムで利用可能なすべてのOllamaモデルを表示します

各モデルのシステムプロンプトをカスタマイズする

環境変数で設定する

Claude for Desktopとシームレスに統合

前提条件

Node.js 16.x 以上

Ollama がインストールされ、実行中である ( Ollama のインストールを参照)

Claude for Desktop(完全なアドバイザリエクスペリエンスを実現)

インストール

Smithery経由でインストール

Smithery経由で Claude Desktop 用の multi-ai-advisor-mcp を自動的にインストールするには:

手動インストール

このリポジトリをクローンします:

git clone https://github.com/YuChenSSR/multi-ai-advisor-mcp.git cd multi-ai-advisor-mcp依存関係をインストールします:

npm installプロジェクトをビルドします。

npm run build必要な Ollama モデルをインストールします。

ollama pull gemma3:1b ollama pull llama3.2:1b ollama pull deepseek-r1:1.5b

構成

希望する構成でプロジェクト ルートに.envファイルを作成します。

デスクトップ版Claudeに接続

Claude for Desktop の構成ファイルを見つけます。

MacOS:

~/Library/Application Support/Claude/claude_desktop_config.jsonWindows:

%APPDATA%\Claude\claude_desktop_config.json

ファイルを編集して、Multi-Model Advisor MCP サーバーを追加します。

/absolute/path/to/プロジェクトディレクトリへの実際のパスに置き換えます。デスクトップ版のClaudeを再起動

使用法

Claude for Desktop に接続すると、Multi-Model Advisor をいくつかの方法で使用できるようになります。

利用可能なモデルの一覧

システムで利用可能なすべてのモデルを確認できます。

これにより、インストールされているすべての Ollama モデルが表示され、どれがデフォルトとして設定されているかが示されます。

基本的な使い方

Claude にマルチモデル アドバイザーを使用するように依頼するだけです。

Claude はすべてのデフォルト モデルを照会し、さまざまな観点に基づいて統合された応答を提供します。

仕組み

MCP サーバーは次の 2 つのツールを公開します。

list-available-models: システム上のすべてのOllamaモデルを表示しますquery-models: 質問で複数のモデルを照会する

マルチモデルアドバイザーに関してクロードに質問すると、次のようになります。

クロードは

query-modelsツールを使うことにしたサーバーはあなたの質問を複数のOllamaモデルに送信します

各モデルはそれぞれの視点で反応する

クロードはすべての回答を受け取り、包括的な回答をまとめる

各モデルには異なる「ペルソナ」または役割を割り当てることができるため、多様な視点が促進されます。

トラブルシューティング

Ollama 接続の問題

サーバーがOllamaに接続できない場合:

Ollama が実行中であることを確認する (

ollama serve).env ファイル内の OLLAMA_API_URL が正しいことを確認してください

ブラウザでhttp://localhost:11434にアクセスして、Ollama が応答していることを確認してください。

モデルが見つかりません

モデルが利用できないと報告された場合:

ollama pull <model-name>を使用してモデルをプルしたことを確認します。ollama listを使用して正確なモデル名を確認する利用可能なすべてのモデルを表示するには、

list-available-modelsツールを使用してください。

クロードがMCPツールを表示しない

Claude にツールが表示されない場合:

設定を更新した後、Claudeを再起動してください。

claude_desktop_config.json の絶対パスが正しいことを確認してください

クロードのログでエラーメッセージを確認する

RAMが足りない

一部のマネージャーのAIモデルでは、より大きなモデルが選択されている可能性がありますが、実行に必要なメモリが不足しています。より小さなモデルを指定するか(基本的な使用方法を参照)、メモリをアップグレードしてみてください。

ライセンス

MITライセンス

詳細については、このプロジェクトリポジトリのLICENSEファイルを参照してください。

貢献

貢献を歓迎します!お気軽にプルリクエストを送信してください。