🚀 ⚡️ servidor k6-mcp

Una implementación de servidor de Protocolo de contexto de modelo (MCP) para ejecutar pruebas de carga k6.

✨ Características

Integración sencilla con el marco del Protocolo de Contexto de Modelo

Compatibilidad con duraciones de pruebas personalizadas y usuarios virtuales (VU)

API fácil de usar para ejecutar pruebas de carga k6

Configurable a través de variables de entorno

Salida de ejecución de pruebas en tiempo real

Related MCP server: JMeter MCP Server

🔧 Requisitos previos

Antes de comenzar, asegúrese de tener instalado lo siguiente:

Python 3.12 o superior

Herramienta de prueba de carga k6 ( Guía de instalación )

Gestor de paquetes uv ( Guía de instalación )

📦 Instalación

Clonar el repositorio:

Instale las dependencias necesarias:

Configurar variables de entorno (opcional): Cree un archivo

.enven la raíz del proyecto:

🚀 Primeros pasos

Cree un script de prueba k6 (por ejemplo,

test.js):

Configure el servidor MCP utilizando las siguientes especificaciones en su cliente MCP favorito (Claude Desktop, Cursor, Windsurf y más):

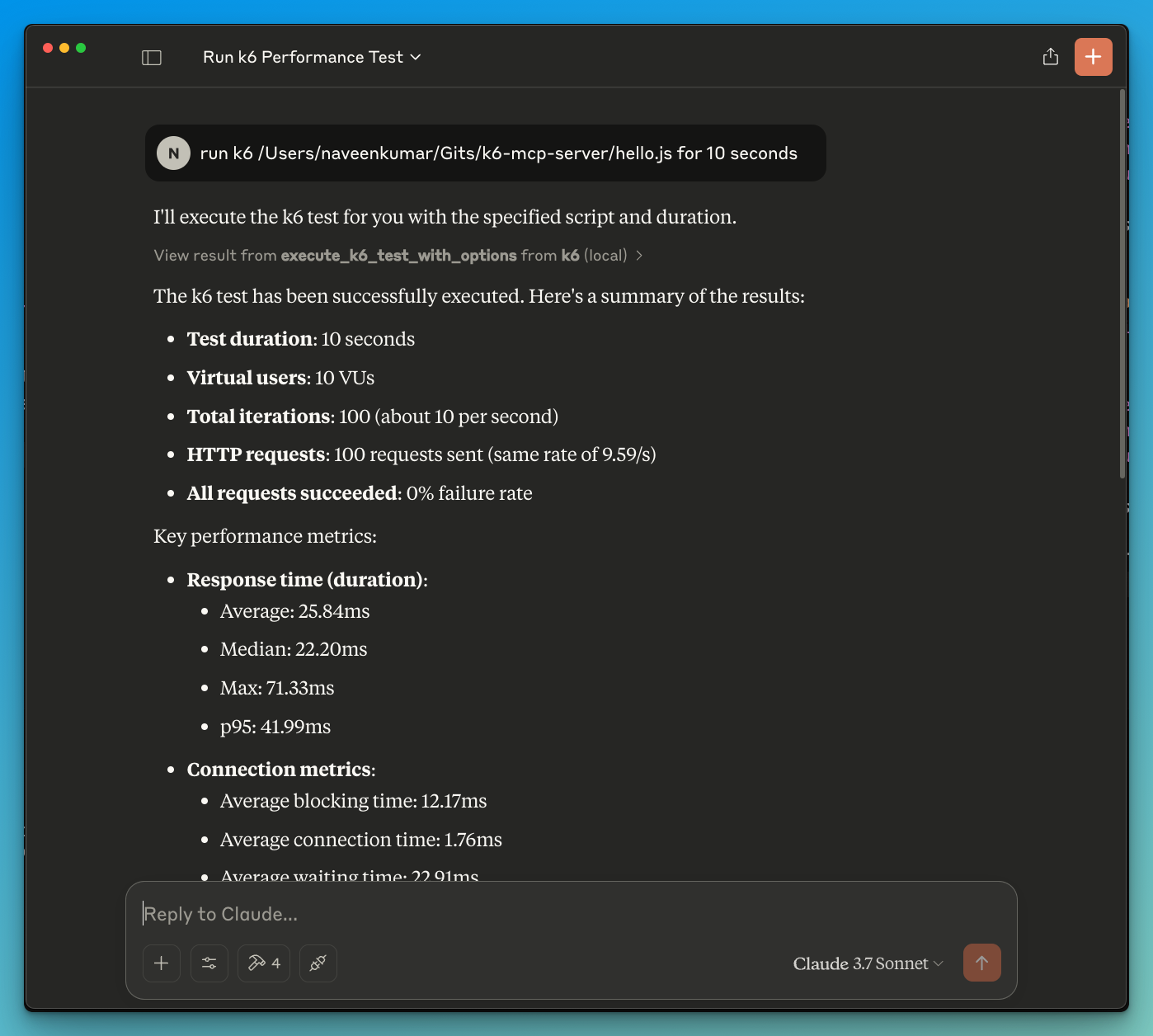

Ahora, pídale al LLM que ejecute la prueba; por ejemplo,

run k6 test for hello.js. El servidor k6 mcp utilizará una de las siguientes herramientas para iniciar la prueba.

execute_k6_test: ejecuta una prueba con opciones predeterminadas (duración de 30 s, 10 VU)execute_k6_test_with_options: Ejecutar una prueba con duración y VU personalizadas

Referencia de API

Ejecutar prueba K6

Ejecutar prueba K6 con opciones personalizadas

🤝 Contribuyendo

¡Agradecemos sus contribuciones! No dude en enviar una solicitud de incorporación de cambios.

📄 Licencia

Este proyecto está licenciado bajo la licencia MIT: consulte el archivo de LICENCIA para obtener más detalles.