Demostraciones de LlamaIndex MCP

Este repositorio demuestra cómo crear un servidor MCP usando LlamaCloud y cómo usar LlamaIndex como cliente MCP.

LlamaCloud como servidor MCP

Para proporcionar un servidor MCP local que pueda ser utilizado por un cliente como Claude Desktop, puede usar mcp-server.py . Esto le permitirá proporcionar una herramienta que, mediante RAG, le proporcionará a Claude información privada actualizada para responder preguntas. Puede proporcionar tantas herramientas como desee.

Configura tu índice de LlamaCloud

Obtenga una cuenta de LlamaCloud

Cree un nuevo índice con la fuente de datos que desee. En nuestro caso, usamos Google Drive y proporcionamos un subconjunto de la documentación de LlamaIndex como fuente. También puede subir documentos directamente al índice si solo desea probarlo.

Obtenga una clave API de la interfaz de usuario de LlamaCloud

Configurar su servidor MCP

Clonar este repositorio

Cree un archivo

.envy agregue dos variables de entorno:LLAMA_CLOUD_API_KEY: la clave API que obtuviste en el paso anteriorOPENAI_API_KEY: Una clave API de OpenAI. Se utiliza para ejecutar la consulta RAG. Puede usar cualquier otro LLM si no desea usar OpenAI.

Ahora veamos el código. Primero, se instancia un servidor MCP:

Luego define tu herramienta usando el decorador @mcp.tool() :

Nuestra herramienta se llama llama_index_documentation ; instancia un índice de LlamaCloud llamado mcp-demo-2 y lo utiliza como motor de consultas para responder a la consulta, incluyendo instrucciones adicionales en el mensaje. Encontrará instrucciones sobre cómo configurar su índice de LlamaCloud en la siguiente sección.

Finalmente, ejecuta el servidor:

Tenga en cuenta el transporte stdio , utilizado para comunicarse con Claude Desktop.

Configurar Claude Desktop

Instalar Claude Desktop

En la barra de menú, seleccione

Claude->Settings->Developer->Edit Config. Aparecerá un archivo de configuración que puede editar en su editor de texto preferido.Querrás que tu configuración se parezca a esto (asegúrate de reemplazar

$YOURPATHcon la ruta al repositorio):

Asegúrese de reiniciar Claude Desktop después de configurar el archivo.

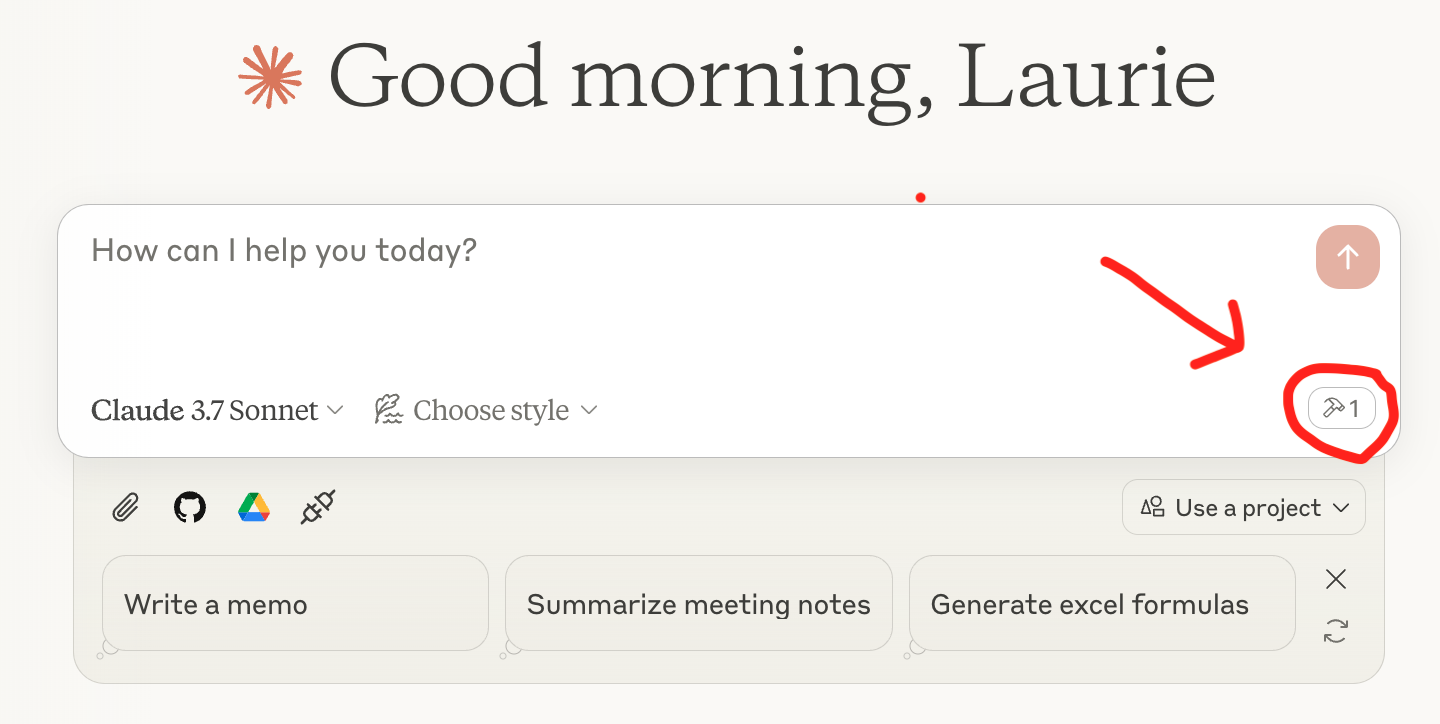

¡Ya está listo para consultar! Debería ver un icono de herramienta con su servidor debajo del cuadro de consulta en Claude Desktop, como este:

Related MCP server: Choose MCP Server

LlamaIndex como cliente MCP

LlamaIndex también cuenta con una integración de cliente MCP, lo que significa que puedes convertir cualquier servidor MCP en un conjunto de herramientas que un agente puede usar. Puedes ver esto en mcp-client.py , donde usamos BasicMCPClient para conectarnos a nuestro servidor MCP local.

Para simplificar la demostración, usamos el mismo servidor MCP que configuramos anteriormente. Normalmente, no se usaría MCP para conectar LlamaCloud a un agente de LlamaIndex; se usaría QueryEngineTool y se pasaría directamente al agente.

Configurar su servidor MCP

Para proporcionar un servidor MCP local que pueda ser utilizado por un cliente HTTP, necesitamos modificar ligeramente mcp-server.py para usar el método run_sse_async en lugar de run . Puedes encontrarlo en mcp-http-server.py .

Obtenga sus herramientas del servidor MCP

Crea un agente y haz una pregunta

¡Listo! Ya puedes usar el agente para responder preguntas desde tu índice de LlamaCloud.