Bifrost - VSCode 開発ツール MCP サーバー

このVS Code拡張機能は、VSCodeの強力な開発ツールと言語機能をAIツールに公開するモデルコンテキストプロトコル(MCP)サーバーを提供します。MCPプロトコルをサポートするAIコーディングアシスタントを使用する際に、高度なコードナビゲーション、分析、操作機能を実現します。

特徴

言語サーバー統合: サポートされている言語の VSCode の言語サーバー機能にアクセスします。

コードナビゲーション: 参照、定義、実装などを検索

シンボル検索: ワークスペース全体でシンボルを検索します

コード分析: セマンティックトークン、ドキュメントシンボル、型情報を取得します

スマート選択: 意味的な選択範囲を使用してインテリジェントなコード選択を行う

コードアクション: リファクタリングの提案とクイックフィックスにアクセス

HTTP/SSE サーバー: MCP 互換の HTTP サーバーを介して言語機能を公開します。

AIアシスタント統合: MCPプロトコルをサポートするAIアシスタントと連携可能

Related MCP server: Notion Knowledge Base MCP Server

使用法

クライン設置

ステップ1. Supergatewayをインストールする

ステップ2. clineにconfigを追加する

ステップ3. 赤く表示されますが、正常に動作しているようです

Windows 構成

Mac/Linux 設定

Rooコードのインストール

ステップ1: SSE構成をグローバルまたはプロジェクトベースのMCP構成に追加する

カーソルをインストールして使用するには、このビデオをご覧ください。より良い結果を得るために、.cursorrules ファイルで使用できるサンプルルールも提供しています。

カーソルの新しいバージョンについては、このコードを使用してください

複数のプロジェクトのサポート

複数のプロジェクトで作業する場合、各プロジェクトに専用のMCPサーバーエンドポイントとポートを設定できます。これは、複数のVS Codeウィンドウを開いている場合や、言語サーバー機能を必要とする複数のプロジェクトで作業している場合に便利です。

プロジェクト構成

プロジェクト ルートにbifrost.config.jsonファイルを作成します。

サーバーはこの構成を使用して次の操作を行います。

プロジェクト固有のエンドポイントを作成します(例:

http://localhost:5642/my-project/sse)AIアシスタントにプロジェクト情報を提供する

プロジェクトごとに専用のポートを使用する

プロジェクト サービスを他の実行中のインスタンスから分離する

構成例

バックエンド API プロジェクト:

フロントエンド Web アプリ:

ポート構成

複数の VS Code インスタンスが実行されている場合に競合を回避するには、各プロジェクトで独自のポートを指定する必要があります。

bifrost.config.jsonのportフィールドは、サーバーが使用するポートを決定します。ポートが指定されていない場合は、下位互換性のためにデフォルトで8008が使用されます。

異なるプロジェクトに異なるポートを選択して、同時に実行できるようにします。

構成されたポートがすでに使用されている場合、サーバーの起動は失敗し、次のいずれかが必要になります。

ポートを解放する

設定でポートを変更する

そのポートを使用している他のVS Codeインスタンスを閉じます

プロジェクト固有のエンドポイントへの接続

プロジェクト固有のエンドポイントとポートを使用するように AI アシスタントの構成を更新します。

下位互換性

bifrost.config.jsonが存在しない場合は、サーバはデフォルトの設定を使用します。

ポート: 8008

SSEエンドポイント:

http://localhost:8008/sseメッセージエンドポイント:

http://localhost:8008/message

これにより、既存の構成およびツールとの互換性が維持されます。

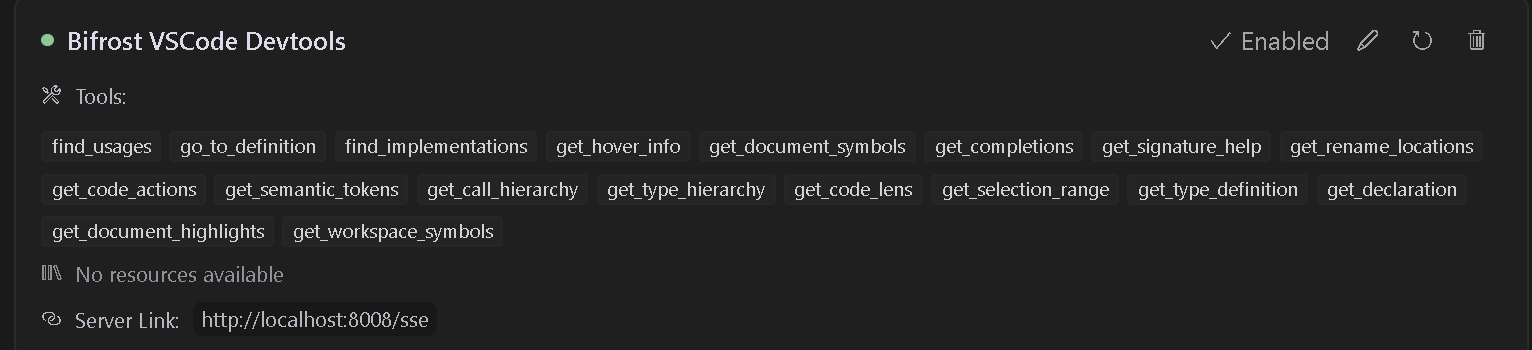

利用可能なツール

この拡張機能は、次のような多くの VSCode 言語機能へのアクセスを提供します。

find_usages : すべてのシンボル参照を検索します。

go_to_definition : シンボル定義に即座にジャンプします。

find_implementations : インターフェース/抽象メソッドの実装を検出します。

get_hover_info : ホバー時に豊富なシンボルドキュメントを取得します。

get_document_symbols : ファイル内のすべてのシンボルのアウトラインを作成します。

get_completions : コンテキストに応じた自動補完。

get_signature_help : 関数パラメータのヒントとオーバーロード。

get_rename_locations : プロジェクト全体のシンボルの名前を安全に変更します。

get_code_actions : クイック修正、リファクタリング、および改善。

get_semantic_tokens : 強調表示データが強化されました。

get_call_hierarchy : 着信/発信通話の関係を確認します。

get_type_hierarchy : クラスとインターフェースの継承を視覚化します。

get_code_lens : インライン インサイト (参照、テストなど)。

get_selection_range : コード ブロックのスマートな選択範囲の拡張。

get_type_definition : 基礎となる型定義にジャンプします。

get_declaration : シンボル宣言に移動します。

get_document_highlights : シンボルのすべての出現を強調表示します。

get_workspace_symbols : ワークスペース全体のシンボルを検索します。

要件

Visual Studio Code バージョン 1.93.0 以上

作業する言語に適した言語拡張機能(例:C# ファイルの場合は C# 拡張機能)

インストール

VS Codeマーケットプレイスからこの拡張機能をインストールします

開発に必要な言語固有の拡張機能をインストールします

VS Codeでプロジェクトを開きます

使用法

拡張機能を有効にすると、MCPサーバーが自動的に起動します。AIアシスタントがこのサーバーを使用するように設定するには、以下の手順に従ってください。

サーバーはデフォルトでポート8008で実行されます

MCP 対応の AI アシスタントを次の接続先に設定する:

SSEエンドポイント:

http://localhost:8008/sseメッセージエンドポイント:

http://localhost:8008/message

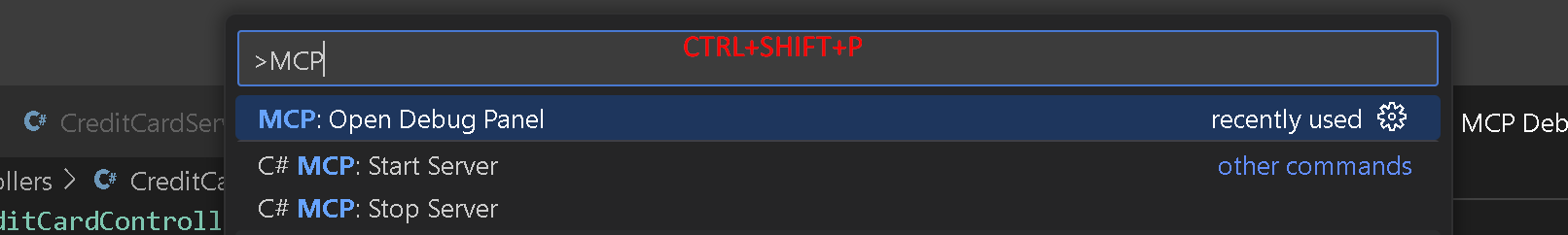

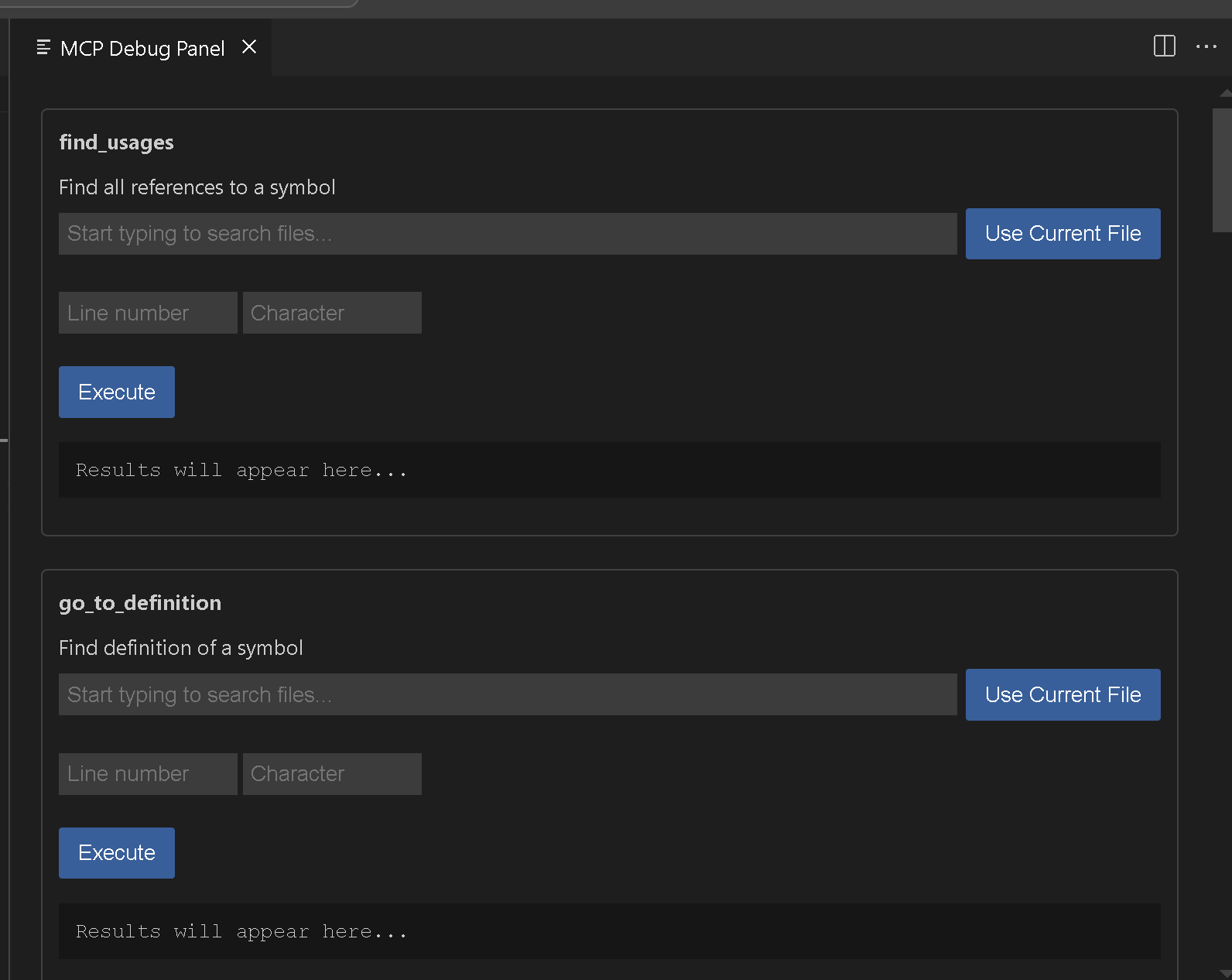

利用可能なコマンド

Bifrost MCP: Start Server- ポート 8008 で MCP サーバーを手動で起動しますBifrost MCP: Start Server on port- 指定されたポートで MCP サーバを手動で起動しますBifrost MCP: Stop Server- 実行中の MCP サーバーを停止しますBifrost MCP: Open Debug Panel- デバッグパネルを開いて利用可能なツールをテストします

スターの歴史

ツールの使用例

参考文献を探す

ワークスペースシンボル検索

デバッグ

MCP: Open Debug Panelコマンドを使用する

トラブルシューティング

問題が発生した場合:

プロジェクトに適切な言語拡張機能がインストールされていることを確認してください

VSCodeでプロジェクトが正しく読み込まれていることを確認します

システムでポート8008が利用可能であることを確認します

VSCodeの出力パネルでエラーメッセージを確認します

貢献

機能を追加したい場合は、 Vscodesコマンドをご利用ください。名前の変更など、まだいくつか必要なコマンドがあると思います。GitHubリポジトリに問題やプルリクエストをお気軽にご提出ください。

ライセンス

この拡張機能は、APGL-3.0 ライセンスに基づいてライセンスされます。