ZenML用MCPサーバー

このプロジェクトは、 ZenML API と対話するためのモデル コンテキスト プロトコル (MCP)サーバーを実装します。

MCPとは何ですか?

モデルコンテキストプロトコル(MCP)は、アプリケーションが大規模言語モデル(LLM)にコンテキストを提供する方法を標準化するオープンプロトコルです。これは「AIアプリケーション用のUSB-Cポート」のような役割を果たし、AIモデルをさまざまなデータソースやツールに接続するための標準化された方法を提供します。

MCP は次のようなクライアント サーバー アーキテクチャに従います。

MCP ホスト: Claude Desktop のようなプログラムや、MCP を介してデータにアクセスする IDE

MCPクライアント: サーバーとの1:1接続を維持するプロトコルクライアント

MCP サーバー: 標準化されたプロトコルを通じて特定の機能を公開する軽量プログラム

ローカル データ ソース: MCP サーバーが安全にアクセスできるコンピューターのファイル、データベース、サービス

リモート サービス: MCP サーバーが接続できるインターネット経由で利用可能な外部システム

Related MCP server: MCP Database Server

ZenMLとは何ですか?

ZenMLは、MLおよびAIパイプラインの構築と管理のためのオープンソースプラットフォームです。データ、モデル、実験を管理するための統合インターフェースを提供します。

詳細については、 ZenML の Web サイトとドキュメントを参照してください。

特徴

サーバーは、ZenML サーバーからコア読み取り機能にアクセスするための MCP ツールを提供し、次のライブ情報を取得する方法を提供します。

ユーザー

スタック

パイプライン

パイプラインの実行

パイプラインのステップ

サービス

スタックコンポーネント

フレーバー

パイプライン実行テンプレート

スケジュール

アーティファクト(データそのものではなく、データ アーティファクトに関するメタデータ)

サービスコネクタ

ステップコード

ステップログ(ステップがクラウドベースのスタックで実行された場合)

また、新しいパイプラインの実行をトリガーすることもできます (実行テンプレートが存在する場合)。

注: これはベータ版/試験的なリリースです。この統合がどのように利用されるかはまだ調査中です。皆様からのフィードバックやご提案をお待ちしております。Slack

使い方

前提条件

ZenML Cloudサーバーへのアクセスが必要です。お持ちでない場合は、 ZenML Cloudで無料トライアルにご登録ください。

また、 uvローカルにインストールしておく必要があります。詳細については、 uvをご覧ください。インストーラースクリプト、またはMacの場合はbrew経由でのインストールをお勧めします。

このリポジトリをローカルのどこかにクローンする必要もあります。

MCP設定ファイル

MCP設定ファイルは、MCPクライアントにMCPサーバーへの接続方法を指示するJSONファイルです。MCPクライアントによって、この設定ファイルの利用方法や指定方法が異なります。よく使用されるMCPクライアントはClaude DesktopとCursorです。これらのインストール手順は以下に記載しています。

ZenML MCP サーバーを次の形式で指定する必要があります。

置き換える必要があるダミー値は 4 つあります。

ローカルにインストールされた

uvへのパス (上記のパスは、brew経由でインストールした場合の Mac 上のパスです)zenml_server.pyファイルへのパス(MCP サーバーに接続する際に実行されるファイルです)。このファイルはリポジトリのルートディレクトリにあります。このファイルへの正確なフルパスを指定する必要があります。ZenMLサーバーのURL(これはZenMLサーバーのURLです。ZenML Cloud UIで確認できます)。https

https://d534d987a-zenml.cloudinfra.zenml.ioのような形式になります。ZenML サーバー API キー (これは ZenML サーバーの API キーです。これは ZenML Cloud UI で確認するか、作成方法についてはこれらのドキュメントをお読みください。ZenML MCP サーバーでは、サービス アカウントを使用することをお勧めします。)

MCP サーバーの Python ファイルを実行する方法は自由に変更できますが、環境と依存関係のインストールが自動的に処理されるため、 uvを使用するのがおそらく最も簡単なオプションです。

Claude Desktopで使用するためのインストール

Claude Desktopがインストールされている必要があります。

Claude Desktopをインストールして起動したら、「設定」メニューを開き、「開発」タブをクリックします。「設定を編集」ボタンをクリックするとファイルエクスプローラーが開き、設定ファイルの場所が表示されます。

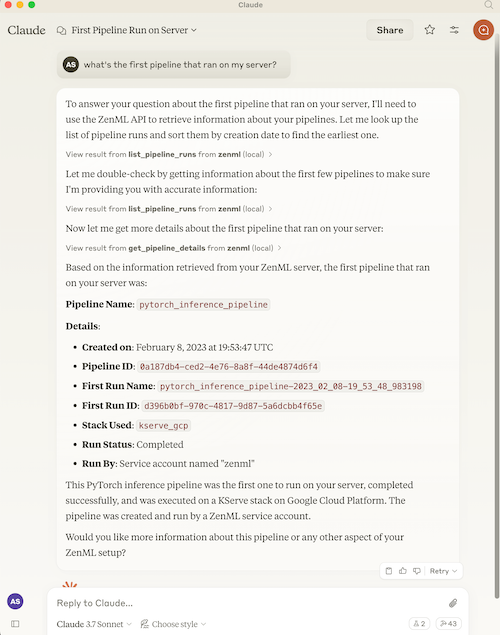

上記の(適切に入力された)設定ファイルの内容を、ファイルエクスプローラーに表示されるJSONファイルに貼り付けてください。その後、Claude Desktopを再起動すると、新しい設定が適用されます。開発者設定メニューにZenMLサーバーが表示されるはずです。Claudeとチャットすると、アクセスを許可した新しいツールがすべて使用されるようになります。

オプション: ZenMLツールの出力表示の改善

ZenMLツールの結果を快適にご利用いただくために、Claudeの設定でJSONレスポンスをより読みやすい形式で表示することができます。Claude Desktopで「設定」→「プロフィール」に移動し、「Claudeがレスポンスで考慮する個人設定は?」セクションに、次のような内容(またはそのままの表現)を追加してください。

これにより、Claude は ZenML ツールの出力をマークダウン テーブルとしてフォーマットするようになり、情報が読みやすく理解しやすくなります。

カーソル使用のためのインストール

Cursorをインストールする必要があります。

Cursor は Claude Desktop とは少し異なり、リポジトリごとに設定ファイルを指定します。つまり、複数のリポジトリで ZenML MCP サーバーを使用する場合は、それぞれのリポジトリで設定ファイルを指定する必要があります。

単一のリポジトリ用に設定するには、次の手順が必要です。

リポジトリのルートに

.cursorフォルダを作成します。その中に、上記の内容を含む

mcp.jsonファイルを作成します。カーソル設定に移動し、ZenML サーバーをクリックして「有効」にします。

私たちの経験では、動作しているにもかかわらず赤いエラーインジケーターが表示されることがあります。カーソルチャットウィンドウでチャットしてみると、ZenMLツールにアクセスできるかどうかがわかります。