Tecton MCP サーバーとカーソルのルール

TectonのCo-Pilotは、MCPサーバーとカーソルルールで構成されています。詳細については、こちらのブログをご覧ください。

ℹ️情報: このガイドでは、このリポジトリを使用して Tecton MCP サーバーを設定し、Tecton を使用して機能を開発するときに使用する機能リポジトリを構成する方法について説明します。

目次

Related MCP server: Jenkins MCP

クイックスタート

このリポジトリをローカル マシンにクローンします。

git clone https://github.com/tecton-ai/tecton-mcp.git cd tecton-mcp pwd**注:**リポジトリをクローンしたディレクトリへのパスは、以下の手順では

<path-to-your-local-clone>と表記します。フルパスは、最後にpwdコマンドを実行することで確認できます。uv パッケージ マネージャーをインストールします。

brew install uv次のコマンドを実行してインストールを確認します。

<path-to-your-local-clone>、手順1でリポジトリをクローンしたパスに置き換えます。MCP_SMOKE_TEST=1 uv --directory <path-to-your-local-clone> run mcp run src/tecton_mcp/mcp_server/server.pyコマンドはエラーなしで終了し、

MCP_SMOKE_TEST is set. Exiting after initialization.のようなメッセージが出力されます。これは、ローカル設定が正しく動作していることを示します。Cursor は必要に応じて MCP サーバーをサブプロセスとして自動的に生成します。MCP サーバーで Cursor (またはその他の MCP クライアント) を設定します (以下を参照)

Tecton クラスターにログインします。

tecton login yourcluster.tecton.aiCursor を起動し、Cursor で Tecton の Co-Pilot を使用して機能の開発を始めましょう。

テクトンMCPツール

Tecton MCP サーバーは、MCP クライアント (Cursor など) で使用できる次のツールを公開します。

ツール名 | 説明 |

| ベクターデータベースを使用して、関連するTectonコード例を検索します。新しいTectonコードを書く前に使用パターンを見つけるのに役立ちます。 |

| クエリに基づいてTectonドキュメントのスニペットを取得します。Tectonの公式ドキュメントから直接コンテキストを提供します。 |

| 利用可能なすべてのクラスと関数を含む、完全なTecton SDKリファレンスを取得します。SDKの概要を把握したい場合にご利用ください。 |

| 指定されたクラスまたは関数のリストのTecton SDKリファレンスを取得します。特定のSDKコンポーネントに関する情報を取得するのに最適です。 |

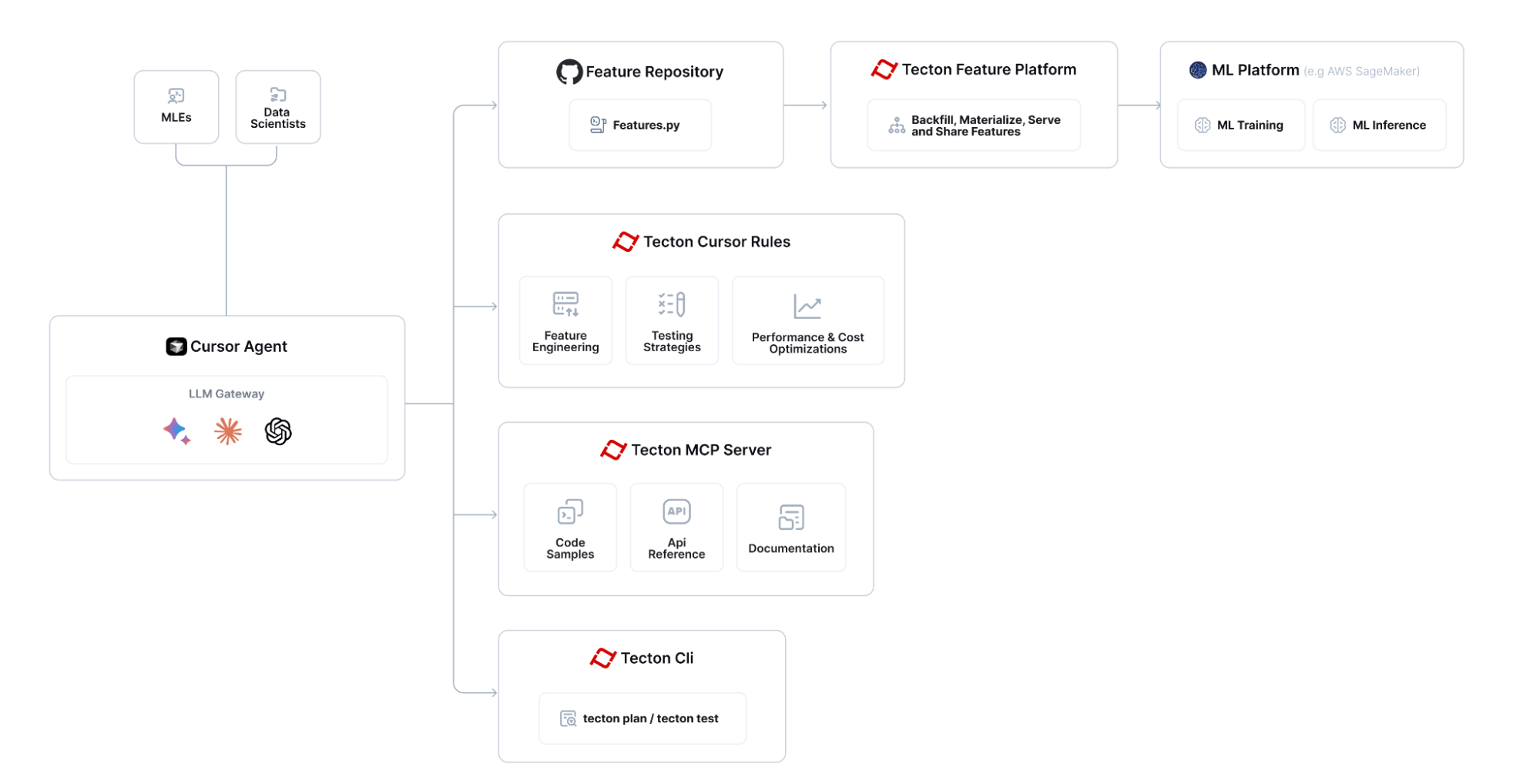

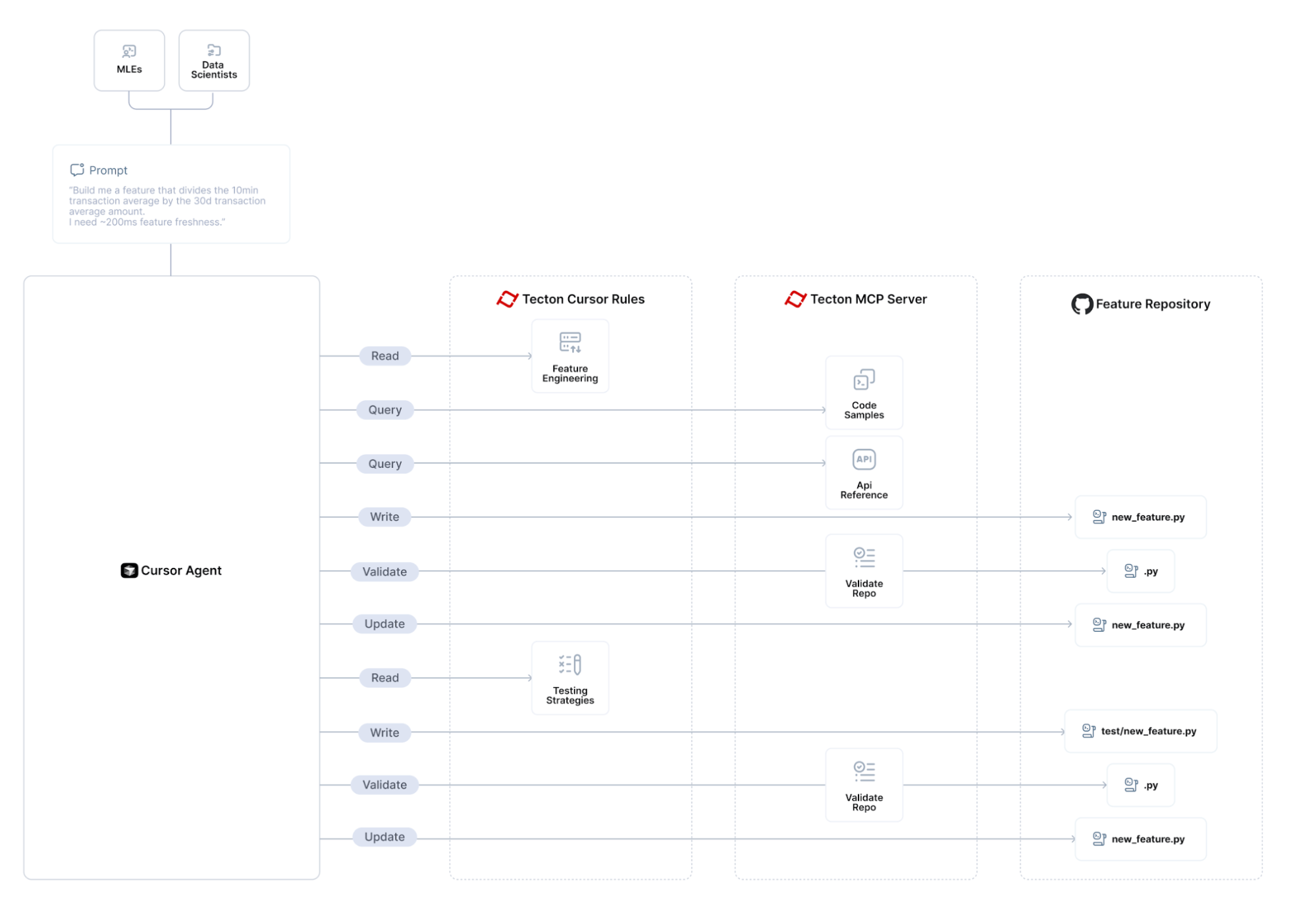

建築

Tecton MCP は、Cursor などの LLM 対応エディターと統合して、ツールベースのコンテキストと機能エンジニアリングの支援を提供します。

Tecton MCP を使用して機能を構築するための全体的なフローは次のようになります。

カーソル付きTectonのセットアップ

以下はCursor 0.48以上でテストされています

カーソルでTecton MCPサーバーを構成する

カーソル設定 -> MCP に移動し、「新しいグローバル MCP サーバーを追加」ボタンをクリックすると、カーソルのmcp.jsonファイルが編集されます。Tecton を MCP サーバーとして追加します。以下の設定を出発点として使用できます。パス<path-to-your-local-clone> 、リポジトリをクローンしたディレクトリに合わせて変更してください。

カーソルルールを追加する

このリポジトリの.cursor/rulesから cursorrules を機能リポジトリの.cursor/rulesフォルダにコピーします。

テクトンログイン

Tecton クラスターにログインします。

推奨される法学修士課程

4 月 17 日現在、Cursor で最高のパフォーマンスを発揮した Tecton 機能エンジニアリング LLM のスタック ランク リストは次のとおりです。

オープンAI o3

ジェミニ 2.5 プロ エクスペディション (03-25)

ソネット3.7

カーソル <> Tecton MCP 統合が期待どおりに動作していることを確認します。

統合が期待どおりに機能することを確認するには、カーソル エージェントに次のような質問をして、Tecton MCP ツールが適切に呼び出されていることを確認します。

TectonのExamples IndexでBatchFeatureViewsについて、またStreamFeatureViewsとの違いについて教えてください。SDKリファレンスもご覧ください。

AI 支援による特徴量エンジニアリングを始めましょう :-)

これで、Cursor の機能リポジトリにアクセスし、Cursor に直接統合された Tecton の Co-Pilot を使い始めることができます。

統合を使用して新しい機能を構築する方法については、この Loom をご覧ください: https://www.loom.com/share/3658f665668a41d2b0ea2355b433c616

特定のTecton SDKバージョンの使用方法

このツール1.1.10デフォルトで、Tecton SDKの最新のプレリリース版に関するガイダンスを提供します。特定のリリース版Tecton(例: 1.0.34 )に合わせてツールを調整する必要がある場合は、以下の手順に従ってください。

pyproject.tomlpyproject.tomlを開き、既存の依存関係の行を置き換えます。

必要なバージョンを正確に入力してください。例:

既存のロックファイルを削除します。uv.lock

uv.lock依存関係グラフを記録するため、uv新しい Tecton バージョンを解決できるように、これを削除する必要があります。

クイックスタートセクションのステップ3 (

MCP_SMOKE_TEST=1 uv --directoryコマンド)を再実行して、ロックファイルを再生成します。(これにより、固定バージョンがMCP用の分離された環境にダウンロードされ、uv.lockが再作成されます。)新しい Tecton バージョンが MCP 仮想環境にロードされるように、Cursorを再起動します。

サポートされているバージョン:SDKを使用していますが、ドキュメントとSDKリファレンスのインデックスは、ピン留めしたバージョンと一致するようになります。

トラブルシューティング

カーソル <-> Tecton MCP サーバーの統合

「カーソル設定 -> MCP」で、カーソルに「tecton」が「有効」なMCPサーバーとして表示されていることを確認してください。「緑のドット」が表示されない場合は、MCPサーバーを診断モードで実行してください(下記参照)。

MCPを診断モードで実行する

Tecton MCPサーバーをデバッグするには、次のコマンドを実行します。 <path-to-your-local-clone> 、リポジトリをクローンした実際のパスに置き換えてください。

注: Tecton の MCP サーバーの起動には数秒かかります。これは、関連するコード スニペットの検索に使用する埋め込みモデルをメモリに読み込むためです。

MCP インスペクタが起動して実行中であることが標準出力に表示されるまで数秒待ってから、出力された URL ( http://localhost:5173など) にアクセスします。

「接続」をクリックし、ツールの一覧を表示します。Tecton MCP Serverツールが表示され、クエリを実行できるようになります。

リソース

ライセンス

このプロジェクトはMIT ライセンスに基づいてライセンスされています。